INTRODUCCIÓN

El incremento actual de la frecuencia y la fuerza destructora de eventos hidrometeorológicos extremos en Cuba, y sus principales manifestaciones, como son: inundaciones costeras por intensas lluvias y por penetraciones del mar, y las afectaciones por fuertes vientos (Serrano y otros, 2014) han contribuido a que la dirección del país perfeccione el enfoque político, económico, social, científico-tecnológico y ambiental de la gestión de riesgos mediante la implementación de un conjunto de estrategias, como resultado de proyectos e investigaciones multidisciplinarias, dirigidas a prevenir, reducir y controlar los factores de riesgo de desastres, y así disminuir vulnerabilidades ante el impacto negativo de estos peligros (Botero y Milanés, 2015).

Los territorios costeros han sido habitados a lo largo de la historia por diferentes civilizaciones, las cuales se van expandiendo a partir de los beneficios que le brinda el acceso al mar, al utilizar los recursos marinos para la alimentación de las poblaciones, la obtención de materias primas, posibilidad de transporte, comercio, así, como para el desarrollo de otras prácticas culturales (Milanés, 2001). La provincia Santiago de Cuba se encuentra situada al sur de la Isla de Cuba, en contacto directo con el Mar Caribe (Álvarez, 2001), posición, que incrementa su fragilidad ante eventos hidrometeorológicos extremos, los cuales ocurren ya con una alta frecuencia y con mayor poder destructivo.

Aparejado a esta situación destaca el progresivo desarrollo económico y el crecimiento poblacional que existe en localidades cercanas a la costa santiaguera, lo que viene multiplicando el riesgo de afectación a infraestructuras económicas y sociales y a la pérdida de lo más preciado de la sociedad, “la vida del hombre”, por lo que se hace necesario establecer planes de preparación y enfrentamiento al riesgo más eficientes, a fin de mitigar y minimizar las condiciones de vulnerabilidad causales de los principales daños.

En el año 2005 surge la primera Directiva No. 1 del vicepresidente del Consejo de Defensa Nacional para la organización, planificación y preparación del país ante situaciones de desastres (EMDC, 2005), la cual se perfecciona en el año 2010 (EMDC, 2010). Desde ese periodo se responsabilizó al Ministerio de Ciencia, Tecnología y Medioambiente (CITMA) con la realización de estudios de peligro, vulnerabilidad y riesgo (PVR) ante diferentes tipos de situaciones. Paralelamente el CITMA delegó en la Agencia del Medio Ambiente (AMA) la responsabilidad del cumplimiento de esta directiva bajo el auxilio de la participación del potencial científico del país, (Serrano y otros 2014; Milanés 2014a; b). Dichos estudios permiten identificar, medir, cuantificar, analizar y comprender los riesgos asociados a fenómenos naturales extremos, establecen un modelo de actuación que le concede gran énfasis a los aspectos preventivos, pues se trata no sólo de dar respuestas a los fenómenos, sino de anticiparse al identificar los peligros y sus riesgos, la forma de manejarlos, transformarlos y modificarlos con el objetivo de reducir susceptibilidades (Milanés et al 2015). Los estudios ofrecen además una panorámica del ambiente costero y marino y de las condiciones socioeconómicas para actuar de manera proactiva ante el riesgo de desastres naturales (Serrano y otros, 2014) para, a partir de sus resultados, contribuir al desarrollo de planes de reducción de desastres, el ordenamiento territorial y al diseño de las políticas de desarrollo económico y social sostenibles. Sin embargo, a pesar de las ventajas obtenidas en la implementación de los estudios de PVR para la provincia de Santiago de Cuba, se aprecia como dificultades fundamentales las siguientes:

Significativa cantidad de datos que se encuentran dispersos o no accesibles. No todos los decisores pueden acceder a la información resultante de los estudios de PVR en la provincia. Los resultados quedaron almacenados en abundantes mapas, hojas de cálculo y documentos de texto difíciles de entender para la rápida y oportuna toma de decisiones.

Para que diferentes actores accedan a la información requerida, se debe duplicar la misma, lo que no garantiza la confiabilidad e integridad de los datos (Izamorar, 2015). Esto puede derivar en documentos con información contradictoria y no segura el acceso por niveles específicos de usuarios.

No se dispone de un formato homogéneo que permita presentar los datos adecuadamente, tampoco de la capacidad de analizarlos atendiendo a las diferentes perspectivas y tipos de peligro. Tampoco la forma en que hoy se presenta la información permite analizar los efectos que tendrían las interacciones entre diferentes sistemas frontales.

No hay un sistema de análisis o reporte que genere información útil para la planificación, ni considere las nuevas necesidades de información de los gestores de riesgo y tomadores de decisiones.

La información requiere actualización sistemática (a través de censos, inventarios, sistemas frontales ocurridos con el paso del tiempo, etc.), sin embargo, actualmente no existen en el país sistemas de información que se consideren verdaderos sistemas de seguimiento de la gestión de los estudios de PVR. Los procesos de seguimiento que se realizan son frecuentemente de carácter manual.

Lo anterior justifica el planteamiento de la siguiente interrogante: ¿Cómo contribuir a mejorar el proceso de toma de decisiones en la reducción del riesgo ante eventos hidrometeorológicos a partir del análisis de los actuales resultados de los estudios de Peligro, Vulnerabilidad y Riesgo? La actual investigación describe el diseño e implementación de una herramienta informática, que optimiza el procesamiento de los resultados de los estudios de PVR en la provincia de Santiago de Cuba ante eventos hidrometeorológicos extremos, al ser integrados para su análisis y obtener información relevante con el nivel de detalle deseado para una rápida y efectiva toma de decisiones en la reducción del riesgo de desastres.

MATERIALES Y MÉTODOS

A través de la revisión de las metodologías que soportan los estudios de PVR ante los peligros expuestos y los resultados recopilados de las hojas de cálculo, se logró identificar qué parámetros se tuvieron en cuenta para calcular la vulnerabilidad, ante las diferentes categorías de Huracán (I, III, V), en cada Consejo Popular de los nueve municipios que conforman la provincia. Para fuertes vientos e intensas lluvias, se analizaron todos los municipios. En el caso del peligro de penetración del mar solo se valoran los dos municipios costeros que tiene la región de estudio, los cuales se corresponden con los municipios de Guamá y Santiago de Cuba (Milanés 2014).

En la investigación se emplearon las técnicas, metodologías y herramientas adecuadas que propone el proceso de Inteligencia de Negocios (BI, siglas en inglés) para explotar y analizar información estructurada sobre un área determinada (Cano, 2008), las cuales proveen las siguientes funcionalidades:

Accesibilidad a la información: Los datos constituyen la fuente principal de este concepto. Es prioridad garantizar el acceso de los usuarios a éstos con independencia de su procedencia, (Huamantumba, 2007).

Ayuda a incrementar la eficiencia: Con BI toda la información se puede centralizar y visualizar en una misma plataforma y convertir en información útil y organizada, ahorrando tiempo y haciendo la toma de decisiones más eficiente.

Análisis Situacional: Brinda análisis de información histórica más acertada, actualizaciones en tiempo real, predicción y tendencias basadas en información, (Huamantumba, 2007).

Apoyo en la toma de decisiones: Se busca ir más allá en la presentación de la información, de manera que los usuarios tengan acceso a herramientas de análisis que les permitan seleccionar y manipular sólo aquellos datos que les interesen (Sinnexus, 2008).

La vulnerabilidad es clasificada según su tipo como: estructural, no estructural, funcional, económica, social y ecológica, de acuerdo a diferentes criterios y expresada desde el punto de vista matemático como un valor acotado entre cero y uno. Toma valor {1}, cuando los daños son totales y, cero {0} cuando estos son nulos (Serrano y otros, 2014). La Tabla 1 refleja los parámetros que definen el cálculo de las vulnerabilidades ante los peligros de inundación costera por penetración del mar (1), por intensas lluvias (2) y afectaciones por fuertes vientos (3) respectivamente.

Tabla 1 Definición de los parámetros para el cálculo de la Vulnerabilidad ante los diferentes peligros (Fuente: Modificado de AMA 2014)

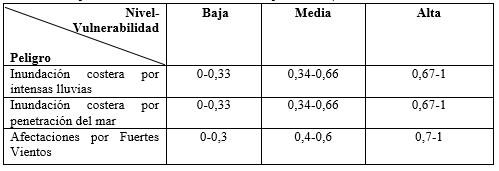

En el caso de la inundación costera por intensas lluvias, se calcula además la vulnerabilidad física como la suma de las vulnerabilidades estructural, no estructural y la funcional (Serrano y otros, 2014). A partir de los resultados se obtiene la vulnerabilidad total (V) como sumatoria de las anteriores, y el nivel de susceptibilidad estimado para cada consejo popular se evalúa por intervalos como se muestra en la Tabla 2.

Tabla 2 Intervalos para la valoración del nivel de susceptibilidad. (Fuente: Modificado de AMA 2014)

Teniendo en cuenta el valor del peligro de que ocurra un evento potencialmente dañino con determinada intensidad, el cual es estimado a través de criterios topográficos, geomorfológicos, de permeabilidad, entre otros, se calculó el riesgo total (R) para cada peligro hidrometeorológico como R = P*V, y se valora como se muestra en la Tabla 3.

Para estimar el intervalo de riesgo del peligro inundación costera por penetración del mar, se establece una comparación de este valor entre los consejos populares estudiados de cada municipio o provincia, se considera el máximo valor de riesgo obtenido dentro de éstos para una misma intensidad del peligro y el mayor obtenido es dividido por tres para establecer el rango y el desglose en riesgo alto, medio y bajo (Serrano y otros, 2014). Este procedimiento se realiza para cada intensidad de peligro analizada.

Uso del Modelo Multidimensional de almacenamiento de datos.

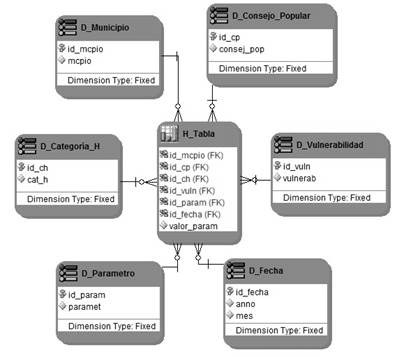

Como parte del diseño de la herramienta informática se empleó el modelo multidimensional para almacenar los datos obtenidos de los estudios de PVR realizados. Este modelo es una técnica de diseño de estructuras de base de datos que se basa en el modelo entidad-relación (MER)(Rosario, 2012), y que como ventajas ofrece, simplicidad de navegación, encuesta y permite el análisis rápido de la información en función de varios indicadores en apoyo a la toma de decisiones (Villanueva, 2003). Está compuesto por dos tipos de tablas: tablas de dimensiones, cada una formada por tuplas de atributos de la dimensión y una tabla de hechos, compuesta por tuplas, una por cada hecho registrado. Este hecho contiene alguna variable o variables medidas u observadas (Kimball, 1997).

El modelo propone tres esquemas multidimensionales, y a razón de esta investigación se exponen los dos empleados. 1) El esquema en estrella, que consta de una tabla de hechos central y de varias tablas de dimensiones relacionadas a esta a través de sus respectivas claves. Este modelo debe estar totalmente desnormalizado, es decir que no puede presentarse en tercera forma normal (3ra FN) (ETL-Tools. Info, 2012). 2) Esquema constelación: es un modelo compuesto por una serie de esquemas en estrella, formado por una tabla de hechos principal y por una o más tablas de hechos auxiliares, las cuales pueden ser sumarizaciones de la principal. Dichas tablas yacen en el centro del modelo y están relacionadas con sus respectivas tablas de dimensiones (Bernabeu, 2009).

Uso del Data Warehouse o Almacén de Datos

La variedad de formatos, tipos de almacenamiento y la dificultad permanente al presentar reportes derivados del análisis de los estudios de PVR en la provincia, hace necesaria la transformación estructural que modifique el actual proceso que gestiona los resultados. Como opción al cambio, fueron seleccionadas herramientas y técnicas analíticas proporcionadas por la inteligencia de negocios, que entre sus soluciones se evidencia la creación de los Almacenes de Datos o Datawarehouses: depósitos de datos relacionados a las actividades de una empresa y grabadas en una base de datos diseñada específicamente con el propósito de hacer informes para después ser analizados y conseguir información estratégica (Villanueva, 2003). Estos repositorios posibilitan además la extracción de datos de sistemas operacionales y fuentes externas, para luego ser integrados, homogeneizados y posteriormente ser analizados por los usuarios indicados, permitiendo obtener información oportuna, fiable e integrada (Bernabeu, 2009). La propuesta de implementación de un almacén de datos, posibilitó elaborar un diseño enfocado a responder eficientemente a cuáles son los elementos, tomados desde todas las fuentes externas, que más inciden en los niveles de susceptibilidad y las probabilidades de afectación por exposición ante un cierto peligro y como ser analizados desde distintos enfoques y en el periodo que se determine. Lo anterior responde a las características fundamentales expresadas por Inmon (2002) acerca de los almacenes de datos: orientados al tema, integrado, variable en el tiempo y no volátiles.

Arquitectura de la Herramienta Informática

En la propuesta de selección de un almacén de datos como solución a las problemáticas planteadas, se detectó la necesidad de construir repositorios que alberguen individualmente datos relacionados a los parámetros e indicadores que definen el estado y comportamiento de la provincia ante el enfrentamiento a cada uno de los peligros mencionados, para luego componer el almacén general sobre el que se podrá realizar su posterior análisis de manera integrada. Para ello es empleado el recurso: Data Mart o almacén de datos departamental el cual no es más que la implementación de un Data Warehouse con alcance restringido a un área funcional, problema en particular, tema o grupo de necesidades. De acuerdo a las operaciones que se deseen o requieran desarrollar, los data mart son expresados a través de las siguientes arquitecturas: Top-Down: primero se define el almacén y luego se desarrollan, construyen y cargan los data mart a partir del mismo y Bottom-Up: donde son definidos previamente los data mart y luego se integran en un almacén de datos centralizado (Sinnexus, 2008).

El desarrollo de la solución informática se condujo por un proceso denominado data Warehousing o almacenamiento de datos: encargado de extraer, transformar consolidar, integrar y centralizar la información obtenida de las fuentes operacionales y definir el conjunto de herramientas necesarias para consultar, analizar y presentar la información (Bernabeu, 2009) de modo que el personal gestor no requiera avanzados conocimientos de Informática para su acceso. Las etapas que se llevan a cabo durante el data Warehousing, adaptada a la arquitectura Bottom-Up definida anteriormente es empleada en la presente investigación y consistió primeramente en examinar y seleccionar las fuentes externas de las que se obtendrán los datos resultantes de los estudios, en este caso hojas de cálculo referentes a las dos etapas 2011 y 2016, para luego ser extraídos, transformados para resolver problemas de inconsistencia entre ellos y garantizar su óptima calidad, y una vez depurados ser cargados al almacén. El almacén de datos es gestionado en términos de tablas de hechos: contenedoras precisamente de hechos, valores numéricos o resultado de expresiones matemáticas de alta utilidad, en este contexto son los referentes a los parámetros e indicadores definidos para cada peligro; y las tablas de dimensiones: perspectivas de estimación de los hechos, como son, por consejos populares, municipio, entre otros; y son organizados en torno a una base de datos o cubo multidimensional. Es importante destacar que estos procedimientos se realizaron para cada peligro y que una vez concluidos son visualizados y explorados de forma integrada. Finalmente, a través de una interfaz gráfica intuitiva, los decisores son capaces de generar consultas a los datos y obtener informes deseados en un formato familiar que apoyen el proceso de toma de decisiones para minimizar el impacto negativo de estos eventos.

Herramientas y Metodología empleadas durante el data warehousing.

La suite Pentaho de código abierto se define como una plataforma de inteligencia de Negocios y brinda el conjunto de utilitarios para la construcción de almacenes de datos. Se hizo uso de Pentaho Data Integration (KETTLE) V5.3, la cual incluye un conjunto de herramientas, que, de forma gráfica, agiliza el proceso de extracción, transformación y carga (ETL) de los datos contenidos en las hojas de cálculo hacia la base de datos multidimensional. A través de componentes visuales se accedió a las fuentes de datos y se prepararon para su análisis, se definieron las transformaciones pertinentes interconectando bloques y con el ajuste de diversas funciones quedaron programadas para su ejecución. Por otra parte, Mondrian Schema Workbench V3.8 ,es el mecanismo que a partir de una interfaz visual proporcionó conexión a los esquemas definidos, correspondientes al comportamiento de los datos para cada peligro y que conforman el almacén, para confeccionar el esquema o cubo multidimensional en términos de dimensiones, jerarquías y hechos, y posteriormente realizar el procesamiento analítico en línea (OLAP) o sea el análisis de los datos en tiempo real y por último a través del BI-server o servidor de BI V6.0 fueron publicados los cubos, accesibles a través del navegador, y con el empleo de varios complementos como Jpivot View, Pentaho Audit, entre otros, son mejorados los procesos de exploración ,análisis y seguridad de la información y creados informes pertinentes de manera dinámica en apoyo a la función de los gestores de riesgo ante la eventualidad de los diferentes peligros.

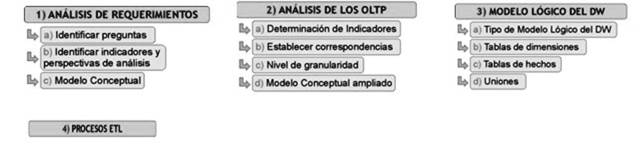

La metodología seleccionada para la construcción del Almacén de Datos fue la metodología HEFESTO. Fue seleccionada por sus múltiples bondades las cuales se corresponden con las siguientes características: a) Los objetivos y resultados esperados en cada fase se distinguen fácilmente y son sencillos de comprender, b) se basa en los requerimientos del usuario, por lo cual su estructura es capaz de adaptarse con facilidad y rapidez ante los cambios en el negocios y c) especifica puntualmente los pasos a seguir en cada fase, a diferencia de otras metodologías que mencionan los procesos pero no exponen como explicarlos (Bernabeu, 2009). En la siguiente figura (Figura 1) se observan los pasos que orienta esta metodología y que fueron aplicados para desarrollar la herramienta que este trabajo presenta.

RESULTADOS Y DISCUSIÓN

Las hojas de cálculo desde donde se obtienen los resultados de los estudios de PVR presentan un diseño que difícilmente puede ser interpretado por las herramientas de análisis expuestas, por lo que se hizo necesario crear hojas intermedias en el propio documento que responden a las exigencias de formato, realizando vínculos a los datos sin necesidad de duplicación.

De acuerdo a lo establecido por la metodología Hefesto, fueron examinados estos documentos y se determinaron las correspondencias con los indicadores y perspectivas de análisis que definen el alcance de los Data Mart que conforman el Almacén de Datos (Ver Figura 2).

Fig. 2 Establecimiento de correspondencias para el control de valores por vulnerabilidad, por cada tipo de peligro (Fuente: Elaborado por el autor).

Para la correspondencia entre las fuentes de datos y la determinación de los indicadores y perspectivas de análisis, se constata la necesidad de conformar una nueva tabla de hechos secundaria para la estimación del riesgo asociado al peligro que corresponda, ya que el mismo es independiente al tipo de vulnerabilidad, y por consiguiente se incorpora el esquema Constelación, descrito en (2.1), al diseño de la base de datos multidimensional.

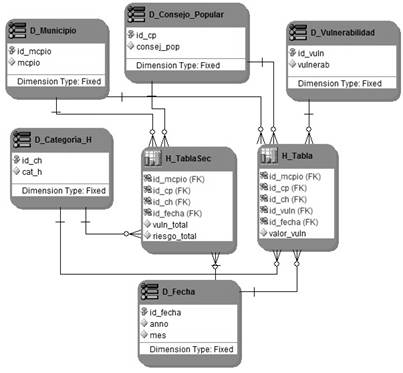

Para diseñar los data mart que conforman el almacén de datos, se emplearon los esquemas Estrella y Constelación. El diseño de la base de datos queda conformado a partir de los modelos lógicos definidos en las Figura 3 y Figura 4.

Fig. 3 Modelo lógico del Data Mart Parámetros_Metodología por cada tipo de peligro (Fuente: Elaborado por el autor).

Fig. 4 Modelo lógico del Data Mart Indicadores_Metodología por cada tipo de peligro (Fuente: Elaborado por el autor).

Creada la base de datos multidimensional se procedió a cargar las tablas de dimensiones y la tabla de hechos de los data mart definidos para cada peligro a través del proceso ETL, de manera que permita eliminar inconsistencia y heterogeneidad en los datos contenidos en las fuentes operacionales.

Una vez cargada la base de datos, se procede a la construcción de los cubos multidimensionales. La estructura de los cubos, se realiza en correspondencia a los data mart definidos, con el objetivo de representar los datos planos que se encuentran en las filas y columnas de la base de datos en una matriz de N dimensiones (Bernabeu, 2009), en los cuales se incluyen, para cada data mart, los valores de los parámetros e indicadores que actúan como hechos y que son determinados a partir de funciones de agregación predefinidas o personalizadas para su posterior criterio de evaluación y, las perspectivas de análisis representadas por las tablas de dimensiones.

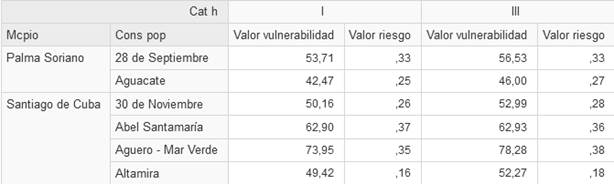

Por último son publicados los cubos en el servidor Pentaho para su procesamiento analítico y que permite incorporar varios complementos para mejorar el análisis y seguridad de la información, construcción sencilla y dinámica de reportes tabulares y gráficos, mejor representados y con opciones de exportación a diferentes formatos como PDF, Excel y PNG. La Figura 5 muestra la consulta en formato tabular, el resultado del análisis de vulnerabilidad de una muestra de municipios de Palma Soriano y Santiago de Cuba ante el riesgo de inundación por intensas lluvias, la que es construida realizando operaciones de arrastrar y soltar (drag and drop), dando la posibilidad al gestor de modificar e ir visualizando sus resultados dinámicamente según se va estructurando. La Figura 6 muestra la salida anterior en gráfico de barra apilada, donde se demuestra las diferencias entre los valores de vulnerabilidad y riesgo para los consejos populares especificados en los años de realizado el estudio, de esta manera se constata los cambios ocurridos en los territorios ante la exposición del peligro que se analice y alerta acerca del nivel de atención a los territorios que lo requieran para reducir las condiciones de fragilidad.

CONCLUSIONES

Los estudios de Peligro, Vulnerabilidad y Riesgo ante eventos hidrometeorológicos, son de los primeros de su tipo elaborados e implementados en el país y, por su importancia, constituyen instrumentos para la gestión del riesgo de desastres y la toma oportuna de decisiones para los órganos de gobiernos en las diferentes escalas territoriales.

Mediante estos resultados, se conformó una herramienta informática que:

1) Centraliza las dos etapas de estudios realizados, las cuales residen ahora en la misma base de datos diseñada con un enfoque multidimensional y que permite el análisis desde varias perspectivas, histórico, comparativo y de tendencias, para una efectiva toma de decisiones; 2) Permite obtener información a través de consultas interactivas con el nivel de detalle deseado, realizando operaciones sencillas sin que esto suponga tener conocimientos avanzados de programación o base de datos; 3) Provee representación de los datos en 11 tipologías de gráficos que aportan dinamismo, flexibilidad y un alto poder de intuición, con opciones de estilos y filtrado en tiempo real, adaptándose con facilidad a las necesidades de información por parte de los decisores; 4) Es accesible de manera inmediata a través de la red, lo que permite que la información se encuentre disponible a varios usuarios al mismo tiempo y 5) Garantiza la seguridad de la información, a través del acceso restringido por roles específicos donde solo los actores con permisos definidos podrán acceder a la información.