Mi SciELO

Servicios Personalizados

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

ACIMED

versión impresa ISSN 1024-9435

ACIMED v.14 n.5 Ciudad de La Habana sep.-oct. 2006

Inserción de los métodos matemáticos en el estudio del concepto de información

MSc. Natalia Sokol1 y Dr.C. Radamés Linares Columbié2

Resumen

Se abordan las tendencias en el enfoque del concepto de la información, con énfasis en su dimensión física y medible, donde se encuentra el mayor peso de las aplicaciones matemáticas. En este sentido, se analiza la teoría matemática de la información de Shannon y Weaver, así como los aportes más significativos de otros científicos. Se examinan también las consideraciones realizadas por los partidarios del enfoque cognitivo de la información.

Palabras clave: Información, matemática, teoría de la información.

Abstract

The current tendencies in the approach of the concept of information are dealt with, making emphasis on its measurable and physical dimension, where the mathematical applications influence the most. In this sense, Shannon and Weaver's mathematical information theory, as well as the most significant contributions of other scientists, are analyzed. The considerations of the followers of the cognitive approach of information are also examined.

Key words: Information, mathematics, information theory.

Copyright: © ECIMED. Contribución de acceso abierto, distribuida bajo los términos de la Licencia Creative Commons Reconocimiento-No Comercial-Compartir Igual 2.0, que permite consultar, reproducir, distribuir, comunicar públicamente y utilizar los resultados del trabajo en la práctica, así como todos sus derivados, sin propósitos comerciales y con licencia idéntica, siempre que se cite adecuadamente el autor o los autores y su fuente original.

Cita (Vancouver): Sokol N , Linares Columbié R . Inserción de los métodos matemáticos en el estudio del concepto de información . Acimed 2006;14(5). Disponible en: http://bvs.sld.cu/revistas/aci/vol14_5_06/aci08506.htm [Consultado: día/mes/año].

El fenómeno de la información siempre fue y es objeto de estudio de las diferentes disciplinas científicas, así como de polémicas y discrepancias de muchos autores que han tratado el tema. La preocupación por encontrar un concepto adecuado para su definición se manifiesta constantemente en los estudios teóricos realizados por la ciencia de la información.

Como resultado de estas indagaciones se observan dos grandes grupos de propuestas: información como algo físico, objetivo e información como algo subjetivo, asevera Fernández Molina.1

Es oportuno señalar que es la primera tendencia la que lleva el mayor peso de las aplicaciones matemáticas. La ciencia de la información, desde sus orígenes, se nutrió de los supuestos teóricos prevalecientes en el modelo de racionalidad proveniente del positivismo, el empirismo y el cientificismo. Subraya Pedroso Izquierdo, que esta ciencia tiene como antecedentes históricos al movimiento documentalista, impulsado por Paul Otlet y, a partir de los años 50, la recuperación de la información, ambos con un marcado carácter positivista. Por estas razones, las nociones de información que se incorporaron a esta ciencia tendían a ajustarse a una perspectiva objetivista y cientificista. De este modo, la información se concibió como algo cuantificable.2

Teoría matemática de la información: consideraciones básicas

El concepto de la información se inserta en los estudios científicos, sobre todo a partir de la formulación de la teoría matemática de la información, publicada en 1949 y desarrollada por el ingeniero electrotécnico y matemático estadounidense Claude E. Shannon (1916-2001), considerado el padre de la era de las comunicaciones electrónicas (nacido en Gaylord, Michigan, Estados Unidos), quien trató de presentar el concepto de la información de la manera más formal posible, mediante las herramientas matemáticas que pudieran medir y expresar su cantidad en unidades físicas. Originalmente, se definió como teoría matemática de la comunicación (The Mathematical Theory of Communication), aunque se conoce también como teoría matemática de la información o simplemente como teoría de la información.

Esta propuesta teórica, presentada por Shannon y Weaver a finales de la década de los 40, brilla con luz propia dentro del panorama intelectual porque supuso el espaldarazo teórico definitivo para fundamentar la mayoría de los tratamientos ulteriores que se dedicaron al fenómeno de la información.3

Warren Weaver (1894-1978) colaboró con Shannon en la concepción de su teoría; sus aportes concedieron mucha mayor proyección al planteamiento teórico inicial de Shannon, e incluso generó un acercamiento con el campo de las ciencias sociales.

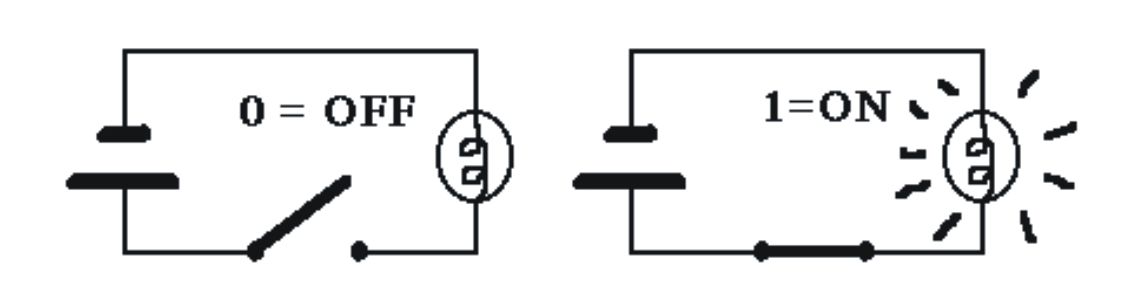

Shannon, mientras trabajaba en los laboratorios Bell Telephone, filial de la empresa de telecomunicaciones American Telegraph & Telephone (ATT), comenzó sus investigaciones para resolver las necesidades prácticas de la transmisión eficiente de los mensajes por los canales de comunicación. Sus ideas iniciales sobre esta teoría surgieron a partir de la observación de las similitudes entre los principios de la lógica (verdadero-falso), los circuitos lógicos de la conmutación por teléfono y los dos estados (abierto-cerrado) de las llaves electromecánicas (fig. 1). A partir de la aplicación de los principios del álgebra booleana de dos valores: Verdadero (1) - Falso (0), Shannon logró explicar este proceso de manera sencilla: 1 significaba On cuando el interruptor estaba cerrado y el circuito encendido, mientras que 0 significaba O ff cuando el interruptor estaba abierto y el circuito apagado.

FIG. 1. Estado de los circuitos.

Además de estas bases, sobre las cuales se establece la teoría de la información, hubo otros intentos de aplicar matemática a esta. Así, Harry Nyquist, en 1924, realizó un estudio sobre las posibilidades del uso de la teoría matemática para el aumento de la velocidad de transmisión de mensajes telegráficos. En 1928, R. Hartley planteó la primera variante de medida de la información mediante la aplicación de la teoría matemática de probabilidades.

A la conformación de la teoría matemática de la información contribuyeron también los estudios teóricos de los científicos soviéticos, entre los que se destacan: el académico Kotélnikov VA, quien formuló en 1933 el teorema sobre la posibilidad de representar una función continua mediante el conjunto de sus valores en cada uno de los puntos de la lectura y elaboró, en 1946, los métodos óptimos de recepción de señales en presencia de ruidos, y el matemático y físico Kolmogorov AN, quien aceleró el desarrollo de la teoría estadística de las oscilaciones, en la que descansan los fundamentos matemáticos de la teoría de la información.

En cuanto a la Cibernética, fundada por Norbert Wiener y von Neumann hacia 1945, esta disciplina científica basa sus estudios sobre las analogías entre los principios del funcionamiento del cerebro humano (adquirir, usar, retener y transmitir información) y de las primeras computadoras. La cibernética, por tanto, aborda no solo el control automático de la maquinaria mediante computadoras y otros aparatos electrónicos, sino también el estudio del cerebro y del sistema nervioso humano, así como la relación entre los sistemas de comunicación y control.

Para los principios de los años 50, al unificar un gran número de ideas, observaciones y experiencias dispersas en una ciencia única, la cibernética se impuso como un modo de pensar y de actuar. Los fundamentos de esta nueva disciplina se plasmaron en el libro de Norbert Wiener, titulado Cybernetics or Control and Communication in the Man and the Machina.

A los planteamientos de Wiener, von Neumann y otros, Claude E. Shannon agregó sus propias ideas y propuso una teoría nueva que representaba la información de manera cuantitativa. Con su teoría de la información, Shannon introdujo una nueva noción de la información, con un enfoque no al sentido habitual de noticia o de informe, sino de una magnitud estadística abstracta que considera el mensaje independientemente de su significado: E ® M ® R (Emisor ® Mensaje ® Receptor). Este concepto de información, evidentemente, estuvo dirigido al ámbito de los canales artificiales de comunicación, sobre todo a aquellos que funcionaban con la tecnología digital.

En la teoría de Shannon, la información tiene un significado muy preciso: es el número medio de dígitos binarios necesarios para distinguir un mensaje determinado del resto del conjunto de mensajes posibles, y esto, a su vez, implica un número limitado de mensajes que pueden transmitirse y que posibilita la creación de un código diferente para identificar cada uno de ellos. De esta manera, en el caso de n mensajes igualmente probables, el contenido de información o el tamaño del código en bits necesario, sería: I = log2 n.

Bit es una palabra formada por el prefijo bi (bi nary) y el sufijo t (digit). Binary digit significa número binario. Por su extrema sencillez, el sistema binario se eligió como sistema básico de referencia en los modelos matemáticos de los sistemas de comunicación, entre ellos, los que emplean las computadoras.

En el caso de que los mensajes no presenten igual probabilidad de aparecer, la fórmula aplicable para el cálculo del contenido de información es:

![]()

donde pi es la probabilidad de que aparezca el mensaje y n es la cantidad de mensajes posibles. Esta fòrmula matemática puede interpretarse de la manera siguiente: cuanto más frecuente sea una señal, menos informa, porque su ocurrencia puede ser parte de otros mensajes.

En los años 90, Charles Cole resaltó dos conceptos importantes desarrollados por Shannon en la teoría de la información: incertidumbre y entropía. Este autor considera que la interpretación tradicional, más centrada en la incertidumbre, asociada con la transmisión de la señal (polo receptor), podía sustituirse por la asociada con la selección de un mensaje del conjunto de posibles mensajes (polo emisor). En su opinión, este último enfoque es mucho más apropiado para los estudios en la ciencia de la información.4

Entropía, habitualmente denominada con la letra H, un término que se tomó de la termodinámica, donde se utiliza para denominar el grado de desorden o aleatoriedad (incertidumbre) de un sistema, aplicado a la información, representa una medida de orden, opuesta a la incertidumbre. La entropía es magnitud termodinámica que mide la parte de la energía que no puede utilizarse para producir un trabajo. En un sentido más amplio, se interpreta como la medida del desorden de un sistema. Según la segunda ley de la termodinámica, la entropía es el grado de aleatoriedad en cualquier sistema.

Si se considera que la información requerida es una medida de la incertidumbre existente, la cantidad de información transmitida será equivalente a la reducción de la entropía, que tiene una importancia fundamental para el cálculo del contenido de información trasmitido por un mensaje. Esta idea, habitualmente, se expresa mediante la siguiente fórmula: I = Hpr – Hpo, donde Hpr representa la entropía previa a la recepción del mensaje y Hpo la entropía posterior a la llegada del mensaje. Ahora bien, cuando tras la llegada del mensaje no queda ninguna incertidumbre, Hpo es igual a cero y la información se mide exclusivamente de acuerdo con la entropía previa.

Por su parte, Dmítriev destaca que a la teoría de la información, en su planteamiento original, pertenecen los resultados del cálculo de los siguientes problemas teóricos fundamentales referentes al aumento de la eficacia de funcionamiento de los sistemas de comunicación:

- La definición matemática de las magnitudes que intervienen en el proceso de transmisión de mensajes, incluidos los referentes a la cantidad de información que puede transmitirse por un canal.

- La fundamentación matemática de la posibilidad de codificación y decodificación de los mensajes que aseguran la máxima velocidad admisible de transmisión de estos últimos por el canal de comunicación, tanto en ausencia como en presencia del ruido.5

Otro de los autores de la teoría matemática de la información, Weaver, concedió un alcance mayor al planteamiento inicial de Shannon, restringido solo al ámbito técnico de la transmisión de mensajes. Weaver extendió dicho planteamiento de los mensajes independientes de su contenido, cuantificables en términos matemáticos y observados en el decursar de su flujo, a un marco de análisis aplicable al mundo de los medios escritos, sonoros y visuales. El autor destacaba que la teoría puede adaptarse a todas estas formas de comunicación y a muchas otras.

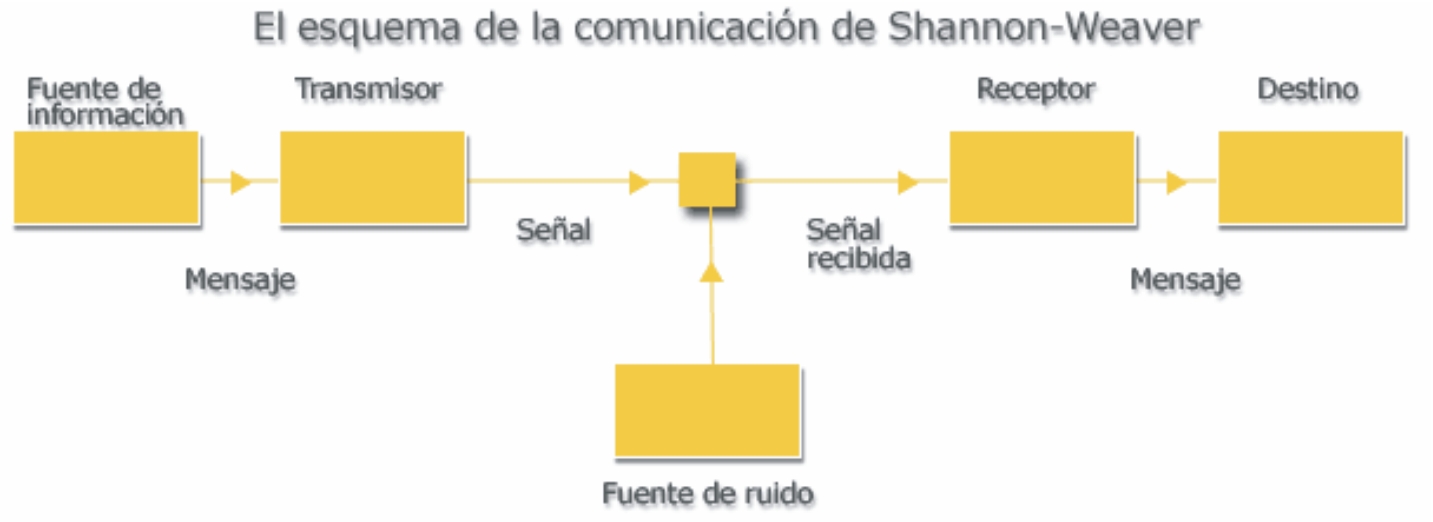

Otro de los méritos de Weaver fue la presentación de los principales conceptos y resultados del trabajo de Shannon en un lenguaje no matemático y asequible, así como agregarles un modelo teórico que representaba los elementos y las relaciones implicadas en el flujo de información. El modelo propuesto adquirió tanta importancia en el desarrollo posterior de la teoría de la información que opacó, en parte, otros de los logros conceptuales de esa obra. A ambos autores se debe el conocido esquema lineal de la comunicación, en el que se define la secuencia: fuente, transmisor, canal, ruido, receptor y destino (fig. 2).

FIG. 2. Esquema de la comunicación de Shanon-Weawer.

En el esquema, se observan los siguientes elementos básicos de cualquier sistema de comunicación:

- Una fuente de información: un dispositivo que transmite y codifica convenientemente la información o un mensaje por un medio concreto.

- El medio o el canal por el que se transmite el mensaje.

- Un dispositivo de recepción que descifra el mensaje con cierta aproximación al original.

- El destinatario (receptor) del mensaje.

- Una fuente del ruido (interferencias impredecibles o distorsiones causadas por una operación conocida o, incluso, intencionada, que puede corregirse mediante la operación inversa) que cambia el mensaje de manera imprevisible durante la transmisión.

El carácter genérico del modelo permite su aplicación en situaciones diversas. Según el modelo y la primacía de los aspectos técnicos, los problemas a estudiarse en un sistema de comunicación se relacionan con la cantidad de información, la capacidad del canal de transmisión y el proceso de codificación que puede utilizarse para convertir un mensaje en una señal y los efectos del ruido.

Paralelamente a los matemáticos, los estudiosos del campo de las humanidades, especialmente los lingüistas y los semióticos, introdujeron en la ciencia de la comunicación los aspectos cualitativos que permitían la interpretación de los mensajes, es decir, la asignación del sentido a los significados o a la información. El estudio de los sistemas de símbolos por la ciencia de los signos, palabras y lenguajes (semiótica) contiene, según Morris, tres niveles: sintáctico, semántico y pragmático.

A nivel sintáctico, se examinan las propiedades internas de los textos, las relaciones entre los símbolos que reflejan la estructura de un sistema de signos determinado.

A nivel semántico, se analizan las relaciones entre los signos y los objetos designados por ellos, así como entre las acciones y las propiedades, es decir, se analiza el sentido lógico del texto y su relación respecto a la fuente de información.

A nivel pragmático, se examinan las relaciones entre el texto y sus usuarios, es decir, el contenido del texto utilizado y su relación con el destinatario.

Al considerar la relación entre los niveles de estudio de los sistemas de signos y los problemas de la transmisión de la información, Weaver definió los niveles en los que se superpone el proceso comunicativo: técnico, semántico y pragmático e indicó que cada uno de dichos niveles responde a determinada interrogante sobre las cuales descansa el proceso comunicativo:3

- ¿Con qué grado de exactitud se pueden transmitir los símbolos empleados en la comunicación? El problema técnico.

- ¿Con qué grado de precisión transmiten el significado deseado los símbolos empleados en la comunicación? El problema semántico.

- ¿Con qué grado de eficacia se recibe el significado del mensaje por los receptores? El problema pragmático o de la efectividad.

Cada uno de los niveles genera una manera distinta de afrontar el problema de la comunicación. El nivel sintáctico se refiere a la creación de los fundamentos teóricos del diseño de sistemas de comunicación para el perfeccionamiento de los métodos de transmisión de mensajes y su materialización, que permite elevar la capacidad y precisión del emisor. Es decir, que a este nivel valen solo las formas de suministrar los mensajes como conjunto de signos, para abstraerse por completo de su sentido lógico y contenido pragmático.6

En este sentido, la teoría de la información se basa en los resultados del cálculo de una serie de problemas propios de este nivel y en el que la información no se relaciona con ningún significado inherente a los mensajes. Sus fundamentos se apoyan en el concepto de cantidad de información, y esta es la medida de la frecuencia con que se emplean los signos. Es por eso que muchos autores consideran que la teoría de la información se limita al nivel sintáctico.

El nivel semántico, por su parte, se ocupa del significado e interpretación de los mensajes. Los problemas de este nivel se vinculan con la formalización del sentido de la información transmitida; por ejemplo, el estudio de las estimaciones cuantitativas para saber en qué medida se corresponde la interpretación del mensaje recibido con el mensaje enviado, es decir, estimaciones de la calidad de transmisión. Estos problemas son muy complejos, porque en el sentido lógico, la interpretación del mensaje depende más del destinatario que de la semántica del mensaje propiamente dicha. La información, como el contenido del mensaje, se manifiesta en el proceso de interacción con el destinatario. Un mismo mensaje puede interpretarse de manera diferente por diferentes personas, porque la percepción de la información por el hombre depende de su estado emocional, de la experiencia vital acumulada y de otros factores.

El nivel pragmático se centra en los resultados de la recepción y el uso de la información por el destinatario. Los problemas de este nivel se relacionan con la efectividad de la comunicación. La dificultad principal consiste en que la importancia o el valor de consumo de la información puede variar para diferentes destinatarios. Este valor, además, depende considerablemente de la autenticidad de la información, de la oportunidad de su suministro y uso. Las altas exigencias respecto a la velocidad de transmisión de la información, con frecuencia responden a las acciones reguladoras realizadas a escala real del tiempo, es decir, a la velocidad de variación del estado de los objetos o procesos controlables. Las demoras en la transmisión o el uso de la información pueden tener consecuencias negativas.

Las concepciones propuestas por la teoría matemática de la información, asimiladas por el pensamiento científico contemporáneo, formaron parte de una revolución del saber que se generó como resultado del cambio de la praxis sociohistórica del hombre en el siglo XX. Esas concepciones, además, favorecieron la discusión sobre los problemas de la información dentro de diferentes ciencias concretas. En años posteriores, esta teoría se enriqueció con los trabajos de Kolmogorov, McMillan, Goldman, Fano, Gabor y otros. La introducción de las ideas y métodos de la teoría de la información en distintas ramas científicas es un proceso natural, porque la información es una de las facetas del concepto de la diversidad que es una propiedad general de la materia. Es por medio de las matemáticas, la teoría de la información, la cibernética, etc., como se puede superar la contraposición existente entre las ciencias exactas y las ciencias humanas, como se superaron por los científicos del siglo XIX .7

Los intentos de aplicar extensivamente las ideas de la teoría de la información en diversas ramas de la ciencia encuentran su explicación en el hecho de que esta es fundamentalmente una teoría matemática, porque sus conceptos principales (entropía, cantidad de información y capacidad de transmisión) solo se determinan por medio de las probabilidades de los acontecimientos a los cuales se les puede atribuir una naturaleza física diferente.

A su vez, las múltiples aplicaciones existentes de dicha teoría contribuyen al desarrollo de diversas disciplinas científicas, cada una con su conjunto de postulados, algunos de ellos coincidentes en su génesis con la primera concepción de Shannon y otros, que, a partir de sus limitaciones, tratan mediante un abordaje informacional, los fenómenos de la semántica y del valor de la información, que quedan fuera de los métodos presentados por el mencionado autor, por su propia naturaleza.

En cuanto a las posibilidades de la aplicación de la teoría de Shannon a la ciencia de la información, no existe unidad de criterios entre los autores. Así, Suppe considera que la teoría de Shannon es una teoría sintáctica, no utilizable para una ciencia en la que el elemento semántico es fundamental.8 Esta opinión la comparten Mijailov AI, Chernii AI y Guiliarevskii RS, al plantear que la teoría matemática de la información era insuficiente como base de la informática, por cuanto prescindía del contenido semántico que en la informática es decisivo, aún cuando tiene numerosas aplicaciones en los aspectos de codificación y computacionales.9

Por su parte, Moreiro, aunque no niega esta posibilidad, previene contra un procedimiento mecánico al plantear: emplear una teoría de la comunicación, de carácter eminentemente mecánico, a una especialidad en la que tiene gran importancia la significación de los mensajes transmitidos es tarea limitada y difícil, pero ello no ha impedido que, más de cincuenta años después de su definición, la teoría matemática de la comunicación se acepte o rechace de acuerdo con aplicaciones concretas. Las medidas de la información son útiles para su aplicación en el área de la recuperación documental, así como para comparar documentos, fijar nociones, hacer mediciones y, desde luego, para el análisis de contenido en forma automática .10

Sin embargo, otros autores, como Fernández Molina, insisten en que los planteamientos de Shannon permitieron la valoración cuantitativa de aspectos diversos del proceso informacional y constituyeron un fundamento en el desarrollo de la teoría de la información como disciplina científica independiente que dio lugar a una única propuesta formalizada, matemática e implementada del concepto de información.11

Igualmente, De Bonville J (1978) señala que esta teoría no solo solucionó los problemas de telecomunicaciones, sino también resultó perfectamente adaptable a las necesidades de la ciencia de la información, porque nuestra disciplina se halla inserta en la epistemología comunicativa.12

Linares Columbié, por su parte, destaca la contribución significativa de la teoría matemática de la comunicación al desarrollo de la ciencia de la información: por introducir la independencia de la información de sus soportes físicos, pese a no definirla concretamente. Las características de esta propuesta, nacida del universo de telecomunicaciones y formalizada para el contexto de la ciencia de la información, la convierten en modelo de objetividad y cientificidad en esta etapa (Linares Columbié R. La ciencia de la información y sus matrices teóricas: contribución a su historia. [Tesis para optar por el título de Doctor en Ciencias de la Información]. Universidad de La Habana: Facultad de Comunicación, 2004).

Por tanto, puede plantearse que aún cuando el objetivo fundamental de la teoría matemática de la información consistió en encontrar un concepto de información formalizado, medible y expresable en unidades físicas, sus ideas básicas se vinculan con problemas fundamentales de los que se ocupa actualmente la ciencia de la información. Los aspectos aplicados de esta teoría y, especialmente, el lugar que ocupa en diferentes ciencias, muestran que los problemas de almacenamiento, tratamiento y uso de la información conforman un enfoque nuevo, denominado enfoque teórico-informacional, un método de investigación que permite comparar cuantitativa y cualitativamente las características específicas de sistemas concretos con independencia de su naturaleza.

El uso de este enfoque en las investigaciones científicas ofrece, en la mayoría de los casos, nuevos resultados teóricos y valiosas recomendaciones prácticas. Sin embargo, dicho enfoque puede conducir, con frecuencia, a la creación de modelos que distan mucho de adecuarse a la realidad. Por eso, en cualquiera de los estudios que van más allá de los límites de los problemas puramente técnicos de transmisión y almacenamiento de los mensajes, la teoría de la información debe utilizarse cuidadosamente. Esto concierne, fundamentalmente, a la actividad mental del hombre y al modelado de procesos de percepción y elaboración de la información por personas.

El problema consiste en que la teoría de la información, una teoría matemática, aunque muy refinada, no se puede aplicar a todos los casos de la comunicación humana, excepto en la medida en que esta quede desprovista de sus aspectos significativos y se observe solo en función de sus atributos informativos. El dilema consiste en tratar de aplicar la teoría matemática a sectores que se encuentran fuera del dominio para el cual esta tiene validez. Esta teoría es, entonces, coherente consigo misma, parece lo más posible, pero no es exhaustiva para todos los aspectos de la comunicación humana y, reiteramos, tampoco pretende serlo.13

La teoría matemática de la información propició, además, el surgimiento de nuevos espacios científicos, relacionados con el campo de la información: teoría de la codificación, métodos de acceso diferenciado, seguridad informática, entre otras. Sus postulados permitieron realizar aportes a la comunidad científica en el campo de la criptografía, un elemento esencial en la protección de la información en Internet. Cada uno de los espacios referidos aplica sus propios métodos para garantizar la seguridad de la información, a la par que elabora los métodos para su violación, porque no puede planificarse una defensa sin saber las posibles maneras de atacar.

La problemática abordada adquirió mucha importancia en los sistemas de información integrados, en particular, en las redes de información de uso colectivo. Estas redes alcanzan cada vez mayor desarrollo y el problema de la protección de los datos contra accesos no deseados es muy sensible, ya que la información almacenada y transmitida puede utilizarse por ciertos individuos con fines no deseables. Por eso, en los sistemas de protección se desarrollaron herramientas contra el acceso mediante dispositivos de identificación de usuarios, así como métodos para la transformación de los mensajes, cuyo contenido inicial es accesible solo cuando se dispone de cierta información específica (clave) que permite la transformación inversa.

Dichos métodos se denominan métodos de clausura criptográfica y se emplean para proteger la información, tanto en los canales de transmisión, como en los dispositivos de almacenamiento, principalmente en los secundarios que pueden violarse fácilmente. Las transformaciones realizadas en sistemas donde se emplean métodos de clausura criptográfica pueden considerarse como una variante de proceso de codificación y decodificación, en el que el mensaje codificado se denomina criptograma. Actualmente, existen muchos métodos de clausura criptográfica de la información, todos ellos basados en las teorías matemáticas modernas.5

Enfoque subjetivo del concepto de la información: la ecuación fundamental de la ciencia de la información

A finales de los años 70 y principios de los 80, aparecieron diversos estudios dedicados a la crítica del enfoque objetivista con el que se había estudiado el concepto de la información hasta aquel momento. Autores como Belkin, Wilson o Dervin, aunque destacaban el valor del enfoque anterior, propusieron enfoques alternativos, que consideraron los aspectos del contenido y el significado de la información, elementos que luego se retomaron como protagonistas en la ciencia de la información (Linares Columbié R. La ciencia de la información y sus matrices teóricas: contribución a su historia. [Tesis para optar por el título de Doctor en Ciencias de la Información]. Universidad de La Habana: Facultad de Comunicación, 2004).

Por ejemplo, Belkin y Robertson plantearon la idea de que la única noción básica, común a todos los usos de información, es el cambio de las estructuras cognitivas de un individuo, y la información es lo que es capaz de transformar la estructura. Ellos introducen, además, la noción de texto que para ellos es una colección de signos estructurados de manera deliberada por un emisor con la intención de cambiar la estructura de la imagen de un receptor, y la información es la estructura de cualquier texto que es capaz de cambiar la estructura de la imagen del receptor .14

Estos autores destacan que en los procesos de información, como en cualquier otro fenómeno social, están presentes muchos factores subjetivos, como el lenguaje, la imaginación, la experiencia, la intuición, etcétera. Por eso, se propone utilizar en el estudio de la información un enfoque nuevo, denominado enfoque cognitivo. La definición clásica de este, ofrecida por De Mey, se basa en la idea de que cualquier procesamiento de la información, sea perceptual o simbólico, es mediado por un sistema de categorías o conceptos que para el dispositivo de procesamiento de la información son un modelo de su mundo.15

Para Dervin, la información no es algo objetivo y externo, sino algo subjetivo, construido por las personas, dependiente del mundo en que ellos se mueven y que cambia constantemente. Es decir, que la información es una construcción personal creada por los observadores humanos.1

Según Linares Columbié, el enfoque cognitivo, desde finales de los 70 del siglo xx , se convierte en plataforma teórica por excelencia, desde la cuál se conforma la armazón conceptual de la ciencia de la información de ese momento. (Linares Columbié R. La ciencia de la información y sus matrices teóricas: contribución a su historia. [Tesis para optar por el título de Doctor en Ciencias de la Información]. Universidad de La Habana: Facultad de Comunicación, 2004).

Uno de los primeros en aceptar la idea e insistir en la importancia del enfoque cognitivo en ciencia de la información fue Bertram Brookes. Para este autor, el fenómeno de mayor interés fueron las interacciones cognitivas entre los usuarios y los sistemas de información. En sus razonamientos, Brookes parte de la interpretación de la información como eso que modifica la estructura de conocimiento en un acto pleno de comunicación.16

En 1974, este autor propone su ecuación fundamental de la ciencia de la información, en la que se observa de manera implícita el concepto de la información. Después de varias modificaciones, esta ecuación se expresó finalmente de la siguiente forma: K[S]+ DI = K[S + DS], donde la estructura de conocimiento K[S] cambia a una nueva estructura modificada K[S + DS] por la información DI. El efecto de la modificación se indica por DS.

La conceptualización de Brookes de la información como algo que modifica una estructura determinada del conocimiento se expresa con un lenguaje pseudo-matemático, donde los términos y símbolos no se definen realmente Sin embargo, esta manera de interpretar un fenómeno tan abstracto como la información sugiere la idea de que la información y el conocimiento tienen una misma dimensión y son categorías mesurables. El incremento de la información DI puede tener efectos diferentes sobre diversas estructuras del conocimiento, hecho que destaca la subjetividad de esta definición. Finalmente, Brookes considera al conocimiento como una estructura de conceptos unidos por sus relaciones y a la información como una pequeña parte de esta estructura.16

Actualmente, el carácter subjetivo de la información se refleja en mayoría de las investigaciones sobre la información y el conocimiento. Con respecto al tema, Davenport se refiere como sigue: La información apunta a cambiar la manera en que el receptor percibe algo, apunta a modificar su criterio y su conducta. El conocimiento, a su vez, es una mezcla fluida de la experiencia estructurada, valores, información contextual e interiorización experta que proporciona un marco para la evaluación e incorporación de nuevas experiencias e información. Se origina y aplicada en la mente de los conocedores. En las organizaciones, con frecuencia no solo queda arraigado en documentos o bases de datos, sino también en las rutinas, procesos, prácticas y normas institucionales.17

En conclusión, los trabajos científicos que analizan el fenómeno de la información pueden agruparse en dos categorías, desde la perspectiva materialista o idealista de los autores, conocidos como enfoque objetivo y subjetivo de la información.

Ambos enfoques contribuyen, cada uno desde su punto de vista, con ideas y soluciones válidas para la conceptuación de la información y sirven de instrumento integrador para diferentes disciplinas que conforman la ciencia de la información. Los conocimientos teórico-matemáticos proporcionaron herramientas para que el concepto de información fuese objeto de innumerables estudios y pudiese fundamentar su interpretación desde diversos enfoques. Entre todas las teorías que de una u otra manera han contribuido significativamente al desarrollo de la ciencia de la información; en especial, se destaca la teoría matemática de la comunicación de Shannon y Weaver.

Referencias bibliográficas

1. Fernández Molina C. Enfoques objetivo y subjetivo del concepto de información. Revista Española de Documentación Científica 1994;17(3):320-31.

2. Pedroso Izquierdo E. Breve historia del desarrollo de la Ciencia de la información. 2004. Disponible en URL: http://bvs.sld.cu/revistas/aci/vol12_2_04/aci07204.htm [Consultado: 10 de abril del 2006].

3. Pérez Rodríguez M. Fundamentos básicos de la Teoría de la Información. Disponible en URL: http://camelot.upf.es/digital/biblioteca.htm [Consultado: 12 de abril del 2006].

4. Cole C. Shannon revisited: information in terms of uncertainty. JASIS 1993;44(4):204-11.

5. Dmítriev VI. Teoría de información aplicada. Moscú: MIR, 1991.

6. Mamitkónov AG. Regulación e información. Moscú: Nauka, 1975.

7. Lotman IM. Algunas consideraciones sobre la tipología de las culturas. Revista de Occidente 1989;103:5-19.

8. Suppe FR. Toward and adequate information science. En Heilprin LB, ed. Toward foundations of information science. White Plains : Knowledge Industry Publications, 1985.

9. Mijailov AI, Chernii AI, Guliarevskii RS. Fundamentos de la Informática. Moscú-La Habana: Nauka, Academia de Ciencias de Cuba, Instituto de Información Científica y Técnica, 1973.

10. Moreiro González JA. Aplicaciones al análisis automático del contenido provenientes de la teoría matemática de la información. Anales de Documentación 2002;(5):273-86.

11. Fernández Molina JC. De la documentación a la Information Science: Antecedentes, nacimiento y consolidación de la "Ciencia de la Información en el mundo anglosajón. Boletín de la Asociación Andaluza de Bibliotecarios 1993;33(9):41-60.

12. De Bonville J. Application du Paradigme du Shannon à la Bibliothéconomie et à la Documentation. Revue Canadienne des Sciences de l'Information 1978;3:13-27.

13. Dance F. Teoría de la comunicación humana. Buenos Aires: Troquel, 1973.

14. Belkin NJ, Robertson SE. Information Science and the phenomenon of information. JASIS 1976;27(4):97-204.

15. De May M. The cognitive viewpoint: its development and its scope. En: International Workshop on the Cognitive Viewpoint. International Workshop on the Cognitive Viewpoint; March 24-26; Ghent, Belgium. Ghent: University of Ghent, 1977.

16. Brookes BC. The foundations of Information Science. Part 1. Philosophical Aspects. Journal of Information Science 1980;2(3-4):125-33.

17. Davenport T. Conocimiento en acción: Cómo las organizaciones manejan lo que saben. Buenos Aires: Pearson Education, 2001.

Recibido: 21 de mayo del 2006 Aprobado: 1 de junio del 2006.

MSc. Natalia Sokol. Departamento Bibliotecología y Ciencia de la Información.Facultad de Comunicación. Universidad de La Habana. Calle G No.506 entre 21 y 23. El Vedado. Ciudad de La Habana. Cuba. Correo electrónico: zoia@infomed.sld.cu

1Máster en Bibliotecología y Ciencias de la Información. Profesora Auxiliar. Facultad de Comunicación. Universidad de La Habana.

2Doctor en Ciencias de la Información. Profesor Auxiliar. Facultad de Comunicación. Universidad de La Habana.

Ficha de procesamiento

Clasificación: Artículo teórico.

Términos sugeridos para la indización

Según DeCs1

CIENCIA DE LA INFORMACIÓN; MATEMÁTICA.

INFORMATION SCIENCE; MATHEMATICS.

Según DeCI2

CIENCIAS DE LA INFORMACIÓN; MATEMÁTICAS; MÉTODOS DE INVESTIGACIÓN.

INFORMATION SCIENCES; MATHEMATICS; RESEARCH METHODS.

1BIREME. Descriptores en Ciencias de la Salud (DeCS). Sao Paulo: BIREME, 2004.

Disponible en URL: http://decs.bvs.br/E/homepagee.htm

2Díaz del Campo S. Propuesta de términos para la indización en Ciencias de la Información. Descriptores en Ciencias de la Información (DeCI). Disponible en URL: http://cis.sld.cu/E/tesauro.pdf