INTRODUCCIÓN

Dentro de los sistemas visuales de la inteligencia artificial pasos de vital importancia son la segmentación y la extracción de contornos, los cuales en muchas ocasiones han sido tareas de grandes dificultades debido a la variabilidad de la forma de los objetos y cambios en la calidad de las imágenes. Un ejemplo de estos problemas se ha podido encontrar en las imágenes biomédicas donde, muchas veces estas escenas han estado afectadas por ruidos, problemas de muestreos, borrosidad, entre otros, los cuales han causado considerables dificultades con la aplicación de métodos rígidos de segmentación.

A pesar de la existencia de complejos algoritmos que han sido desarrollados hasta el presente, muchos autores han aceptado que el reconocimiento visual de patrones y en particular la segmentación de imágenes, sigue siendo un proceso dependiente de la aplicación y no ha sido encontrado un único método que pueda resolver todos los problemas que se presentan en el megamundo de la inteligencia artificial. Desafortunadamente, la segmentación es un problema complejo con solución no exacta. La segmentación requiere de una considerable cantidad de iteraciones (guiada por el observador) para la obtención de resultados satisfactorios al utilizar técnicas tradicionales de bajo nivel, conocidas como métodos rígidos. La automatización de estos modelos libres de aproximaciones se ha dificultado debido a la complejidad en formas, sombras y variabilidad dentro de cada objeto individual.

En la última década se ha podido constatar que los algoritmos más eficientes de segmentación han sido los llamados métodos recursivos, los cuales han abarcado una variedad de técnicas que van desde la morfología matemática, contornos deformables hasta las técnicas iterativas que hacen uso del umbral. Sin embargo, uno de los problemas que han presentado estas técnicas recursivas ha sido el criterio de parada, donde se ha propuesto gran cantidad de estrategias. 1-4

Una técnica de gran robustez empleada en los últimos años para la segmentación de imágenes es la media desplazada, la cual ha sido un procedimiento no paramétrico para el análisis de datos multimodales que ha mostrado gran superioridad en varias aplicaciones. (5 La media desplazada fue propuesta en 1975 por Fukunaga et al.6 y aunque sus trabajos fueron de corte teórico, predijo que podría ser usada para el reconocimiento visual de patrones. A pesar de ello, esta estuvo largamente olvidada hasta que en 1995 Cheng (7 la retomó con otros intereses. Un modelo computacional basado en el procedimiento de la media desplazada, ha sido una herramienta extremadamente versátil para el análisis del espacio característico y ha podido dar una solución confiable para muchas tareas de reconocimiento visual de patrones. 8 La segmentación a través de la media desplazada ha efectuado como primer paso un filtrado y posteriormente se llevó a cabo el proceso de segmentación. 5

En nuestro estudio se propuso una sustancial mejora al algoritmo iterativo de la media desplazada (MSHi) con relación a la propuesta del 2009, donde también se llegó a la imagen segmentada desde el paso del filtrado, de modo tal que la segmentación no ha sido considerada como un paso independiente, sino una continuación del proceso de filtrado. En este nuevo desarrollo se propuso un nuevo índice de similitud entre imágenes basado en teoría de grupos y utilizando también la función de entropía de Shannon. Se aplicó como un nuevo criterio de parada a la MSHi. En esos trabajos se demostró teórica y experimentalmente que con el nuevo criterio se podía obtener mayor estabilidad en el proceso de segmentación que con el criterio usado en la propuesta anterior (año 2009). Esto ha constituido una nueva conceptualización en el proceso de segmentación unido a una propuesta de un novel índice de similitud.

En la investigación se desarrollaron y propusieron otros algoritmos (todos autóctonos) con su correspondiente base teórica, los cuales ayudaron al propósito de lograr una segmentación que satisficiera los intereses de los especialistas.

Los investigadores de visión por computadora deben utilizar cada vez más algoritmos de segmentación de imágenes para ayudar a construir sistemas de visión robustos y reutilizables. Así como el aprendizaje ha sido un componente esencial de los sistemas visuales biológicos y los sistemas artificiales que han aprendido y se han adaptado, los cuales representan un desafío importante en la investigación moderna de la visión por computadora.

El objetivo fundamental del presente trabajo fue obtener un conjunto de algoritmos capaces de lograr óptima calidad en la segmentación de imágenes y en particular en las imágenes biomédicas, las cuales por la física de formación han presentado características muy particulares, lo cual hace que la segmentación de imágenes sea una tarea de gran complejidad.

MÉTODOS

Las imágenes microscópicas seleccionadas fueron biopsias que representaron un proceso de angiogénesis en tumores malignos. Estas se han incluido en parafina mediante la técnica inmunohistoquímica con el método de avidina biotina. El monoclonal C034 ha contrastado con el metilo verde y ha acentuado la formación de nuevos vasos sanguíneos. Estas biopsias proceden de partes blandas del cuerpo humano y se obtuvieron en el Hospital Militar Carlos J. Finlay.

Por otra parte, el conjunto de datos de imágenes de hemorragias celébrales instantáneas se obtuvieron en el departamento de radiología del Hospital Morón, formado por 30 pacientes (cortes de 360 imágenes). Otras imágenes biomédicas fueron obtenidas en diferentes hospitales asistenciales de Cuba, mientras que las imágenes estándares se bajaron de bases de datos internacionales establecidas. 9 Caracterización de algunas de las imágenes de estudios se pueden observar en Rodríguez R, et al.10

Alguna teoría preliminar sobre los métodos matemáticos

Sea {x i } ( i = 1, 2, ……n) un conjunto arbitrario de n observaciones en el espacio Euclidiano d-dimensional R d , extraído de una función de densidad de probabilidades desconocida f. Según el conocimiento a priori que se tenga sobre f, una estimación de la función de densidad de probabilidades se ha podido construir sobre la base de 2 estrategias: paramétrica y no paramétrica. 5 Si se asume que los datos han sido una muestra de una cierta familia de distribuciones, por ejemplo la densidad normal a la estimación se le llama paramétrica. Los modelos de estimación de densidad que han tenido mayor número de grados de libertades y que han variado con la cardinalidad de los datos de la muestra se les han llamado no paramétricos.

La estimación multivariada de la densidad obtenida para un kernel K(x) y un ancho de banda h, calculada en el punto x, se ha definido como (ecuación 1):

A partir de dicha ecuación se desarrolló toda la teoría relacionada con la media desplazada y el algoritmo iterativo, el cual se expondrá posteriormente. Los detalles de dicha teoría se pueden ver en Rodríguez R, et al.10) y Rodríguez M, et al.12

Se precisará sobre el criterio de parada utilizado, el cual fue empleando el concepto de entropía. Desde un punto de vista físico la entropía se puede considerar como una medida del grado de desorden de un sistema dado. Por ejemplo, sea un sistema con N estados de ocurrencias, si la probabilidad de encontrar al sistema en cualquiera de los N estados es la misma, se dice que el desorden del sistema es máximo y en tal condición la entropía alcanza su valor extremo. Si algunos de los estados tienen mayor probabilidad que otros, la entropía y el desorden disminuye. Desde el punto de vista del procesamiento digital de imágenes la entropía se define como (ecuación 2)

donde B es la cantidad total de bits con que la imagen quedó digitalizada, y p(x) es la probabilidad de ocurrencia de un valor de gris. La extensión de esta expresión a 2 dimensiones es directa. Notar que en una región completamente uniforme la entropía alcanza el valor mínimo, pues teóricamente hablando la probabilidad de ocurrencia de los diferentes niveles de grises es 1. En la práctica al trabajar con imágenes reales la entropía no llega alcanzar el valor 0 debido al ruido existente en ellas. Por tanto, al considerar la entropía como una medida del grado de desorden de un sistema, esta puede ser usada como un buen criterio de parada en un proceso iterativo de filtrado de la media desplazada. En tal sentido, la entropía irá disminuyendo en cada región en la medida que estas se hagan más homogéneas y a la vez en toda la imagen hasta alcanzar un valor mínimo estable. Al llegar a la convergencia, se obtendría una imagen completamente segmentada, pues el filtrado a través de la media desplazada no se mostró idempotente. Otras propiedades de la entropía como una medida de bondad y más profundidad sobre la teoría se pueden encontrar en Rodríguez R, et al.13,16

Definición 1

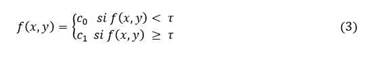

Sea N el conjunto de números naturales, sean (x, y) las coordenadas espaciales de una imagen digitalizada y sea L = { 0, 1, 2, ..., 2 B } un conjunto de números positivos que representan los niveles de grises, donde B es el número de bits por pixel. Entonces se puede definir una función de imagen, f: NxN→L. El nivel de gris de 1 pixel con coordenadas (x, y) se denota como f (x, y). Sea τϵ L un umbral y sea C = {c 0 , c 1 } un par de niveles de grises binarios, donde ((c 0 , c 1 ) ϵ L). El resultado de binarizar una función de imagen f (.,.) en el valor umbral τ es la función binaria f τ ∶NxN→C, tal que (ecuación 3):

Así los píxeles etiquetados con c 0 corresponden al fondo, mientras que los marcados con c 1 son los objetos, o viceversa. En este caso se dice que la imagen quedó segmentada en 2 niveles de grises (binarizada). Cuando τ depende solamente de f (x, y) el umbral se denomina estático y si este no se varía a lo largo de todo el proceso de binarización se considera una umbralización global. Esta técnica está dentro de las llamadas operaciones puntuales. Si τ depende a la vez de f (x, y) y γ (x, y) se denomina umbralización local o por zona. Cuando además τ depende de las coordenadas espaciales (x, y) el umbral se denomina dinámico. 12

Presentaremos un novedoso algoritmo de binarización para la segmentación de imágenes y en particular para las imágenes biomédicas que se desempeñan de forma no supervisada, publicado en Rodríguez R, et al.17-19

La morfología matemática sigue siendo un área activa y creciente en la visión artificial y el análisis de imágenes. Estudia la estructura geométrica inherente de una imagen y usa para sus operaciones una forma geométrica predeterminada conocida como elemento de estructura (EE). Sea F una imagen en sus niveles de grises y B un EE.

Definición 2

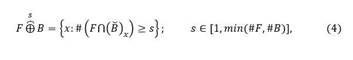

La dilatación generalizada de F por un elemento de estructura B con severidad igual a s se ha definido como (ecuación 4) 10

donde el símbolo # denota la cardinalidad del conjunto y / significa la reflexión de B desplazada por x.

Puesto que / la severidad s está limitada por min (#F, #B). Con esta generalización se eliminaron las dilataciones excesivas a causa de pequeñas intersecciones. Es decir, la masa de una intersección debe ser lo suficientemente grande para provocar un cambio. Para profundizar en toda la teoría relacionada con esta definición se pueden consultar Rodríguez R, et al.10,11) y Rodríguez M, et al. (12

Tomando como base la definición 2 y otros elementos de la morfología matemática, se desarrolló un algoritmo para la reconstrucción de imágenes y la eliminación del ruido de pico, el cual será expuesto más abajo.

Métodos algorítmicos

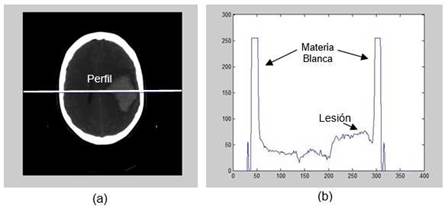

Desde el punto de vista de la visión por computadora (hoy insertado en el megacampo de la Inteligencia Artificial), el método más adecuado para el desarrollo de un buen algoritmo para resolver un problema dado en segmentación de imágenes tiene que pasar por el necesario análisis de las condiciones físicas y de fronteras de las imágenes originales. Dicho de otro modo, por la caracterización de las imágenes fuentes (conocido en el mundo de la estadística como el análisis de los datos). Aplicar algoritmos a ciega generalmente no ofrece buenos resultados. Por ejemplo, al analizar un perfil de una imagen de una hemorragia instantánea a través de la resonancia magnética nuclear se pueden observar características muy interesantes (figura 1).

Fig. 1 A) Perfil de intensidades a través del centro de la lesión. El perfil se indica por una línea blanca; b) coordenada “y” indica el valor de las intensidades.

Al observar la figura 1 uno puede notar que el valor de intensidad de la materia blanca está por encima de 200, de modo que si se quiere desarrollar un algoritmo para determinar solo la parte de la lesión lo más recomendable es primeramente eliminar la materia blanca con un simple umbral (pues esta puede introducir ruido en el proceso de segmentación), lo cual puede ser ejecutado de forma automática. 10 Muchos de los algoritmos autóctonos desarrollados pasaron por este tipo de análisis.

A continuación, se presentan algunos de los algoritmos desarrollados, los cuales fueron puestos a punto a través del método de investigación cuantitativo-cualitativo, seleccionándose como criterios verdaderos las imágenes delineadas por los especialistas y el resultado de la segmentación evaluado por ellos.

Esta sección abordó fundamentalmente algunos de los métodos matemáticos para la segmentación de imágenes; sin embargo, en visión por computadora no ha sido posible materializar esa teoría, si no se establece un conjunto de pasos (algoritmos) que permitan su aplicación en el megamundo de la IA. Por eso, en estos sistemas la teoría y el algoritmo están muy cerca y muchas veces en variados problemas prácticos, los algoritmos toman el liderazgo por tener implícita la experiencia y la heurística de los especialistas.

Seguidamente se expondrán 3 ejemplos de algoritmos autóctonos desarrollados por los autores, donde se podrá apreciar su sencillez algorítmica a pesar de la cierta complejidad teórica que subyace en todos ellos. Otros ejemplos de estrategias desarrolladas se podrán apreciar en Rodríguez R, et al.20-26

Algoritmo 1: algoritmo iterativo de la media desplazada (MSHi) con un nuevo criterio de parada

Datos: Imagen original B1, umbral edsEnt (10

Resultado: Imagen segmentada B2

En la versión anterior (año 2009) este algoritmo se detenía con el siguiente criterio de parada (ecuación 5) 14

donde E (•) es la entropía y ε es el umbral de parada establecido. Se pudo demostrar que este criterio no capta la diferencia real que existe entre las imágenes obtenidas durante el proceso de segmentación. Esto puede provocar que el algoritmo no se detenga a tiempo ocasionando una sobresegmentación o una subsegmentación al parar más rápido, donde en cualquiera de los 2 casos la imagen no quedaría debidamente segmentada. Esto conllevó a proponer un nuevo criterio de parada y todo un cuerpo teórico. 14,16,22,23,24. Aquí solo se hará mención al teorema fundamental de esa teoría, el cual garantiza la convergencia de la MSHi.

Teorema 1: Cuando la entropía de la diferencia entre las imágenes de una iteración y la siguiente es tomada como criterio de parada en el algoritmo iterativo de la media desplazada, cualquiera sea el umbral escogido, esta es condición suficiente para lograr la convergencia. Además, en el límite la entropía alcanza el valor 0.

Algoritmo 2: binarización de imágenes a través de un logaritmo paramétrico

Datos: Sea B1 la imagen original, y sea k un parámetro

Resultado: Sea B2 la imagen resultante

Entrar el parámetro k

Realizar un logaritmo paramétrico sobre la imagen B1, /*BWLOG(i,j)=(log(1+(exp(k)- 1)*double(B1(i,j))))/k;*/

Obtener el histograma de la imagen BWlOG. Sea h (BWLOG)

Obtener la frecuencia máxima del histograma h (BWLOG, y su índice (valor de intensidad) Sea bwlogi

Fijar en la matriz BWLOG el valor de bwlogi igual a 1 y el resto igual a 0. Sea BWLOGb el resultado obtenido

Multiplicar la imagen BWLOGb por (2B-1), donde B = bit/pixel. Salvar en B2

Retornar B2

Lo novedoso de este algoritmo es que se llevó a cabo un estudio teórico del parámetro k lo cual permitió obtener límites de confianza para lograr una óptima segmentación 17,18

Algoritmo 3: eliminación del ruido de pico a través de una reconstrucción morfológica

Datos: Sea B1 la imagen original, /* Imagen binarizada en bruto*/

Resultado: Sea B2 la imagen resultante

1. Realizar sobre la imagen B1 una apertura generalizada 11,13,26 con un elemento de estructura tipo círculo y diámetro igual a 37 pixeles con severidad igual a 9. Sea B3 la imagen resultante /* Imagen libre de ruido de pico*/

2. Etiquetar la imagen B1

3. Establecer una correspondencia entre las coordenadas B1 y B3

4. Clasificar las etiquetas en B3, las que no correspondan al patrón buscado (en este caso vasos sanguíneos (VS)) eliminarlas. Sea B4 la imagen resultante

5. Establecer en B2 todas las etiquetas de VS que permanecen en B4 en correspondencia a las mismas etiquetas de VS en la imagen B1

6. Retornar B2

RESULTADOS Y DISCUSIÓN

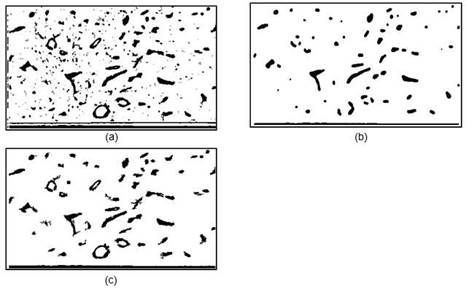

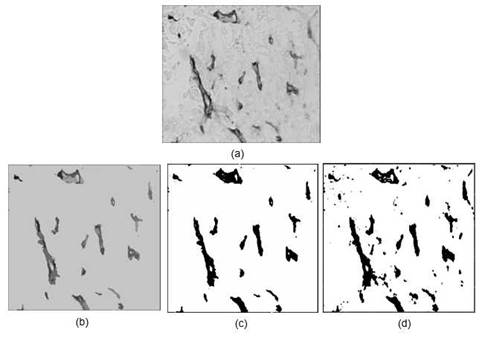

A continuación, se presentan los resultados obtenidos de acuerdo con los algoritmos propuestos. El objetivo consistió en poder aislar completamente los vasos sanguíneos (VS) en imágenes biopsia en tejido blando sin que se produjera pérdida de los VS, con el ánimo de llevar a cabo un mejor diagnóstico y pronóstico de la enfermedad (cáncer). En la figura 2 se puede ver el resultado obtenido con la aplicación del algoritmo 3.

Fig. 2 .Reducción de ruido mediante etiquetado de componentes. A) imagen original (imagen segmentada). B) Apertura mediante el uso de un elemento de estructura circular que contiene 37 píxeles y severidad 9. C) Resultado de la aplicación del algoritmo.

En la estrategia, el paso más significativo fue el proceso de filtrado para eliminar el ruido de la imagen segmentada. El objetivo fue logrado ya que el tamaño seleccionado del elemento de estructura fue el adecuado. Según criterios de los especialistas (patólogos), la estrategia ofreció buenos resultados, ya que las imágenes obtenidas estaban completamente libres de ruido, manteniendo el número de vasos sanguíneos, su tamaño y forma.

A continuación, se presentan los resultados obtenidos al segmentar otra imagen de vasos sanguíneos mediante un paso de filtrado con el algoritmo iterativo de la media desplazada (MSHi) y el algoritmo de binarización y una comparación con el método clásico de Otsu. Es importante señalar que se aplicó la técnica de Otsu de forma local para atenuar la creación de ruido impulsivo y aún se evidencia el mejor resultado, en cuanto a limpieza, obtenido con nuestra estrategia. La figura 3 muestra el resultado de la segmentación.

Fig. 3 . A) Imagen original. B) Imagen filtrada a través de la MSHi. C) Imagen binarizada a través del algoritmo no. 2. D) Segmentación obtenida mediante el método de Otsu (se evidencia el ruido que genera esta técnica, una de las mejores entre las clásicas).

Otro ejemplo de resultado utilizando la estrategia de la figura 3, se muestra en la figura 4.

Fig. 4 .A) Imagen original. B) Imagen filtrada a través de la MSHi. C) Imagen binarizada a través del algoritmo no. 2. D) Segmentación obtenida mediante el método de Otsu (resultado muy parecido al anterior).

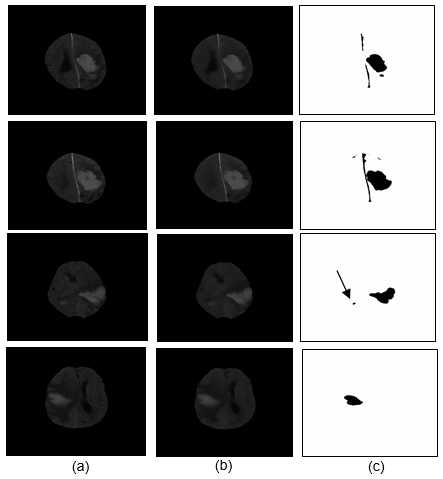

En la figura 5 se muestra la aplicación de los algoritmos 1 y 2, algunos resultados en la segmentación de imágenes de hemorragias cerebrales instantáneas.

Fig. 5. A) Imágenes originales de hemorragias cerebrales instantáneas. B) Imágenes filtradas a través del algoritmo de la MSHi. C) Binarización usando el algoritmo 2. Otro ejemplo del algoritmo 1 aplicado de forma directa sobre la enfermedad del glaucoma se muestra en la figura 6. 25

Fig. 6. A) Imagen original. B) Segmentación usando el algoritmo 1. La flecha indica la lesión del glaucoma aislada.

Anteriormente se hizo mención a los resultados obtenidos de la segmentación al aplicar los algoritmos desarrollados a algunos ejemplos de bioimágenes. La extensión en su aplicación a otras imágenes estándares se puede ver en R. Rodríguez et al.14) R. Rodríguez (17) y R. Rodríguez (18.

La característica más notable de estos algoritmos es que son completamente originales y autóctonos y su novedad científica viene dada en su fácil implementación, baja complejidad algorítmica al utilizar muy pocos parámetros y que son bastante independientes de las imágenes a procesar. Por ejemplo, los resultados obtenidos en el aislamiento de las hemorragias cerebrales instantáneas (figura 5) con un solo parámetro k se procesaron todas las imágenes. Además, se pudo constatar que en un rango de valores cerrados de dicho parámetro se obtuvieron los mismos resultados. 17,18

Uno de los problemas que han presentado muchos algoritmos de segmentación de imágenes ha sido el excesivo uso de parámetros, los cuales muchas veces hay que cambiar, incluso, para grupos de imágenes tomadas en las mismas condiciones de contorno lo cual hace que se pierda unicidad en los resultados. Con nuestros algoritmos no sucede así, lo cual da una medida de la originalidad de los mismos, además, toman en consideración, en todo momento las condiciones de captación físicas-espaciales de las imágenes.

A decir de los especialistas patólogos, los resultados presentados en las figuras 2, 3 y 4 en relación al aislamiento de los vasos sanguíneos han sido novedosos y muy superiores a los alcanzados en algoritmos anteriores desarrollados por los propios autores. En estas nuevas estrategias los resultados de la segmentación se obtuvieron en forma directa, sin la necesidad de la concatenación de varios algoritmos. Observar que estos resultados fueron fruto de un filtrado no supervisado a través de la media desplazada y a continuación aplicar el algoritmo 2. Se evidenció la calidad de nuestros resultados comparados con el método clásico de Otsu y otros que no se mostraron en este trabajo, lo cual ha ofrecido una medida del impacto científico.

Es importante destacar en la figura 5, cómo las lesiones de hemorragias cerebrales instantáneas fueron casi perfectamente aisladas, lo cual ha sido base para posteriores estudios automatizados morfométricos, independientemente de la subjetividad que le pueda aportar un médico especialista.

El resultado que se muestra en la figura 6 causó muy buena impresión en los oftalmólogos ya que son imágenes que presentan características de mucha información de altas frecuencias espaciales (venas, vasos sanguíneos, arterias, etc.) lo cual ha hecho que la segmentación de este tipo de imágenes no sea trivial. Sin embargo, el algoritmo 1 fue capaz de discriminar la zona del glaucoma de la otra información considerada como fondo. La explicación de este comportamiento viene dada por el hecho de que la MSHi hace función de filtro pasa bajo y de forma adaptativa (o sea, localmente según los parámetros h s y h r ) es decir, que atenúa la información de altas frecuencias espaciales (puntos, bordes, esquinas, líneas, etc.). Eso explica el por qué elimina todas las venillas y arterias, y deja únicamente la parte central de la enfermedad del glaucoma. Aquí, por problema de espacio, se puso solo un ejemplo, pero se procesaron una base de datos de más de 50 imágenes.

Intencionadamente se pusieron más ejemplos de procesamiento de imágenes de tumores malignos en tejido blando (proceso de angiogénesis) y de hemorragias cerebrales que de otras enfermedades, por encontrarse estas patologías entre las primeras y segundas causas de muertes y de morbilidades en Cuba. Otras muchas imágenes, tomando como base estos algoritmos, fueron procesadas con resultados muy alentadores.

Desde el punto de vista social, la creación de algoritmos autóctonos ha resultado de importancia estratégica para el desarrollo de cualquier país, sobre todo si se quiere lograr -en esta era de internet y la IA- soberanía e independencia algorítmica, lo cual ha permitido -además de crear una base de conocimiento- que estas estrategias (por no constituir cajas negras) pudieran ser adaptadas y aplicadas al estudio de nuevos patrones de imágenes, como pudiera ser el caso del estudio imagenológico de nuevos virus y bacterias.

Conclusiones

En el trabajo se propusieron 3 ejemplos de algoritmos autóctonos (todos originales) que se desarrollaron como consecuencia de un estudio pormenorizado de las características de las imágenes a procesar, incluyendo el análisis físico de las condiciones de fronteras en la captación. Las estrategias cumplieron con el objetivo de obtener un proceso de segmentación óptimo, lo cual se evidenciaron en los resultados presentados. Además, los mismos cumplieron con los intereses de los especialistas en la obtención de imágenes segmentadas nítidas y limpias de ruido espurio, lo cual fue avalado por las buenas evaluaciones llevadas a cabo por ellos.

Los algoritmos propuestos presentaron baja complejidad algorítmica (a pesar de la teoría que en ellos subyace), lo cual ha estado respaldado por la poca cantidad de parámetros utilizados, lo que facilitó una sencilla implementación. La aplicación a otros tipos de imágenes también fue directa lo que se recogió en las referencias bibliográficas presentadas.