Mi SciELO

Servicios Personalizados

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista Cubana de Informática Médica

versión On-line ISSN 1684-1859

RCIM vol.9 no.1 Ciudad de la Habana ene.-jun. 2017

ARTÍCULO ORIGINAL

Cadenas de markov aplicadas al análisis de la ejecución de proyectos de investigación

Markov chains applied to the analyzis of the progress of research projets

M.Sc. Ing. Eduardo López Hung,I M.Sc. Lic. Lai Gen Joa TriayII

I Universidad de Ciencias Médicas de Santiago de Cuba. Profesor de Informática y Matemática Aplicada. Profesor Asistente. Investigador Agregado. E-mail: elopezh@fts.scu.sld.cu

II Universidad de Oriente. Profesora Adjunta de Investigación de Operaciones. Profesora Asistente. E-mail: lai@infotur.tur.cu

RESUMEN

La administración moderna requiere el apoyo de herramientas de diferentes ramas de la ciencia que ayuden al proceso de toma de decisiones, como por ejemplo la Matemática Aplicada. En este contexto aparecen variables aleatorias que con el transcurso del tiempo cambian, y que pueden ser representadas a través de modelos cuantitativos. Cuando en estos modelos el estado presente de dichas variables resume toda la información anterior para describir cómo se comportarán en el futuro, se dice que se está en presencia de una cadena de Markov; una herramienta eficiente para el análisis de procesos de esta naturaleza, como por ejemplo la ejecución de proyectos de investigación, el cual reviste gran importancia en la gestión de ciencia e innovación tecnológica; área de resultados clave en cualquier universidad. En la Facultad de Tecnología de la Universidad de Ciencias Médicas de Santiago de Cuba, el análisis de la ejecución de los proyectos de investigación se consideró como una cadena de Markov, definiendo los diferentes estados por los que puede estar un proyecto, y las probabilidades de que este se encuentre en un estado determinado a partir del estado en que se encontraba. Así se determinaron elementos que permiten apoyar la toma de decisiones a corto y a largo plazo, a partir de datos históricos durante el trienio 2013 – 2015, relacionados con la cantidad promedio de inspecciones a los mismos, probabilidades de un proyecto cerrar, etc.; permitiendo pronosticar en términos de probabilidades el estado de este subsistema en el futuro.

PALABRAS CLAVE: proyectos de investigación, cadenas de Markov, enfoque estocástico, métodos cuantitativos, matemática aplicada.

Modern management tools require support from different branches of science to help the decision–making process, such as Applied Mathematics. In this context, random variables with change over time, and that can be represented by quantitative models appear. When these models in the present state of these variables summarizes all the previous information to describe how they will behave in the future, it is said that we are in the presence of a Markov chain; an efficient tool for the analysis of processes of this nature, such as the execution of research projects, which is of great importance in the management of science and technological innovation; key result area at any university. In the Faculty of Technology, University of Medical Sciences of Santiago de Cuba, the analysis of the implementation of research projects was considered as a Markov chain, defining the different states through which can be a project and the odds of this is in a certain state from the state it was. And support elements that enable decision–making in the short and long term, from historical data in the period 2013 – 2015 were determined, related to the average number of inspections to a project, the probability of a project likely to close, etc.; allowing to predict in terms of probabilities the status of this subsystem in the future.

KEY WORDS: research projects, Markov chains, stochastic approach, quantitative methods, applied mathematics.

INTRODUCCIÓN

Muchos son los defensores de que en el proceso de toma de decisiones en la administración se debe tener en cuenta tanto los factores objetivos como subjetivos entorno a ella. Un gran número de administradores toman partida en utilizar métodos objetivos, o llamados también cuantitativos, los que con un fuerte basamento matemático formal, modelan la situación en la cual hay que decidir por una alternativa, planificar, asignar, y realizar toda una serie de actividades que pueden comprometer en un momento determinado la organización. Por otro lado, están quienes defienden los métodos subjetivos, también llamados cualitativos, pues alegan que el entorno convulso que vive una organización hace de la administración una actividad sujeta a las condiciones del medio que le rodea y de los individuos implicados.1

En este trabajo se asume que tanto los métodos cuantitativos como los cualitativos son importantes, y la correcta administración de una organización implica la precisa conjugación de todos ellos; pero no es menos cierto que los métodos cuantitativos, han sido creados sobre una base científica mucho más sólida que los otros, donde en los resultados de su aplicación están exentos de la fuerza imponente de quien dirige. De esta forma se parte de un modelo cuantitativo que describa el evento o fenómeno, el cual constituye un modelo matemático del sistema real bajo estudio.2-3

Dentro de los métodos cuantitativos para la toma de decisiones, el enfoque estocástico propone el estudio de una variable aleatoria que evoluciona en el tiempo.4-5 Un proceso estocástico es llamado específicamente una Cadena de Markov –que debe su nombre al matemático ruso Andrei Andreevitch Markov–, cuando en este modelo aparece una sucesión de variables aleatorias tal que el "siguiente" estado del proceso es independiente de los estados anteriores, siempre que sea conocido el estado presente.5-6 Estas variables aleatorias, que constituyen los denominados "estados de transición", aparecen con bastante definición y regularidad en el área de la administración.

En el caso específico de la Gestión de Ciencia e Innovación Tecnológica por ejemplo, un área de gran importancia en el que este tipo de enfoque pudiera aplicarse sería el de proyectos de investigación, subsistema clave dentro de esta área de resultados. Este trabajo muestra cómo en la Facultad de Tecnología de la Salud de la Universidad de Ciencias Médicas de Santiago de Cuba, se favoreció el análisis de la ejecución de los proyectos de investigación desde esta perspectiva, desde que inician el proceso de certificación hasta que sellan sus expedientes.

De ahí que el objetivo de este trabajo es determinar desde un enfoque estocástico las variables que permitan analizar el comportamiento de la ejecución de los proyectos de investigación en dicha Facultad, en función de la toma de decisiones a corto y mediano plazo.

METODOLOGÍA

Un proyecto de investigación (en lo adelante el proyecto) tiene como duración mínima un año. Estos se inspeccionan mensualmente para verificar el cumplimiento del cronograma y de los resultados esperados. Como resultado de la inspección, un proyecto puede encontrarse en cuatro estados: ejecución normal, atrasado, cancelado o terminado.

Se realizó una revisión de datos históricos de los proyectos de investigación de la Facultad, en el período comprendido en el trienio 2013 – 2015, así como los expedientes de los mismos. Se pudo determinar que si un proyecto en la inspección anterior quedó en ejecución normal, tiene una probabilidad de 0.40 de permanecer en ejecución normal o de terminarse, aunque una probabilidad de 0.20 de atrasarse. Si en la pasada inspección quedó atrasado, tiene una probabilidad de 0.50 de seguir con atrasos, 0.40 de ser cancelado y un 0.10 de recuperar el atraso y pasar a ejecución normal. Los proyectos que pasen a la condición de cancelados o terminados se les cierra el expediente.

Considerando que la secuencia de estados por lo que puede transitar el proyecto, se comporta como un proceso estocástico, especialmente como una cadena de Markov, se necesita realizar un análisis, que permitan determinar

- El número total promedio de inspecciones que tendrán lugar antes de que el proyecto se termine o sea cancelado si se encuentra en ejecución normal o atrasado.

- La probabilidad que tiene un proyecto de terminar o ser cancelado, si comienza en ejecución normal o en estado atrasado.

Por la naturaleza del mismo, y por la solidez de los datos con que se contaba, se decidió utilizar métodos cuantitativos para la toma de decisiones, a partir de un enfoque estocástico, especialmente visto el proceso como una cadena de Markov, ya que se puede considerar como un sistema constituido por una serie de eventos, en el cual la probabilidad de que ocurra un evento depende del evento inmediato anterior. Esta dependencia las distingue de las series de eventos independientes. De ahí que se defina como un proceso estocástico que cumple con la propiedad de Markov, que plantea que si se conoce la historia del sistema hasta su instante actual, su estado presente resume toda la información relevante para describir en probabilidad su estado futuro.4

Para ello se definieron los diferentes estados por lo que podían transitar los proyectos de ejecución durante su ciclo de vida. Ellos son:

· E: Ejecución normal.

· A: Atrasado.

· C: Cancelado.

· T: Terminado.

Teniendo en cuenta las probabilidades anteriores, se definió la matriz de transición, como se muestra en la Tabla 1.

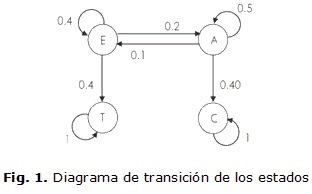

A partir de la tabla anterior, se definió el diagrama de transición de los estados, el cual se muestra en la Figura 1.

Como se puede observar en el diagrama, la cadena cuenta con dos conjuntos

· Conjunto transiente, compuesto por los estados en los que se puede llegar a cualquier otro estado desde cualquier estado de este, pero una vez que se abandona, nunca más se podrá alcanzar: {E, A}.

· Conjunto absorbente o ergódico, compuesto por los estados a los que se puede llegar desde cualquier estado, pero no podrá salir: {C, T}.7

Al observar que la cadena está formada por conjuntos ergódicos y conjuntos transientes, se puede decir que la cadena es una cadena reducible, ya que independientemente del estado donde se parta, la probabilidad de que el proyecto esté en un estado ergódico tiende a 1 después de n inspecciones. Para un número grande de inspecciones el proceso quedará atrapado o reducido a los estados ergódicos o absorbentes.8 Luego esta cadena es una cadena de Markov reducible absorbente.

RESULTADOS Y DISCUSIÓN

Matriz fundamental

Se obtuvo la forma canónica de la matriz de transición (ver Tabla 2).

Como se puede apreciar, la submatriz de estados transientes Q es la señalada con el fondo azul, la cual servirá para determinar la matriz fundamental, concepto que permite en gran medida dar respuestas a las interrogantes planteadas.

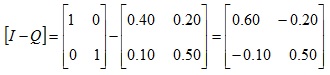

Luego se obtuvo la diferencia [I – Q], donde I es la matriz idéntica de igual orden a la matriz Q, obtenida anteriormente.

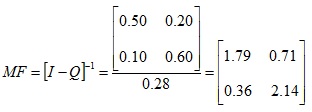

Al hallar la transpuesta de la matriz anterior que al ser de orden 2 por definición es la inversión de la diagonal principal y el cambio de signo del resto de sus elementos, y a la vez hallar el determinante de [I – Q], resultando que |[I – Q]| = 0.28, se obtuvo la matriz fundamental (en lo adelante MF):

Interpretación:

· Un proyecto de investigación que se inicie en ejecución normal tiene como promedio 1.79 inspecciones mensuales donde estará en ejecución normal y 0.71 meses de atrasos, antes de terminar o ser cancelado.

· Un proyecto de investigación que reinicie su ejecución en estado atrasado tiene como promedio 0.36 inspecciones mensuales donde estará en ejecución normal y 2.14 meses de atrasos, antes de terminar o ser cancelado.

· De la primera fila de MF, se obtiene que 1.79 + 0.71 = 2.50, lo que significa que un proyecto de investigación que se inicie en ejecución normal estará 2.50 inspecciones mensuales como promedio en ejecución antes de terminar o ser cancelado.

· De forma análoga, de la segunda fila de MF, se obtiene que 0.36 + 2.14 = 2.50, lo que significa que un proyecto de investigación que se reinicie en un estado atrasado estará 2.50 inspecciones mensuales como promedio en ejecución antes de terminar o ser cancelado.

Probabilidades de absorción por los estados absorbentes

Como existen dos estados absorbentes, se hallarán los vectores de probabilidades de absorción: XT (vector de probabilidades de absorción por el

estado absorbente: Terminado) y XC (vector de probabilidades de absorción por el estado absorbente: Cancelado).

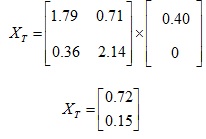

XT= MFX RT

Donde RT es el vector correspondiente a la transición de los estados transientes al estado absorbente T, el cual se toma de la matriz de transición en su forma canónica.

luego

Interpretación:

Esto significa que un proyecto de investigación tiene una probabilidad de ser absorbido por el estado T de 0.72 si inicia en ejecución normal y de 0.15 si reinicia en el estado de atrasado.

De forma análoga se calcula XC:

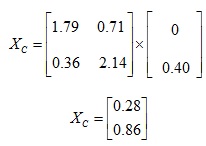

XC= MFX RC

donde RC es el vector correspondiente a la transición de los estados transientes al estado absorbente C, el cual se toma de la matriz de transición en su forma canónica.

luego

Interpretación:

Esto significa que un proyecto de investigación tiene una probabilidad de ser absorbido por el estado C de 0.28 si inicia en ejecución normal y de 0.86 si reinicia en el estado de atrasado.

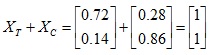

Se puede comprobar que al cabo de un número determinado de inspecciones mensuales, el proyecto estará en uno de los dos estados absorbentes. Esto se puede comprobar de la siguiente forma:

Los resultados mostraron que:

- Existe una alta probabilidad de que un proyecto que inicie con ejecución normal pueda terminar sin caer en atrasos.

- Se debe trabajar de manera intencional y sostenida con los proyectos atrasados para poder llevarlos a ejecución normal, y puedan terminar.

- Los proyectos en ejecución normal o atrasados estarán en ejecución de dos a tres inspecciones como promedio antes de cerrar sus expedientes, bien sea por haber terminado o haber sido cancelados.

CONCLUSIONES

El enfoque estocástico se presenta muchas veces en los procesos administrativos, ya que existen variables aleatorias, cuyos valores son estados característicos de los mismos. Las Cadenas de Markov constituyen una herramienta eficiente para el análisis a corto y a largo plazo de procesos que cambian de estado con el transcurso del tiempo, en los que la probabilidad de estar en un estado determinado depende del estado en el cual se encontraba el sistema.

El análisis de la ejecución de proyectos de investigación en Salud pudo considerarse como una cadena de Markov, definiendo los diferentes estados por los que puede pasar un proyecto y las probabilidades de que este se encuentre en un estado determinado a partir del estado en que se encontraba.

En el caso de la Facultad de Tecnología de la Salud de la Universidad de referencia, se pudo determinar elementos o variables que permiten la toma de decisiones a corto y a largo plazo, a partir de datos históricos durante el trienio 2013 – 2015, relacionadas con el número de transiciones, la probabilidades de terminar en un estado absorbente, partiendo de un algún estado transiente, permitiendo de alguna forma pronosticar en términos de probabilidades el estado de este subsistema en el futuro. Los resultados obtenidos muestran un estado general favorable en cuanto a la ejecución de los proyectos de investigación de la Facultad.

REFERENCIAS BIBLIOGRÁFICAS

1. Gallagher C. A, Watson H. J. Métodos Cuantitativos para la Toma de Decisiones en Administración. Editorial Ciencias Médicas. La Habana, 2008.

2. Escalona P. Métodos Cuantitativos para la Administración. Material básico de Métodos Cuantitativos para la Administración de la Maestría en

Matemática Aplicada e Informática para la Administración. Universidad de Holguín. Holguín, 2008.

3. Hillier F. S, Lieberman G.J. Introducción a la Investigación de Operaciones. Novena Edición. Mc Graw Hill. México D. F, 2010.

4. Escalona P. Apuntes sobre Cadenas de Markov. Material básico de Métodos Cuantitativos para la Administración de la Maestría en Matemática Aplicada e Informática para la Administración. Universidad de Holguín. Holguín, 2008.

5. Allen M. A. Dilataciones Unitarias y Cadenas de Markov. Trabajo especial de grado para optar por el título de Licenciada en Matemática. Universidad Central de Venezuela. Caracas, 2005.

6. Álvarez M. Modelos Económicos – Matemáticos II. Tomo 1. Editora ISPJAE. La Habana, 1987.

7. Meyn S. P, Tweedie R. L. Markov Chains and Stochastic Stability. Second Edition. Cambridge University Press. Cambridge, 2009.

8. Peschek, W. Modelos de input – output y cadenas de Markov. Management Mathematics for European Schools. [Consultado en enero de 2014]. Disponible en: http://www.mathematik.unikl.de/mamaeusch/

Recibido: 20 de noviembre de 2016.

Aprobado: 12 de marzo de 2017.