Mi SciELO

Servicios Personalizados

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

MediSur

versión On-line ISSN 1727-897X

Medisur vol.13 no.4 Cienfuegos jul.-ago. 2015

ARTÍCULO ORIGINAL DE INVESTIGACIÓN PEDAGÓGICA

Valoración metodológica de temarios de exámenes finales de las carreras de Medicina, Estomatología y Enfermería

Methodological Evaluation of the Final Examinations of Medicine, Dentistry and Nursing

Margarita Rosa Romeu Escobar , Jose Aurelio Díaz Quiñones

Universidad de Ciencias Médicas, Cienfuegos, Cienfuegos, Cuba, CP: 55100

RESUMEN

Fundamento: en la Universidad de Ciencias Médicas de Cienfuegos no existen estudios que aporten una visión general de los aciertos y desaciertos en la confección de temarios de exámenes, por lo cual se desconoce en qué medida se cumplen las recomendaciones para la elaboración de los temarios de exámenes finales.

Objetivo: valorar aspectos metodológicos de temarios de exámenes finales de las carreras de Medicina, Estomatología y Enfermería.

Métodos: se realizó un estudio descriptivo, en la Universidad de Ciencias Médicas de Cienfuegos, durante los cursos 2012/2013 y 2013/2014. Se revisaron 109 temarios de exámenes finales (a razón de dos por asignatura) de las carreras de Medicina, Estomatología y Enfermería, que sumaron 629 preguntas. Se revisaron los programas de las asignaturas, contrastándose objetivos y habilidades declaradas con los contenidos a evaluar.

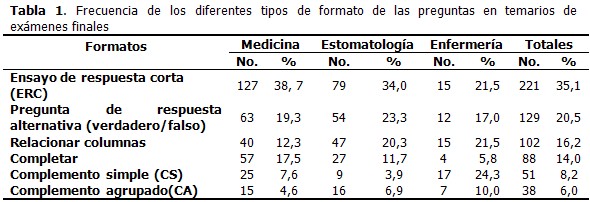

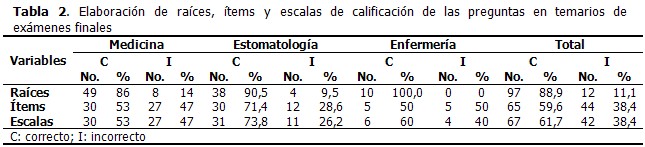

Resultados: el formato de pregunta más utilizado fue el ensayo modificado de respuestas cortas. De los 109 temarios, 88,9 % tuvo las raíces bien confeccionadas, 59,6 % los ítems bien elaborados y 61,6 % las escalas de calificación correctas. Los errores más frecuentes fueron: omisión del asunto o contenido en las raíces de las preguntas; tarea imprecisa en preguntas de ensayo modificado; y preguntas tipo complemento simple con tres opciones de respuestas. El 64,7 % de las preguntas fueron reproductivas.

Conclusión: la mayoría de los temarios está confeccionada adecuadamente, pero se observaron dificultades en la elaboración de preguntas y escalas de calificación. El alto porcentaje de preguntas reproductivas se constató como una debilidad, al limitar la validez conceptual.

Palabras clave: metodología, evaluación educacional, preguntas de exámenes, estudiantes de medicina, estudiantes de odontología, estudiantes de enfermería.

ABSTRACT

Background: there are no studies providing an overview of the strengths and weaknesses in the design of final examinations in the medical university of Cienfuegos; consequently, it is unknown to what extent the recommendations for constructing those exams are met.

Objective: to evaluate methodological aspects of the final examinations of Medicine, Dentistry and Nursing.

Methods: a descriptive study was conducted at the medical university of Cienfuegos during the 2012/2013 and 2013/2014 academic years. One hundred nine final exams (at a ratio of two per subject) of the Medicine, Dentistry and Nursing programs were reviewed, for a total of 629 questions. The syllabi were analyzed, contrasting the objectives and skills with the contents to be examined.

Results: The most common question format was the modified essay question requiring short answers. Of the 109 exams, 88.9 % had well-constructed stems, 59.6% well-designed items and 61.6% correct rating scales. The most frequent errors were omission of the subject or content in the stem of the questions; imprecise task in modified essay questions; and multiple-choice questions with a simple alternative to be selected out of three. Sixty four point seven percent of the questions involved reproduction of knowledge.

Conclusion: most of the exams are properly designed, but there are some difficulties in the construction of questions and rating scales. The high percentage of questions aimed at reproducing knowledge was regarded as a weakness since they limit the conceptual validity.

Key words: methodology, educational measurement, examination questions, students, medical, students, dental, students, nursing.

INTRODUCCIÓN

La evaluación del aprendizaje es, probablemente, el componente del proceso enseñanza –aprendizaje que más debates origina y que más variaciones conceptuales ha experimentado. En varios documentos rectores están declaradas las normativas de los sistemas de evaluación de las asignaturas que componen los planes de estudio de la Educación Médica Superior en Cuba.1-3 El examen escrito es la modalidad utilizada en la mayoría de los exámenes finales y debe evaluar objetivos declarados en los programas de las asignaturas. Lo precede generalmente un examen práctico donde se evalúan habilidades específicas, técnicas y procedimientos inherentes a cada asignatura, según se trate de asignaturas de formación básica, básico-clínica o clínica.2,3 La evaluación sigue siendo un componente del proceso enseñanza –aprendizaje recurrentemente incluido en planes de trabajo metodológico. Durante años se ha sistematizado la orientación metodológica a los profesores sobre la confección de exámenes escritos, utilizando diferentes vías, por lo que se considera que el claustro está apto para esta tarea. Diversos métodos para evaluar calidad en la confección de temarios, su poder discriminativo y validez, se han desarrollado en diferentes facultades del país.4-6 En la Universidad de Ciencias Médicas de Cienfuegos no se ha realizado ningún estudio que permita obtener una visión general de los aciertos y desaciertos en la confección de temarios de exámenes, por lo cual no se conoce con precisión cómo se cumplen las recomendaciones para la elaboración de los temarios escritos para exámenes finales. Consecuentemente, el objetivo de la presente investigación es valorar el cumplimiento de algunos aspectos metodológicos de la confección de temarios de exámenes finales de las asignaturas de las carreras de Medicina, Estomatología y Enfermería en dicha institución.

MÉTODOS

Se realizó un estudio descriptivo, en la Universidad de Ciencias Médicas de Cienfuegos, durante los cursos 2012/2013 y 2013/2014. Fueron analizados los temarios de exámenes finales escritos de asignaturas propias de las Ciencias de la Salud, durante los cursos académicos ya mencionados, de las carreras de Medicina, Estomatología y Enfermería, las cuales fueron elegidas por ser las más representativas en términos de matrícula. Se revisaron 109 temarios: dos temarios de exámenes por asignatura, con 629 preguntas. Los autores seleccionaron los temarios al azar, a partir de los que estaban disponibles en departamentos docentes. De la carrera de Medicina se incluyeron temarios de 29 asignaturas, de las 31 posibles. En una asignatura de Medicina solo se tuvo acceso a un temario, por lo que se revisaron 57. En Estomatología se incluyeron temarios de 21 asignaturas, de las 31 posibles; por tanto, se revisaron 42 temarios. La exclusión de asignaturas en ambas carreras, se debió a que los temarios no estuvieron disponibles para los autores, por diversas razones. Se excluyó también el internado de Medicina por tener características particulares y concluir con examen estatal. De Enfermería se incluyeron dos temarios de las asignaturas Enfermería de Urgencias de 4to año y dos de cada una de las cuatro estancias de Práctica Preprofesional de 5to año, correspondientes con nivel profesional, ya que en los momentos en que se realizaba el estudio, el resto de los exámenes eran de nivel técnico; por tanto, se revisaron 10 temarios. Para seleccionar los aspectos metodológicos a evaluar, variables del estudio, se tuvieron en cuenta las recomendaciones para el uso de preguntas test objetivos, que se originaron de las pautas ofrecidas por el DrC. Salas Perea durante el diplomado impartido en esta institución y de otras fuentes,7-9 así como de la experiencia profesional acumulada por los autores. Se analizaron los siguientes aspectos: Para obtener la información relacionada con las variables, se analizaron detenidamente los temarios, así como los programas de las asignaturas. Esta investigación contó con la aprobación del Consejo Científico de la institución.

RESULTADOS

De los 109 temarios el 57 % estuvo conformado por 7 preguntas y el resto por 5 preguntas. Las preguntas tipo ERC (35,1 %) fueron las más utilizadas, más en Medicina que en el resto. Las preguntas con formato CS fueron muy pocas (8,2 %) salvo en Enfermería (24,3 %). Las preguntas de repuesta alternativa fueron habitualmente muy empleadas (20,5 %). El resto de los formatos se usaron a discreción, siendo el menos frecuente el tipo complemento agrupado (6,0 %). (Tabla 1). De los 109 temarios, el 88,9 % tenía las raíces bien confeccionadas, el 59,6 % los ítems bien elaborados y el 61,6 % las escalas de calificación correctas. Se destacan los buenos resultados en la elaboración de raíces, sobretodo en Enfermería con el 100 % de las raíces de las preguntas correctas. Se encontraron más dificultades en la elaboración de ítems en las carreras de Medicina (47 %) y Enfermería (50 %). También, en Medicina y Enfermería hubo 47 % y 40 % de errores, respectivamente, en las escalas de calificación. (Tabla 2). En cuanto a las raíces de las preguntas, el desacierto encontrado con más frecuencia fue el planteamiento de la tarea de forma directa, sin introducir el asunto o contenido de forma previa. En la elaboración de ítems, se observó: tareas ambiguas, particularmente en el formato de ERC no se precisó el alcance o el número de elementos a aportar en la respuesta; formato de complemento simple con tres opciones de respuesta; preguntas de relacionar con distractores en ambas columnas o heterogeneidad de los elementos comparados, o bien sin distractor con igual número de elementos en ambas columnas; preguntas de completar con posibilidades para varias respuestas, o con múltiples espacios sucesivos o intermedios, o con falta de coherencia gramatical; y modificaciones parciales de formatos o mezcla de ítems. En las escalas de calificación, las dificultades más frecuentes fueron el situar un punto de corte de la escala en menos del 70 % para el aprobado, así como la elaboración de escalas incompletas. Con respecto a la coincidencia entre los objetivos de los programas y los contenidos evaluados, el desacierto fundamental fue el predominio de nivel de asimilación reproductivo, sobre todo en Estomatología. De las 629 preguntas, 407 (64,7 %) fueron de tipo reproductivo. En Medicina, 194 (59 %) preguntas fueron reproductivas, en Estomatología 173 (74 %) y en Enfermería 41 (58 %).

DISCUSIÓN

En los temarios de exámenes revisados, predominaron los que abordan un tema por pregunta, siendo escasos los que integraban contenidos de varios temas en una pregunta o aplicaban el análisis progresivo, aún cuando las características de la asignatura lo permitían. Se observó con frecuencia el formato de tipo mixto, con preguntas de ERC y de test objetivo, lo cual es muy favorable, ya que las preguntas de ERC muestran las capacidades de los estudiantes para expresar de forma lógica ideas esenciales, además de que permite evaluar aspectos ortográficos y de redacción, de manera que se obtiene un balance adecuado con las de test objetivo. No obstante, a veces fueron utilizadas para citar, enumerar o identificar pocos elementos asociados o no a situaciones- problemas, casos en los que no se aprovecharon todas sus ventajas. El formato verdadero/falso es muy utilizado debido a que, aparentemente, es de fácil elaboración, sin embargo, puede tener poca validez si no se cumplen las recomendaciones requeridas a la hora de confeccionarlo. Las preguntas con formato de CS permiten discriminar adecuadamente los conocimientos de los estudiantes y abarcar mayor cantidad de contenidos de uno o varios temas, por lo que es lamentable que sea tan limitado su uso (8,2 % del total de preguntas). Por otro lado, se reconoce la poca pertinencia del uso de pocas preguntas tipo CA en exámenes cortos, por su calificación extrema: 2 o 5. Por supuesto sería posible utilizarlas si se elaboraran varios incisos tipo CA en la misma pregunta. De los aspectos formales analizados, los mejores resultados se obtuvieron en la elaboración de las raíces de las preguntas, en lo que se destacó la carrera de Licenciatura en Enfermería, cuyos temarios mostraron todas las raíces de preguntas correctamente elaboradas. En este aspecto el desacierto más importante fue omitir la introducción al asunto o tema de la pregunta; elemento este de gran importancia, pues la introducción orienta al estudiante respecto a la tarea a cumplir y el temario gana en calidad y armonía, en contraposición a un temario donde solamente se reflejen órdenes a ejecutar en abstracto. Acerca de las imprecisiones más importantes, atendiendo al formato de pregunta, es conveniente comentar que es un requisito de las preguntas de ensayo que se explique exactamente el alcance, o sea, lo que se quiere que responda el estudiante, tanto cualitativamente como en términos de cantidad de elementos que se solicitan, en caso de que el número no sea estrictamente exacto por el propio contenido de la pregunta. La ambigüedad de la tarea indicada no aumenta el rigor de la pregunta, pero sí dificulta la respuesta.9,10 Existen estudios que demuestran que la capacidad para comprender enunciados de preguntas y problemas en los exámenes. es un factor clave, por lo que elaborarlos con precisión es imprescindible.9,10 Los autores consideran que el formato de CS con tres opciones de respuesta por inciso, resta validez a la pregunta, al facilitar respuestas que pueden decidirse al azar sin que estén avaladas por real conocimiento. Por otra parte, el formato de relacionar columnas con heterogeneidad de los elementos a comparar, conduce al análisis compartimentado, propicia que el estudiante se guíe por elementos gramaticales o aproximaciones lógicas. La ausencia de distractores resta rigor, sin embargo, los distractores en ambas columnas no aumentan el rigor intrínseco de la pregunta, si no que aportan confusión al estudiante. En las preguntas para completar oraciones elaboradas con ambigüedad, sería posible más de una respuesta lógica. Cuando en este tipo de pregunta el tema no está orientado en la raíz, las posibles respuestas lógicas pueden ser más de una. A veces la defensa de los profesores es plantear “así se lo di en clase”, lo cual no es convincente en tanto no se está evaluando memoria. El espacio debe destinarse para un elemento de alto valor científico, e idealmente que sea posible uno y nada más que uno. Las mezclas de formatos e ítems no se aconsejan, aunque su uso está bien extendido. Quizás se redujeran si los objetivos de la pregunta estuvieran bien claros para el profesor que la elabora. En la Universidad de Villa Clara se realizó una investigación en la que, a pesar de la preparación pedagógica de los profesores, se identificaron los siguientes desaciertos: instrumentos con falta de datos en el encabezamiento, predominio de preguntas de respuestas cortas o restringida, ítems con errores de redacción y diseño, uso indiscriminado de términos como “menciona” y “diga”, escasas preguntas de desarrollo que permitan evaluar la ortografía y redacción, instrumentos evaluativos sin adecuado balance de las preguntas de tipo desarrollo y test objetivos con sus respectivas variantes.5 Estos resultados tienen algunas semejanzas con los de este estudio, por ejemplo, con respecto a la elaboración de ítems y al predominio de las preguntas de tipo reproductivo. En cuanto a las claves de repuestas, las dificultades fundamentales se observaron en la determinación del punto de corte de las escalas numéricas, que significa aprobado o 3 para la escala cualitativa, aspecto que puede ser fácilmente consensuado por directivos y metodólogos. Un aspecto positivo es el uso de claves de respuestas bien explícitas en la mayoría de las preguntas de ERC, lo cual genera una contradicción en casos en que las tareas solicitadas a los estudiantes son imprecisas. Las escalas habitualmente se establecen porque los profesores necesitan operacionalizar las calificaciones en las preguntas test objetivos -creadas para calificaciones cuantitativas- para poder decidir una calificación cualitativa, equilibrada y justa para cada pregunta. Las combinaciones de calificaciones de preguntas para obtener la nota general del temario sí están sustentadas en documentos normativos, aspectos que deberían analizarse en el futuro pues son fuentes de sesgos. El hallazgo más relevante en cuanto a validez conceptual, fue la desproporción de preguntas de reproducción, por lo que se puede afirmar que algunos objetivos no son evaluados con el nivel de asimilación requerido por los contenidos, según lo que se declara en los programas. Habría que analizar cómo se cumplieron esos objetivos durante el PEA. Este desacierto es particularmente significativo en las asignaturas de quinto año de Medicina y Estomatología, así como en las estancias de la asignatura Práctica Preprofesional de Enfermería que tienen como formas organizativas docentes fundamentales la educación en el trabajo y el trabajo independiente, y como método de enseñanza genérico la solución de problemas. Son momentos del plan de estudio en los que se están integrando los sistemas de conocimientos adquiridos durante la carrera y donde se consolidan de habilidades específicas de la profesión. La reproducción del conocimiento siempre está presente en la base del aprendizaje, de hecho, se observaron programas que lo declaran en correspondencia con algún objetivo, pero es inexplicable que en exámenes finales de asignaturas cuyos objetivos tributan directamente al perfil profesional del egresado, aún predominen preguntas cuyas tareas se planteen a nivel reproductivo, varias de ellas francamente memorísticas y otras con un nivel de generalización demasiado alto, según criterio de los autores. También fue notable la escasa cantidad de preguntas donde se solicita argumentar, fundamentar o simplemente explicar y otras habilidades lógico-formales con las que los estudiantes deben operar en diversas áreas de conocimientos. En las ciencias médicas el objeto de estudio es el proceso salud/enfermedad y su atención en el ser humano, por tanto, el objeto es un sujeto a escala individual -clínica- o grupos de sujetos -salud pública- con todas sus complejidades; por ello, el PEA y la evaluación del aprendizaje deben acercarse a la realidad misma de la práctica profesional, según los niveles de sistematicidad, asimilación y complejidad declarados.11,12 En muy pocas asignaturas se observó que se declararan objetivos por pregunta en la clave y los autores infieren que no es habitual trabajar con tablas de especificaciones. Sin embargo, este es un ejercicio muy útil para evaluar contenidos con niveles de asimilación y complejidad adecuados. Por supuesto, es imprescindible haberlos tratado a similares niveles durante el PEA. La calidad en el diseño y confección de temarios de exámenes se gana en el colectivo de asignatura. El diseño y elaboración de un temario de examen final requiere dominio de los contenidos, conocimiento del programa de la asignatura, suficiente dedicación de tiempo, consenso entre los profesores que desarrollan el proceso y comprensión del alcance, recomendaciones, ventajas y desventajas de los diferentes formatos de preguntas. En el colectivo de asignatura hay que definir qué evaluar: contenidos, objetivos con niveles de asimilación, complejidad e integración definidos; cómo evaluar: cuáles técnicas ó procedimientos emplear, tipo de examen, formatos y número de preguntas; cómo calificar: elaborar claves precisas y completas y establecer las pautas y escalas de calificación. Debe lograrse la integración de los contenidos siguiendo la lógica de la profesión y el enfoque de sistema.5.13,14 Por último, y aunque no es objeto ni resultado de esta investigación, convendría mencionar que es necesario revalorizar el papel activo del estudiante en el proceso evaluativo, incluyendo sus opiniones sobre instrumentos de evaluación.15,16 Los autores no pretenden considerar esta investigación como una evaluación de la calidad del sistema de evaluación, pues solo se ha analizado uno de sus elementos: la modalidad escrita del examen final de las asignaturas. No obstante, tiene el mérito de alertar sobre sesgos que probablemente no han sido identificados de forma consciente por los colectivos de asignatura. Se concluye que la mayoría de los temarios de exámenes fueron confeccionados adecuadamente, pero se observaron desaciertos en la elaboración de preguntas y escalas de calificación. El alto porcentaje de preguntas reproductivas se constató como una debilidad, al limitar la validez conceptual.

REFERENCIAS BIBLIOGRÁFICAS

1. Ministerio de Educación Superior. Resolución No. 210/07. Reglamento para el Trabajo Docente y Metodológico en la Educación Superior [Internet]. La Habana: Gaceta Oficial de la República de Cuba; 2007 [citado 7 Jul 2014]. Disponible en: http://files.sld.cu/cimeq/files/2009/07/mes-res-210-2007.pdf

2. Ministerio de Salud Pública. Plan de estudios perfeccionado de la carrera de Estomatología. La Habana: Editorial Ciencias Médicas; 2011

3. Ministerio de Salud Pública. Resolución Ministerial 23/2013. Plan de estudios perfeccionado, carrera de Medicina. La Habana: MINSAP; 2013

4. Carrazana Lee A, Salas Perea RS, Ruiz Salvador AK. Nivel de dificultad y poder de discriminación del examen diagnóstico de la asignatura Morfofisiología Humana I. Educ Med Super [revista en Internet]. 2011 [citado 7 Jul 2014];25(1):[aprox. 15p]. Disponible en: http://scieloprueba.sld.cu/scielo.php?script=sci_arttext&pid=S0864-21412011000100010&lng=es

5. López Espinosa G J, Quintana Mujica R, Rodríguez Cruz O, Gómez López Leysa, Pérez De Armas A, Aparicio Manresa G. El profesor principal y su preparación para diseñar instrumentos de evaluación escritos. EDUMECENTRO [revista en Internet]. 2014 [citado 7 Jul 2014];6(2):[aprox. 14p]. Disponible en: http://www.revedumecentro.sld.cu/index.php/edumc/article/view/354/html

6. Díaz Rojas PA, Leyva Sánchez E. Metodología para determinar la calidad de los instrumentos. de evaluación. Educ Med Super [revista en Internet]. 2013 [citado 17 Jul 2014];27(2):[aprox. 22p]. Disponible en: http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S0864-21412013000200014&lng=es

7. Cortada de Kohan N. Manual para la construcción de test objetivos de rendimiento. Buenos Aires: Paidós; 1968

8. Moreno R, Martínez RJ, Muñiz J. Directrices para la construcción de ítems de elección múltiple. Psicothema. 2004;16(3):490-97

9. Salas Perea RS. Planeamiento de un examen. En: La evaluación en la educación superior contemporánea. La Paz: Universidad Mayor de San Andrés; 1998

10. Ayala Valenzuela R, Messing Grube H. Comprender los enunciados en un examen escrito: ¿dónde está el problema?. Educ Med Super [revista en Internet]. 2013 [citado 7 Jul 2014];27(2):[aprox. 20p]. Disponible en: http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S0864-21412013000200008&lng=es

11. Fernández Sacasas JA. Educación Médica: el objeto, el sujeto desdoblado y el contexto. Educ Med Super [revista en Internet]. 2012 [citado 12 Jul 2013];26(3):[aprox. 10p]. Disponible en: http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S0864-21412012000300001&lng=es

12. Espinosa Brito A. La clínica y la Medicina Interna. Rev Cubana Med [revista en Internet]. 2013 [citado 2 Ene 2014];52(3):[aprox. 20p]. Disponible en: http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S0034-75232013000300008&lng=es.1

13. Díaz Velis Martínez E, Ramos Ramírez R, Wong Orfila T. Reflexiones acerca de la labor metodológica de la asignatura en el currículo de Medicina. EDUMECENTRO [revista en Internet]. 2010 [citado 7 Jul 2014];2(2):[aprox. 16p]. Disponible en: http://www.revedumecentro.sld.cu/index.php/edumc/article/view/76

14. Díaz Quiñones JA. ¿Se corresponde el proceso evaluativo actual con el proceso de enseñanza aprendizaje asumido?. Gaceta Médica Espirituana [revista en Internet]. 2012 [citado 7 Jul 2014];14(1):[aprox. 3p]. Disponible en: http://bvs.sld.cu/revistas/gme/pub/sum.14.(1)/sumario.html

15. Gual A. La universidad que queremos (II). En búsqueda de una mejora contrastada. Educ Med [revista en Internet]. 2012 [citado 12 Jun 2013];15(1):[aprox. 6p]. Disponible en: http://scielo.isciii.es/pdf/edu/v15n1/editorial.pdf

16. Gil Flores J. La evaluación del aprendizaje en la universidad según la experiencia de los estudiantes. Estudios sobre Educación [revista en Internet]. 2012 [citado 12 Jun 2013];22:[aprox. 40p]. Disponible en: http://dadun.unav.edu/bitstream/10171/22636/2/ESE22-07-Gil-Flores.pdf

Recibido: 21 de octubre de 2014.

Aprobado: 04 de junio de 2015.

Margarita Rosa Romeu Escobar. Especialista de I Grado en Medicina Interna. Especialista de II Grado en Medicina General Integral. Profesora Consultante. MSc. en Educación Correo electrónico: salud5005@ucm.cfg.sld.cu