Mi SciELO

Servicios Personalizados

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista Cubana de Ciencias Informáticas

versión On-line ISSN 2227-1899

Rev cuba cienc informat vol.7 no.3 La Habana jul.-sep. 2013

ARTÍCULO ORIGINAL

Sobre Comercio electrónico en la WEB 2.0 y 3.0

About the electronic commerce on the WEB 2.0 & 3.0

Francisco A. Fernandez Nodarse

CITMATEL, 47 Y 18ª, Playa, La Habana, Cuba, ffn@citmatel.cu

RESUMEN

El modelo Web 2.0 es un fenómeno emergente que viene a situar a este usuario en el centro de cualquier modelo de negocio. El comercio electrónico en la Web 2.0, la evolución del escaparate virtual a los prosumidores, la reputación corporativa en línea, los patrones de diseño, modelos de negocios, la WEB 2.0 y su evolución hacia la WEB 3.0 y algunas consideraciones sobre la seguridad informática son analizados en este estudio. El análisis de la seguridad informática abordó sus principios básicos, políticas, arquitectura tecnológica, plan de seguridad, ataques, amenazas y estrategias de seguridad en la Web. En este estudio se aplicaron métodos de análisis y síntesis, análisis histórico y lógico y enfoque de sistema. En las conclusiones son tratados su impacto y perspectivas a partir del reconocimiento de este nuevo entorno en la Web caracterizado por la velocidad de los cambios y la necesidad de actuar en consecuencia asumiendo nuevas estrategias empresariales de comercio electrónico.

Palabras clave: Comercio electrónico, seguridad informática, Web 2.0, Web 3.0.

ABSTRACT

The Web 2.0 model is an emergent phenomenon that comes to placing the user at the center of any business model. The e-commerce in the Web 2.0, the evolution from the virtual shopfront to the prosumers, the corporate reputation online, design patterns, business models, Web 2.0 and evolution to Web 3.0 and some considerations related to computer security are analyzed in this study. The security analysis dealt the basic principles, policies, technology architecture, security plan, attacks, threats and strategies on the Web. In this study we applied methods of analysis and synthesis, historic and logical analysis and system approach. The conclusions are treated its impact and perspectives from the recognition of this new Web environment characterized by the speed of change and the need to act accordingly assuming new e-commerce business strategies.

Key words: e-commerce, computer security, Web 2.0, Web 3.0.

INTRODUCCIÓN

Los usuarios de Internet demandan transparencia, utilidad y participación. El modelo Web 2.0 (Fernandez, 2011) es un fenómeno emergente que viene a situar a este usuario en el centro de cualquier modelo de negocio, aportando el mayor valor añadido, integrando contenido y funcionalidades de forma usable y fomentando la participación de los usuarios y la escucha activa de la voz del cliente, lo que ha hecho que el modelo de tienda electrónica entendida como vitrina virtual o autoservicio en línea esté cuestionando. En este estudio se aborda el comercio electrónico en la Web 2.0, la evolución del escaparate virtual a los prosumidores, la reputación corporativa en línea, los patrones de diseño, modelos de negocios y algunas consideraciones sobre la seguridad informática características de este nuevo contexto.

MATERIALES Y MÉTODOS

En este estudio se aplicaron métodos de análisis y síntesis, análisis histórico y lógico y enfoque de sistema. El método de análisis y síntesis comprendió el estudio individual de las partes y de su unión racional de forma simultánea e integral para sistematizar las ideas relacionadas con el comercio electrónico en la Web. El método histórico lógico se empleó para conocer la evolución y tendencias actuales del comercio electrónico en la Web y determinar sus regularidades esenciales. El enfoque sistémico e inductivo deductivo partió del análisis de los precedentes teóricos y prácticos para luego fundamentar la caracterización del comercio electrónico en la Web 2.0, mediante la determinación de sus componentes y las relaciones que condicionan su estructura y dinámica. El análisis documental empleó búsquedas bibliográficas a través de los motores generales y especializados de Internet.

RESULTADOS Y DISCUSIÓN

El comercio electrónico en la Web 2.0

El usuario de Internet prefiere los buscadores verticales en los que se pueden comparar directamente las ofertas de un gran número de ofertantes. Incluso en los propios sitios Web de una sola marca, se ofrece la posibilidad de comparar precios cuando existe flexibilidad en las fechas. Ganarse la fidelidad de un usuario que valora la transparencia y el valor añadido de contar con más opciones para tomar una decisión de compra puede llegar a ser más importante que la perspectiva de perseguir la venta cerrando las opciones disponibles. Se trata de aportar valor añadido filtrando el conocimiento, agregando contenidos y funcionalidades que se recombinan para convertir la experiencia del usuario en algo positivo: que el visitante siempre encuentre algo útil que le incite a regresar. Aun sabiendo que parte de esas opiniones pueden estar sesgadas, los usuarios tienden a atribuir una mayor credibilidad al establecimiento en el que, dentro de una tónica positiva en las opiniones de los usuarios, puede encontrarse también alguna crítica negativa. Los propios consumidores se convierten en productores de la información y por tanto en prescriptores (Fry, 2012). Desde inicios de esta década, CITMATEL viene desarrollando plataformas y prestando servicios de comercio electrónico (Fernandez, 2003) en Internet caracterizado por la mejora continua y prestando particular atención a la seguridad informática.

Del escaparate virtual a los prosumidores

En el comercio detallista, Amazon integra funcionalidades propias de la Web 2.0: opiniones de otros compradores, oferta cruzada, comparativas, críticas literarias, musicales o cinematográficas. La trayectoria de los comercios virtuales siguen unas pautas de evolución (Fernandez, 2011) similares a los comercios reales, partiendo de los primeros modelos Web:

- Oferta o escaparate virtual: en el mundo real, hablaríamos del nivel de atención que podemos encontrar en un autoservicio. Fue el modelo de comercio electrónico de primera generación.

- Oferta personalizada: la tienda conoce el perfil de comprador y hace recomendaciones de producto acorde con él. Para los clientes de Amazon, su página de inicio siempre presentará una oferta personalizada de acuerdo con el perfil de comprador.

- Diálogo con el consumidor: además de conocer sus gustos, mantiene una actitud de escucha activa para detectar en qué podría mejorar su oferta. Lo hemos visto en Internet en las páginas en que podemos, por ejemplo, valorar la utilidad de la información presentada.

- Pasando al modelo Web 2.0 (Wipe, 2012) es necesario compartir información entre consumidores fomentando que los compradores de un producto puedan compartir experiencias en los foros de usuarios y en las múltiples redes sociales tales como Facebook, MySpace, Twitter, LinkedIn, así como integrar a los consumidores en la propia generación de contenido Web como prescriptores o incluso participantes activos (prosumidores)

Reputación corporativa en línea

Al integrar ciertas funcionalidades Web 2.0 (Fumero, 2007) como son las opiniones y foros de usuarios, los gestores de sitios Web de la primera generación pueden percibirlo como una amenaza. En el mundo virtual, gestionar adecuadamente la voz del cliente no sólo en los medios controlados por la empresa (su propio sitio Web y los foros de usuarios que puede moderar) sino en aquellos medios que no puede controlar (redes sociales puede convertirse en parte fundamental de su reputación corporativa en línea. Conseguir líderes de opinión que sepan navegar adecuadamente en las páginas de blogs, Facebook, Twitter, MySpace, LinkedIn, que mantengan una escucha activa y que actúen como interlocutores de la empresa es un importante objetivo a corto plazo. Los usuarios confían más en quien demuestra una actitud transparente. Colateralmente, integrar la voz de los clientes en los contenidos del sitio Web impactará positivamente sobre el posicionamiento en buscadores de nuestras páginas. Las opiniones suponen siempre contenido fresco, en constante renovación, e integra exactamente las palabras que los usuarios potenciales emplean para referirse a un producto o servicio determinado.

El modelo Web 2.0 (Gram, 2010) sitúa al usuario en el centro de cualquier modelo de negocio. Más allá de concretarse en la integración de una serie de funcionalidades el sitio Web, en beta permanente, debe incluir la comparación de características y precios de ofertas similares en tiempo real, la oferta de productos relacionados y la venta cruzada, la integración de funcionalidades y contenidos de terceras partes, el fomento de la integración de contenidos propios en terceras partes vía XML, RSS, API y la incorporación de opiniones, foros de usuarios, y colaboración de los prosumidores en la generación de contenidos. El modelo Web 2.0 requiere que la empresa comprenda que su presencia en línea se produce no sólo en su propio sitio Web, sino también en los buscadores, en las redes sociales, en los blogs y chats, en los foros y que cualquier actitud frente a sus clientes va a tener impacto. El esfuerzo para gestionar la comunicación con sus usuarios potenciales no sólo pasa por una comunicación eficaz y por mantener una escucha activa, sino que se tendrá que trasladar a todo el modelo de negocio aspirando a ofrecer al usuario la combinación de productos y servicios que le aporte la máxima utilidad y gestionando cualquier reclamación como una oportunidad de fidelización y de generación de reputación. Se abre una oportunidad para que los modelos de comercio electrónico que antes adopten esta actitud 2.0 marquen una ventaja competitiva respecto a la tienda autoservicio. A partir de los perfiles se desarrollan novedosas estrategias de marketing y soluciones que impulsan estas plataformas hacia nuevas fronteras.

Para expandir su portafolio y mejorar sus ventas por comercio electrónico se ha recomendado el uso de los siguientes elementos, destacándose la inclusión de las redes sociales como canal de marketing, especialmente Twitter y Facebook, lo que implica la construcción de una estrategia de promoción innovadora:

- Usar un recolector de marcas de redes sociales en su blog para vincular su producto y facilitar su conexión a las redes sociales como Twitter o Facebook. AddThis.com, ShareThis.com, y AddToAndy.com son opciones usadas y de fácil instalación sobre múltiples plataformas.

- Contabilizar y evaluar las estadísticas de su compañía. Uno de los evaluadores más importantes es Google Social Search, otro es SocialMention.com.

- Agregar un botón de Retweet al contenido del sitio Web, "que indica la repetición de un tweet, el mensaje ha pasado de un usuario a otro, logrando una mayor audiencia en Twitter. Esta acción beneficia tanto al que generó la información, como al que le hizo el "retweet". Es una técnica muy recomendada para poder ver el alcance logrado dentro de Twitter.

- Redes de LinkedIn con clientes y contactos de la industria como canal de redes sociales para tu negocio dependiendo del nicho de e-comercio en el que se esté concentrado. Cuando se tiene un perfil en LindedIn este le permite conectarse con su compañía, socios y otros líderes de su sector. Se puede también colocar su sitio de comercio electrónico en su directorio de negocios ayudándole a encontrar otra mención de su marca y permitirle al usuario conocer más de su compañía. Ayuda también a exponer recomendaciones que otras personas tienen de su compañía.

- Tomar ventaja de aplicaciones sociales para telefonía inteligente. iPhone ofrece variadas aplicaciones a sus usuarios, mientras Blackberry y Android han comenzado a desarrollar lo que un teléfono inteligente necesita.

- Utilizar una página de fan de Facebook para su tienda de comercio electrónico, requiriéndose de flexibilidad y empatía.

- Emplear el video como parte de su estrategia social de medios alojándolos en su página o incluso en otras redes sociales para así multiplicar sus conexiones e incluso apuntar a determinados blancos. Debe contar con dispositivos, incluyendo teléfonos móviles, que permita videos de alta calidad y la forma de transmitirlo en forma inmediata, así como ofrecer videos tutoriales para describir sus productos y servicios.

- Usar el mismo nombre de usuario, siempre que sea posible, vinculado a su sitio de comercio electrónico - URL y en las redes sociales, lo que facilitará detectar el uso de su marca.

- Usar herramientas para ahorrar tiempo en actualizaciones en las redes sociales.

- Sus esfuerzos de adaptación a los medios y redes sociales deben ser considerados como parte de los esfuerzos de los sistemas de optimización de búsqueda (Search Engine Optimization - SEO u Optimización para los Motores de Búsqueda). Esto está relacionado con el posicionamiento natural u orgánico de un sitio, es decir, aquella que no es de pago y que aplicando ciertas técnicas y estrategias puede posicionar una página Web en las páginas de resultados de un buscador. Una manera para incrementar las conexiones es a través de la generación de blogs en torno a la tienda de comercio electrónico o las actividades a los que están destinados sus productos y servicios.

Patrones del diseño y modelos del negocio para la Web 2.0

Los patrones de diseño y modelos del negocio para la Web 2.0 (O'Reilly, 2007) son empleados también para comercio electrónico

La Web como plataforma

El concepto de Web 2.0 (Fundación Orange, 2010) se visualiza como un sistema de principios y prácticas, enumerados preliminarmente en octubre de 2004, uno de los cuales era 'la Web como plataforma'. Vamos a profundizar en algunas características esenciales:

- Google es considerado el abanderado de la Web 2.0. Netscape ideó el concepto de 'la Web como plataforma' en términos del viejo paradigma del software: el navegador Web, una aplicación de escritorio y su estrategia era utilizar su dominio en el mercado de los navegadores para crear un mercado de productos de servidor de gama alta. Al final, los navegadores Web y los servidores Web resultaron ser commodities, y el valor se desplazó hacia los servicios ofrecidos sobre la plataforma Web. Google comenzó su vida como una aplicación Web nativa, nunca vendida o empaquetada, sino entregada a sus clientes y pagada por su uso como un servicio. No hay programación de las actualizaciones de las versiones del software, sencillamente mejora continua. A diferencia de Netscape, Google no es solo una colección de herramientas software, es una base de datos especializada que requiere ser gestionada. El licenciamiento del software y el control sobre las APIs es irrelevante porque el software no necesita ser distribuido sino ejecutado, y el valor del software es proporcional a la escala y al dinamismo de los datos que ayuda a gestionar. El servicio de Google es ofrecido por una colección masiva de servidores de Internet y es experimentado por el usuario a través del navegador. Google tiene lugar en el espacio que se encuentra entre el navegador y el motor de búsqueda y el servidor de contenido destino, como un habilitador o intermediario entre el usuario y su experiencia en línea.

- Como Google, DoubleClick ofrece software como un servicio, tiene una competencia básica de gestión de datos, y era un pionero en servicios Web. DoubleClick se limitó por su modelo de negocio, apoyó en los años 90 el concepto de la Web orientada a la publicación, no a la participación. Las ofertas de DoubleClick requieren un contrato formal de venta, limitando su mercado a unos pocos miles de sitios Web relativamente grandes. La Web 2.0 promueve el uso del autoservicio del cliente y de la gestión de datos algorítmica para llegar a toda la Web. En este sentido el éxito de Google fue también resultado de la comprensión de lo que Chris Anderson cita como 'la larga cola' (' the long tail '), el poder colectivo de los sitios Web pequeños que conforman la gran mayoría del contenido de la Web.

- La plataforma supera a la aplicación en todo momento. La competencia es ahora entre plataformas, y la pregunta es cúal plataforma, arquitectura y modelo de negocio se ajustan más. Windows era una solución brillante con una aproximación monolítica, controlada por un proveedor. Los sistemas orientados hacia las comunicaciones se caracterizan por sus requerimientos de interoperabilidad.

- BitTorrent, como otros en el movimiento del P2P, adopta el enfoque de la descentralización del Internet. Cada cliente es también un servidor, los archivos se subdividen en fragmentos que se sirven desde múltiples localizaciones, aprovechando de forma transparente la red de usuarios para proporcionar tanto ancho de banda como datos a otros usuarios. Cuanto más popular es el archivo, más rápidamente se descarga, dado que más usuarios proporcionan ancho de banda y fragmentos del archivo completo. BitTorrent demuestra un principio dominante de la Web 2.0: el servicio mejora automáticamente cuanto más usuarios. Mientras que Akamai agrega servidores para mejorar el servicio, cada consumidor de BitTorrent aporta sus recursos al grupo. Hay una arquitectura implícita de participación', una cooperación en la que el servicio actúa como intermediario inteligente, conectando los extremos y aprovechando las posibilidades que ofrecen los usuarios.

Aprovechando la inteligencia colectiva

Las contribuciones del usuario son claves para el dominio del mercado en la Web 2.0. Explotar la inteligencia colectiva contribuye al éxito (Ribes, 2007). Los hipervínculos constituyen los cimientos de la Web, la red de conexiones crece orgánicamente como resultado de la actividad colectiva de los usuarios de la Web. Aunque Yahoo! se está orientando a crear muchos tipos de contenido, su papel como portal del trabajo colectivo de los usuarios de la red es la base de su valor. Fue PageRank la innovación de Google que le convirtió en líder del mercado de la búsqueda con un método que usa la estructura de enlaces de la Web para mejorar los resultados en vez de usar sólo las características de los documentos. El producto de eBay es la actividad colectiva de todos sus usuarios, su ventaja competitiva proviene de la masa crítica de compradores y de vendedores, crece orgánicamente en respuesta a la actividad del usuario y su papel es habilitar un contexto donde tiene lugar. Amazon se centra en la gestión del usuario y utiliza la actividad del usuario para mejorar los resultados de búsqueda mediante un cómputo en tiempo real basado en la venta y otros factores que llaman 'flujo' inducido alrededor de los productos.

Los elementos innovadores contribuyen al éxito. Wikipedia, es un cambio profundo en la dinámica de la creación de contenidos. Sitios como Flickr han promovido un concepto conocido como 'folksonomy', un estilo de clasificación colaborativa de sitios usando palabras claves libremente elegidas, a menudo denominadas etiquetas (tags). El marcado con etiquetas permite asociaciones múltiples en lugar de categorías rígidas. Los productos de filtrado cooperativo agregan las decisiones individuales de los usuarios del correo electrónico sobre qué es spam, funcionando mejor que los sistemas basados en el análisis de los mensajes. Ejemplos de éxito en Internet no anuncian sus productos, su adopción es impulsada por el 'marketing viral'. Buena parte de la infraestructura de la Web (incluyendo Linux, Apache, MySQL, Perl, PHP, o el código de Python incluído en la mayoría de los servidores Web) confía en los métodos de producción entre pares ('peer-production') del software abierto, un proceso orgánico de adopción del software que se basa casi enteramente en el marketing viral. En cuanto a la arquitectura de la participación, solo un porcentaje pequeño de usuarios añade valor a su aplicación mediante el uso de medios explícitos, por lo que las compañías Web 2.0 usan métodos incluyentes para agregar datos del usuario y generan valor como efecto colateral del uso ordinario de la aplicación. La arquitectura de Internet, de la WWW y de los proyectos de software abierto es tal que los usuarios que persiguen sus propios intereses generan valor colectivo como subproducto automático. Amazon demuestra que es posible superponer dicha arquitectura a un sistema que no parecería poseerla en sí.

Otra de las características de la Web 2.0 es el blogging. La organización cronológica de un blog parece trivial, pero conduce a una cadena de reparto, de publicidad y de valor completamente distinta. RSS permite que alguien no sólo enlace con una página, sino se suscriba con notificaciones cada vez que la página cambia. A esto se le ha llamado 'la Web incremental' o 'Web viva'. Un enlace a un Weblog señala a una página viva que cambia, con los enlaces permanentes ('permalinks') para cualquier entrada individual y con notificación de cambio. La combinación de RSS y de permalinks añade características del Network News Protocol del servicio de noticias ('news') de Usenet. Dado que los motores de búsqueda hacen uso de la estructura de enlaces para predecir las páginas útiles y dado que la comunidad de los blogs se autoreferencia tanto, los bloggers, como enlazadores prolíficos y puntuales, juegan un papel importante en la configuración de los resultados del motor de búsqueda.

Los datos, componente original

La gestión de bases de datos es una competencia básica de las compañías Web 2.0. Hay una tendencia a que toda aplicación significativa de Internet haya sido desplazada por una base de datos especializada. Por ejemplo, la base de datos de enlaces de Google, el directorio de Yahoo! (y su base de datos de enlaces), la base de datos de productos de Amazon, la base de datos de productos y vendedores de eBay, las bases de datos de mapas de MapQuest, la base de datos distribuida de canciones de Napster. En algunas ocasiones se hace referencia a esas aplicaciones como 'infoware' en lugar de meramente software. Los datos de estas aplicaciones son un único componente original en sistemas cuya infraestructura software es en gran medida software abierto o software que de algún otro modo se ha convertido en una commodity. El Google Maps es una muestra de la competición entre los proveedores de aplicaciones y sus suministradores de datos. El modelo de programación ligero de Google ha conducido a la creación de numerosos servicios de valor añadido en forma de lo que se conocen como mashups (aplicaciones Web híbridas) que enlazan Google Maps con otras fuentes de datos accesibles en Internet. La competencia entre los suministradores de los datos y los proveedores de aplicaciones se centra en poseer ciertas clases de datos clave y se localizará en ciertas clases de datos que se convertirán en los componentes básicos de las aplicaciones de la Web 2.0. Cuando crear los datos supone un coste significativo, existe la posibilidad de utilizar una única fuente. El objetivo es alcanzar una masa crítica mediante la agregación de usuarios, y convertir esa agregación de datos en un sistema de servicios. Los estándares y las soluciones en estas áreas, convirtiendo ciertas clases de datos en subsistemas fiables del 'sistema operativo de Internet', posibilitarán la siguiente generación de aplicaciones. Otro aspecto a tener en cuenta es la preocupación del usuario por la privacidad y los derechos con respecto a sus propios datos. A medida que se entienda que el control sobre datos puede ser una ventaja competitiva habrá mayores intentos de control.

El fin del ciclo de las actualizaciones de versiones del software

Una de las características de la era Internet es la entrega del software como un servicio, conduciendo a cambios sustanciales en el modelo de negocio. Las operaciones se convierten en una competencia clave. La transformación del software a servicio es sustancial. Google rastrea continuamente la Web y actualiza sus índices, filtra los enlaces de spam y otros intentos de influir en sus resultados, responde continúa y dinámicamente a las masivas peticiones asíncronas de usuarios, haciéndolas corresponder simultáneamente con anuncios adecuados según el contexto. Las técnicas de administración del sistema, la tecnología de red y las técnicas de balanceo de carga de Google se valoran más que sus algoritmos de búsqueda y la automatización de estos procesos. Los lenguajes dinámicos o de scripting como Perl, Python, PHP, y ahora Ruby son la herramienta elegida por los administradores de sistemas y redes y por los desarrolladores de aplicaciones que implementan sistemas dinámicos con cambios constantes. Los usuarios deben ser co-desarrolladores, considerando las prácticas de desarrollo del software abierto, liberado o no bajo una licencia abierta. La máxima del software abierto 'libera pronto y libera frecuentemente' ha derivado hacia 'la versión beta perpetua', que se desarrolla continuamente, convirtiendo en otra competencia clave la supervisión en tiempo real del comportamiento del usuario para detectar qué funcionalidades nuevas utilizan y cómo.

Modelos de programación ligeros

Los servicios Web son habituales, las grandes compañías lanzaron una compleja gama de servicios Web diseñada para crear entornos de programación altamente fiables para aplicaciones distribuidas. RSS es quizás el servicio Web más ampliamente desplegado dado su simplicidad, mientras que los complejos servicios Web corporativos aún deben lograrlo. Ello muestra una tendencia hacia:

- Apoyar los modelos de programación ligeros que permiten sistemas débilmente acoplados. La compleja gama de servicios Web apoyados por las corporaciones se diseña para un fuerte acoplamiento entre las partes. No obstante, muchas aplicaciones son débilmente acopladas e incluso frágiles.

- Pensar en sindicación, no en coordinación. Los servicios Web simples, como RSS y aquellos basados en REST, tratan de la sindicación de datos hacia el exterior, sin controlar lo que sucede al llegar al otro extremo de la conexión.

- Diseñar para ser 'reutilizados' y 'remezclados'. La Web original, RSS, y AJAX tienen barreras extremadamente bajas para su reutilización.

- Innovación en el ensamblado. Cuando los componentes commodity son abundantes, puede crearse valor ensamblándolos de forma novedosa o eficaz. Es posible superar a la competencia con mejor aprovechamiento e integración de los servicios proporcionados por otros.

- El software no limitado a un solo dispositivo. El software útil escrito sin circunscribirse a un solo dispositivo proporciona altos márgenes durante mucho tiempo. La Web 2.0 no se limita a la plataforma PC. El desarrollo de la Web como plataforma se extiende a aplicaciones compuestas de servicios proporcionados por múltiples ordenadores. De un modo transparente la aplicación puede ir de un dispositivo a otro incluyendo los portátiles.

- Experiencias enriquecedoras del usuario. Con el navegador Viola de Pei Wei (1992) la Web era utilizada para descargar 'applets' y otros contenidos activos dentro del navegador Web. La introducción de Java (1995) estuvo enmarcada en la descarga de tales applets. Con Javascript y DHTML se introdujeron formas ligeras de proporcionar programabilidad en el lado cliente y experiencias más enriquecedoras para el usuario. Macromedia acuñó el término 'Rich Internet Applications' (también adoptado por Laszlo Systems) para destacar las capacidades del Flash para proporcionar contenido multimedia y experiencias de aplicación del estilo GUI.

El potencial de la Web de proporcionar una gama completa de aplicaciones no tuvo un éxito masivo hasta que Google introdujo Gmail, seguida rápidamente por Google Maps, aplicaciones Web con interfaces de usuario ricas y con interactividad equivalente a la del PC. El conjunto de tecnologías usadas por Google ha sido identificado como AJAX, que incorpora una presentación basada en estándares usando XHTML y CSS, visualización e interacción dinámicas usando el modelo Document Object Model, intercambio y manipulación de datos usando XML y XSLT, recuperación de datos asíncrona usando XMLHttpRequest y JavaScript aglutinándolo todo. AJAX es también un componente clave de aplicaciones como Flickr (Yahoo!), y Gmail y Orkut de Google.

Los cambios de plataforma han generado también oportunidades para cambiar el liderazgo de las principales aplicaciones de la plataforma anterior. Gmail ha proporcionado ya algunas innovaciones en el correo electrónico, combinando las fortalezas de la Web con las fortalezas de las interfaces de usuario que se aproximan a las interfaces del PC en usabilidad. Un procesador de texto como Writely soportaría la edición al estilo colaborativo de las wikis, no sólo documentos autónomos, sino también los formatos de los procesadores de textos para PC. Salesforce.com demostró cómo la Web se puede utilizar para ofrecer software como servicio, en aplicaciones de escala empresarial como el CRM. La oportunidad competitiva está en emplear el potencial de la Web 2.0 creando aplicaciones que aprendan de sus usuarios, usando una arquitectura de participación para construir una ventaja derivada no sólo de la interfaz software, sino de la riqueza de los datos compartidos. En Technology Review del MIT, Wade Roush refiere término Web 2.0 como nuevos mecanismos de relación y comunicación entre las personas utilizando las tecnologías de redes sociales (con servicios como MySpace,YouTube, Digg o Wikipedia), la utilización de estándares Web para la creación de servicios distribuidos en Internet (léase "mashups") y la mejora en los interfaces de las páginas Web hasta llegar a imitar las aplicaciones clásicas que se ejecutan en un ordenador.

WEB 2.0 Y EVOLUCIÓN HACIA LA 3.0

En 1994 se gesta la Web 1.0 con un formato estático y unidireccional. Desde el 2003 se ha ido desarrollando la llamada Web 2.0 colaborativa y de protocolo bidireccional, donde los usuarios se convierten en contribuidores, publican las informaciones y realizan cambios en los datos. La Web 2.0 se caracteriza por la interacción y el auge de las redes sociales, la Web 3.0 deriva en una Web evolucionada con interfase 3D y un amplio empleo de la Inteligencia Artificial. Los cambios tecnológicos de los soportes de almacenamiento de datos y de los dispositivos móviles van a permitir la integración de la Web semántica, la conexión total y permanente, fomentando el trabajo.

El término Web 3.0 apareció en 2006 en un artículo de Jeffrey Zeldman, es un neologismo que se utiliza para describir la evolución del uso y la interacción en la red a través de diferentes caminos y con frecuencia es utilizado por el mercado para promocionar mejoras respecto a la Web 2.0. Ello incluye, la transformación de la red en una base de datos, un movimiento hacia contenidos accesibles por múltiples aplicaciones non-browser, el auge de las tecnologías de inteligencia artificial, la Web semántica, la Web Geoespacial, o la Web 3D.

Las tecnologías de la Web 3.0, como programas inteligentes que utilizan datos semánticos, se han implementado y usado en pequeña escala para conseguir una manipulación de datos más eficiente. Dado que los formatos en que se publica la información en Internet son dispares, el primer paso hacia la "Web 3.0" es la "Data Web" que permite un nuevo nivel de integración de datos y aplicación inter operable. El escenario de la "Web Semántica" ampliará su alcance en tanto que los datos estructurados e incluso, lo que tradicionalmente se ha denominado contenido semi-estructurado (como páginas Web, documentos, etc.) estén disponibles en los formatos semánticos. Se debate sobre si la fuerza conductora tras Web 3.0 serán los sistemas inteligentes, o si la inteligencia vendrá de sistemas de inteligencia humana, a través de servicios colaborativos que extraen el sentido y el orden de la red existente y cómo el usuario interactúa con ella. Otro camino para la Web 3.0 es la visión 3D, que podría abrir nuevas formas de conectar y colaborar utilizando espacios tridimensionales. Otro término relacionado es la Web centrada en multimedia o "mediocéntrica" que se refiere a una Web que ofrezca, no solamente búsquedas basadas en metadatos, sino por similitudes en la multimedia con sólo mostrar al buscador el medio de referencia.

La Web 3.0 podría ser la realización y extensión del concepto de la "Web semántica", y se caracteriza por el uso de estándares de metadatos como Dublin Core y en su forma más elaborada de ontologías y no de folcsonomías. El uso de ontologías como mecanismo para estructurar la información en los programas de blogs se aprecia incipientemente en algunos wikis. Existe una diferencia fundamental entre Web 2.0 y semántica y es el tipo de participante y las herramientas que se utilizan. La Web 2.0 tiene como principal protagonista al usuario humano que escribe artículos en su blog o colabora en un wiki y además de publicar en HTML emite parte de sus aportaciones en diversos formatos para compartir esta información como son los RSS, ATOM, etc. mediante la utilización de lenguajes estándares como el XML. La Web semántica está orientada hacia el protagonismo de procesadores de información que entiendan de lógica descriptiva en diversos lenguajes más elaborados de metadatos como SPARQL, POWDE u OWL (Ontology Web Language) que permiten describir los contenidos y la información presente en la Web, concebida para que las máquinas procesen de una forma eficiente la información publicada en la Web con programas que puedan razonar, basados en descripciones lógicas y agentes inteligentes. Dichas aplicaciones, pueden llevar a cabo razonamientos lógicos utilizando reglas que expresan relaciones lógicas entre conceptos y datos en la red. Este tipo de evolución se apoya en tecnologías de llamadas asíncronas para recibir e incluir los datos dentro del visor de forma independiente.

La clave de la Web Semántica está en generar búsquedas más precisas e "inteligentes". Algunos para implementar la Web Semántica, en lugar de utilizar estándares y reformateos Webs, están construyendo microformatos, nuevos agentes para entender las páginas Web que ya tienen información semántica. Los contenidos publicados en páginas Web, salvo excepciones, son difícilmente entendibles por los ordenadores, se trata de añadir información adicional con una estructura que los ordenadores mediante técnicas de inteligencia artificial capaces de emular y mejorar la obtención de conocimiento, es decir, dotar de significado a las páginas Web. La empresa RadarNetworks busca explotar el contenido suministrado por los usuarios en las redes sociales, y el proyecto KnowItAll, de la Universidad de Washington y financiado por Google, busca obtener y agregar información de usuarios de productos. Frente a la Web semántica tradicional, conocida en círculos especializados como RDFa, aparecen los microformatos. El modelo RDFa resulta complejo por el componente matemático de su estructura, lo que hace necesario sistemas automáticos para su implantación, y utiliza un lenguaje de escritura de páginas Web que se espera evolucione hacia él y que proporciona un marco más general que los microformatos.

La aparición de herramientas automáticas que simplificaban la creación de páginas Web permitió poder dedicar un mayor número de recursos a las labores de diseño. El siguiente paso sería alcanzar un grado de homogeneidad en la forma en la que se utilizan los servicios en línea para que los usuarios no tuvieran que aprender a utilizar cada nuevo servicio disponible.

El impacto de la Web 3.0 dependerá de una combinación efectiva entre la inclusión de contenido semántico en las páginas Web y el uso de inteligencia artificial. El uso extensivo del "tagging" como forma de clasificación de la información ya se hace en la Web 2.0. Como nuevos tipos de servicios en desarrollo están el Mechanical Turk de Amazon donde aquellas partes de un servicio que requieran de intervención humana puedan ser redirigidas a un grupo de participantes voluntarios y el experimento Google Image Labeler donde participantes en un juego clasifican con etiquetas relevantes un conjunto de imágenes. Lo descrito va a requerir de tiempo antes de convertirse en servicios concretos, por lo que el próximo avance pudiera estar dado por la movilidad, nuevos servicios para la Web móvil.

La Web 3D es vista también como una extensión de los mundos virtuales, similar a la Second Life o There.com. Google y Microsoft trabajan en este tipo de proyectos. Los "networked objects" que crean la Internet of Things representan la penetración de lo virtual en los espacios físicos, pero existe otra posibilidad de la llamada Web 3.0 como resultado de la combinación de tres elementos: las piezas de la Web 2.0, espacios de trabajo colaborativos 3D y herramientas de diseño de mundos sintéticos o virtuales basados en juegos multijugadores en línea o MMORPGs.

ALGUNAS CONSIDERACIONES SOBRE LA SEGURIDAD INFORMÁTICA

La seguridad depende de la tecnología, del hombre y de la organización. Hoy se reconoce que en la ocurrencia de hechos y sucesos que afectan a la seguridad en una organización, los fallos de la tecnología tienen una decreciente contribución, los fallos humanos individuales tienen una contribución aún significativa y fallos de la organización tienen una alta contribución. Las tareas que desempeña, el funcionamiento y las herramientas que emplea son factores esenciales en el uso de la tecnología. Los estilos de dirección, los objetivos, los recursos, el aprendizaje organizacional, el entrenamiento, la estructura de la organización, la comunicación vertical y horizontal, la identificación y resolución de problemas y las influencias externas caracterizan la organización. Los conocimientos, destrezas, aptitudes, actitudes y motivaciones inciden en la actuación de las personas. Los aspectos tratados en este epígrafe son abordados de una forma u otra por las legislaciones y reglamentaciones que sobre seguridad informática se aplican internacionalmente. (Rambia, 2011) (Ministerio de la Presidencia, 2010) (MIC, 2007)

La cultura de seguridad dentro de una organización está determinada por el conjunto de creencias, normas, actitudes, funciones y métodos sociales y técnicos que procuran reducir al mínimo la exposición de los empleados, directivos, clientes y población en general a condiciones que se estiman peligrosas o que provocan daño.

La seguridad en la organización debe ser vista como un problema de todos, es un proceso constante de mejora que debe evolucionar y adaptarse, requiere de una visión, valores compartidos y un compromiso de todos. Emplea aproximaciones metodológicas para aprovechar experiencias. No todo es riesgo; existen soluciones plenamente aplicables. El usuario percibe antes la confianza, no hay que olvidar que el usuario valora lo que parece y no lo que es. En las decisiones en materia de seguridad deben tenerse en cuenta los siguientes principios básicos:

- Seguridad integral.

- Gestión de riesgos.

- Prevención, reacción y recuperación.

- Líneas de defensa.

- Reevaluación periódica.

- Función diferenciada.

Las políticas de seguridad se establecen en base a los principios básicos anteriores y se desarrollan aplicando los siguientes requisitos mínimos:

- Organización e implantación del proceso de seguridad.

- Análisis y gestión de los riesgos.

- Gestión de personal.

- Profesionalidad.

- Autorización y control de los accesos.

- Protección de las instalaciones.

- Adquisición de productos de seguridad.

- Seguridad por defecto.

- Integridad y actualización del sistema.

- Protección de la información almacenada y en tránsito.

- Prevención ante otros sistemas de información interconectados.

- Registro de actividad.

- Incidentes de seguridad.

- Continuidad de la actividad.

- Mejora continua del proceso de seguridad.

La seguridad es un aspecto crítico del comercio electrónico y la mejora en estos procesos podría expandir la confianza de los clientes. Se estima que a medida que la distancia entre procesos de negocio y tecnologías disminuye, el impacto de riesgos de seguridad aumenta.

En estos sistemas de información se diferencia el responsable de la información, el responsable del servicio y el responsable de la seguridad. El responsable de la información determina los requisitos de la información tratada; el responsable del servicio determina los requisitos de los servicios prestados; y el responsable de seguridad determina las decisiones para satisfacer los requisitos de seguridad de la información y de los servicios. La responsabilidad de la seguridad de los sistemas de información esta diferenciada de la responsabilidad sobre la prestación de los servicios.

La política de seguridad de la organización debe detallar las atribuciones de cada responsable y los mecanismos de coordinación y resolución de conflictos.

Para la seguridad informática de estos servicios deben integralmente ser tenidos en cuenta los componentes físico, lógico, humano, comunicaciones, costos y políticas de seguridad.

La arquitectura tecnológica de seguridad del servicio de comercio electrónico debe garantizar la autenticación, control de acceso, confidencialidad, integridad, no repudio, disponibilidad y privacidad. Su diseño e implementación abarca el empleo generalmente combinado de varios recursos tecnológicos, organizativos y legales que deberán ser evaluados, documentados y aplicados en correspondencias con las particularidades del servicio. A continuación se muestra algunos de los recursos que deberán tenerse en cuenta:

- Autenticación: Contraseñas, contraseñas de un solo uso, tokens, firma electrónica, dispositivos biométricos y tarjetas inteligentes (smart cards).

- Control de acceso: Filtrado de direcciones IP, SOCKS, pasarelas, DMZ (zona desmilitarizada o red perimetral), ACL´s (Lista de Control de Accesos), cortafuegos-IDS (sistema de detección de intrusos), redes privadas virtuales (VPN), y certificados de uso.

- Confidencialidad: cifrado simétrico y asimétrico, protocolos seguros, etc.

- Integridad: Message Authentication Code (MAC), hashing, firma electrónica, gestión de cambios, protección antivirus, etc.

- No repudio: Firma electrónica, thustred third parties, certificados, huellas de autoría, registro de eventos.

- Disponibilidad: Tolerancia ante fallos, redundancia, respaldo/ recuperación y gestión de la capacidad.

- Privacidad: Políticas de privacidad, leyes, resoluciones, obligaciones contractuales y laborales y formación profesional.

A modo de ejemplo en la figura 1 se muestra una arquitectura de 3 niveles que ha sido empleada para estos fines.

Las áreas de seguridad del entorno del servicio de comercio electrónico a ser evaluadas abarcan: la privacidad, autenticación, gestión de usuarios, disponibilidad, escalabilidad, rendimiento, seguridad multicanal, confidencialidad, validez legal, seguridad perimétrica, integridad, seguridad de las aplicaciones, continuidad del negocio, seguridad física, auditorias, gestión de sistemas, gestión de incidencias y monitorización. Algunas áreas de seguridad del entorno de comercio electrónico se muestran en la figura 2.

Un ejemplo de topología de servicios de comercio electrónico se muestra en la figura 3.

A fin de poder determinar el impacto que tendría sobre la organización un incidente que afectara a la seguridad de la información o de los sistemas, debe tenerse en cuenta las siguientes dimensiones de la seguridad: disponibilidad, autenticidad, integridad, confidencialidad y trazabilidad.

Para alcanzar un nivel razonable y sostenible de seguridad se requiere de un proceso continuo, iterativo e incremental de mejora que garantice su evolución y adaptación, identifique y reduzca sus vulnerabilidades y riesgos, minimice las afectaciones y de respuesta a las contingencias garantizando la recuperación en breve plazo.

El conjunto de técnicas tendientes a aplicar para garantizar una evaluación integral de las debilidades del sistema (Penetration testing) abarcan:

- Internas: protocolos internos, autentificación de usuarios, aplicaciones propietarias, verificación de permisos, ataques DoS, seguridad física en las estaciones de trabajo, etc.

- Externas: fuerzas de las claves de acceso, captura del tráfico de red, detección de protocolos, scanning de puertos, vulnerabilidades existentes, ataques de DoS, test de servidores, etc.

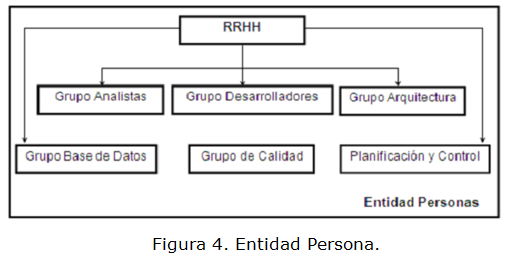

Como parte de la implementación del Plan de Seguridad se establecen las normas de seguridad de la información y las normas de seguridad de la infraestructura tecnológica. Ver figura 4. Implementación del Plan de Seguridad.

Las normas de seguridad de la información deben dejar claramente establecidas:

- la responsabilidad sobre la información.

- la clasificación de la información.

- la administración de usuarios y recursos.

Las normas de seguridad de la infraestructura tecnológica deben establecer:

- la administración de las claves de acceso

- la separación de ambientes

- copias de respaldo

- seguridad física

- prevención de virus informáticos

- seguridad de las comunicaciones

- control de eventos de seguridad

- instalación operativa de software

- procesos de seguridad informática ejecutados por la tecnologías de la información

- licencias de software

- tratamiento de personal externo

- acceso a recursos informáticos por parte de terceros

- accesos remotos y anillos de seguridad

- respuesta antes incidentes

- análisis de vulnerabilidades y/o intentos de intrusión

- administración de usuarios

- contratación de proveedores de tecnologías de la información.

Los principales ataques que se pronosticaron para el año 2010 por Websense Security Labs (Websense, 2009), sobre los que se ha venido trabajando para reducir vulnerabilidades y riesgos, minimizar las afectaciones y en dar respuesta a las contingencias garantizando la recuperación en breve plazo, fueron:

- Los ataques a la Web 2.0 incrementarán su sofisticación y preponderancia, en particular de virus y troyanos a través de las redes sociales como Facebook, Twitter, MySpace y Google Wave.

- Las campañas de Bonet, término que hace referencia a un conjunto de robots informáticos o bots, que se ejecutan de manera autónoma y automática, ejecutarán ataques masivos.

Los e-mail como vector para ataques ganarán sofisticación a la hora de desplegar ataques maliciosos a través de troyanos adjuntos a los archivos enviados por esta vía, desarrollándose ataques de difícil localización. - Se pronostican ataques dirigidos a los nuevos sistemas operativos incluyendo a MS Windows y a Internet Explorer que ganarán en flexibilidad afectando la confianza del usuario.

- Los hackers se concentrarán más en los teléfonos inteligentes. A finales de 2009 Websense Security Labs reveló la posibilidad de ataques masivos sobre la telefonía inteligente, representando el mayor ataque sobre las plataformas de iPhone. iPhone y Android se usarán con propósitos de negocios y se estima serán blanco preferido.

Publicidad maliciosa en sitios con alta credibilidad. Los visitantes del sitio podrían acceder a anuncios publicitarios ilegítimos sin que el soporte del sitio lograra detectarlo. - Los hackers no han ignorado el rápido crecimiento del mercado de Apple. Apple ante la dinámica de la Web 2.0, el uso maligno de los e-mails y las tácticas de posicionamiento maligno ha asumido el desafío de unificar el contenido de su plataforma de seguridad para protegerla de ataques Web combinados.

El resumen ejecutivo de WEBsense del 2012 (Websense, 2012) se aborda como principales amenazas el robo de datos, los ataques dirigidos, y los exploit kits. Actualmente casi todos los ataques tienen un componente web y aprovechan el factor humano como el eslabón más débil. La ingeniería social se combina con perfil social y la geolocalización para facilitar los ataques dirigidos. Un alto volumen ataques era rápidamente capturados por los sistemas de vigilancia de amenazas, razón por la que han sido sustituidos por los ataques especializados enfocados que utilizan exploits para el envío altamente eficaz de la amenaza.

El mundo de la web estática es historia, hoy todo es dinámico. La entrega dinámica de señuelos, el uso de descargas dinámicas, y el tráfico dinámico call-home utilizados en las amenazas avanzadas constituyen la regla. Las tácticas se vuelven más sofisticadas cada mes. Los ciclos de vida de adopción del software malicioso o malware son conducidos por innovaciones cada vez más rápidas en los ataques que evaden el monitoreo enfocado a individuos específicos. Los ataques son cada vez más dirigidos a las vulnerabilidades de las aplicaciones que se descubren mediante exploit kits y en menor cuantía a los sistemas operativos debido al ciclo automático de corrección de sus vulnerabilidades.

En una era de grandes volúmenes de datos y el análisis por computadora se crean defensas predictivas que se ajustan automáticamente a la evaluación en tiempo real, que debe realizarse en el momento en que un usuario accede al contenido deseado web. Para ser eficaces, las defensas de hoy necesitan para proporcionar protección analizar el tráfico de salida para detectar el robo de datos, ya que las defensas más tradicionales no lo hacían. La protección de datos es absolutamente un punto débil para la mayoría de las organizaciones.

Los ataques pueden ser descritos en seis fases o stages: señuelos, redirecciones, exploit kits, dropper files, comunicaciones call-home y el robo de datos. Cada fase tiene características únicas que necesitan defensas específicas. Las defensas tradicionales se han centrado durante años en la cuarta fase en busca de archivos maliciosos. Sin embargo, los ataques ahora utilizan dropper files únicos que no son detectados en horas o días por las defensas tradicionales durante el análisis del ataque.

Una revisión ejecutiva de las estadísticas del año 2012 (Websense, 2012) indica lo siguiente:

- El 82% de los sitios Web maliciosos están hospedados en servidores comprometidos.

- El 55% del robo de datos de comunicaciones de software malicioso o malware están basados en web.

- El 43% de la actividad en el interior de Facebook se clasifica como transmisión de medias.

- El 50% de las conexiones de software malicioso conducen a los Estados Unidos.

- El 60% de los ataques de suplantación de identidad o phishing ocurren en los Estados Unidos.

- El 36% del software malicioso está alojado en los Estados Unidos.

Después de Estados Unidos, Canadá y Rusia son los dos principales anfitriones de contenidos no deseados. La existencia de más de 8 de cada 10 sitios web maliciosos alojados en servidores comprometidos es inaceptable para una sociedad que se mueve a la nube como una red troncal para el comercio, las comunicaciones y la cultura. Debido a que casi ninguna organización bloquea masivamente dominios de los Estados Unidos o Canadá, ellos son opciones lógicas para las comunicaciones, el alojamiento y la suplantación de identidad o phishing de software malicioso. La trasmisión (streaming) de medias ocupa un lugar importante dentro de Facebook y el cibercrimen ha respondido aumentando el uso de señuelos de vídeo. La alianza de Websense con Facebook está encaminada a estudiar la actividad de las redes sociales.

En resumen, las redes sociales continúan dominando las comunicaciones, la movilidad y la computación en nube, amplían los perímetros de seguridad a los dispositivos, redes y aplicaciones que ya no controlamos. Lo que queda bajo nuestro control son nuestros datos. El cambio de la gestión de riesgos y las defensas para proteger los datos confidenciales es urgente e imperativo.

Estrategias de seguridad en la WEB

Las defensas en tiempo real que analizan el tráfico entrante y saliente en busca de las seis fases de amenazas avanzadas en los portales web son ahora más importantes que nunca. Durante más de una década las defensas tradicionales han sido eficaces. Sin embargo, el estado del malware y la ciberdelincuencia moderna ha avanzado más allá de sus capacidades. Las defensas eficaces están cambiando los puntos finales, como es el caso de los dispositivos móviles, que son cada vez más heterogéneos, pequeños, ligeros, con una mayor duración de sus baterías y menor consumo. La incapacidad para organizar las capas de defensas en puntos finales con actualizaciones en tiempo real hace que necesariamente se muevan las defensas a las pasarelas y a los servicios en la nube.

La computación en la nube está incrementando el uso de HTTPS para túneles seguros. Las redes sociales dentro de los círculos privados de amigos requieren particular atención en el trabajo de chequeo de URL recopiladas por las defensas asistidas en la nube. Defensas en línea con análisis en tiempo real más allá del antivirus y el filtrado de URL son muy recomendables. A los administradores se les recomienda monitorear las tasas de crecimiento de HTTPS y planificar el impacto de mover a la nube de servicios de aplicaciones que pueden generar múltiples túneles seguros por usuario. Como regla general, las pasarelas web proporcionan aproximadamente una quinta parte del rendimiento para HTTPS del que proporcionan para HTTP. Para los dispositivos de red como paredes de fuego o firewalls, la proporción es aún peor, ya que HTTPS tiene un mayor impacto en el rendimiento. Por último, muchas defensas son ciegas al tráfico HTTPS, por lo que las estrategias de seguridad deben ser revisadas.

Las defensas más efectivas y eficientes aprovechan grandes volúmenes de datos, aprendizaje automático, y los análisis predictivos para crear defensas que bloquean las amenazas sobre las solicitudes de salida para las fases uno y dos de amenazas avanzadas. El tráfico saliente en las pasarelas web es de aproximadamente el 15% de la carga de tráfico, mientras peticiones de retorno web son aproximadamente el 85% de la carga de tráfico. Defensas sobre el tráfico de retorno, principalmente en las fases tres y cuatro de amenazas avanzadas necesitan eficientes evaluaciones de defensa en tiempo real que puedan ajustarse automáticamente al contexto variable de seguridad.

Los administradores que emplean el filtrado de URL en dispositivos de red y siguen confiando en las tradicionales defensas antivirus, paredes de fuego y sistemas de detección de intrusos probablemente estarán en presencia de crecientes tasas de incidentes de malware y de un incremento en la actividad de asistencia técnica. Lo que puede parecer como una forma de ahorrar dinero en realidad se traduce en mayores gastos de recuperación y mayor riesgo. El filtrado de URL debe ser actualizado para pasarelas Web con defensas en tiempo real debido a que el delito cibernético aprovecha la entrega dinámica, el contenido y las técnicas call-home.

Las defensas contra para call-home y el robo de datos no deben ser ignoradas. El pasado año, muchas empresas líderes han sido víctimas de robo de datos. Motores DLP (Data Loss Prevention) integrados en las pasarelas web para la protección contra el robo de datos se están convirtiendo en el centro de atención de un nuevo enfoque para la reducción de riesgos.

CONCLUSIONES

Nuevos modelos están en proceso de desarrollo que incluyen las redes sociales que se consolidan como plataformas de comunicación y avanzan hacia nuevas formas de marketing y conexión profesional en la Web 2.0.

Los patrones de diseño y modelos del negocio característicos de la Web 2.0 han incidido también en el comercio electrónico. Reconocer este nuevo entorno en la Web 2 .0 y 3.0 caracterizado por la velocidad de los cambios y actuar en consecuencia ha dado como resultado nuevas estrategias empresariales de comercio electrónico en CITMATEL en un proceso multifactorial de mejora continua que ha logrado incrementar sus ventas a través de las plataformas que ha desarrollado y que combinan múltiples herramientas de gestión. La seguridad es un aspecto crítico del comercio electrónico y la mejora en estos procesos podría expandir la confianza de los clientes. La mejora continua en la gestión de riesgos y en las defensas para proteger los datos y procesos es urgente e imperativa.

REFERENCIAS BIBLIOGRÁFICAS

FERNÁNDEZ NODARSE, F. La web 2.0 y 3.0: de los datos al conocimiento. En Memorias de la XIV Convención y Feria Internacional Informática 2011, ISBN 978-959-7213-01-7, Habana, Cuba, 2011.

FERNÁNDEZ NODARSE, F. Nuevas experiencias en el desarrollo de espacios virtuales en Internet para la educación y el comercio electrónico: Universidad virtual del CITMA y BazarCuba, En Memoria de VIII Congreso Internacional de Matemática y Ciencias de la Computación COMPUMAT 2003, ISBN 17286042, Sancti Spiritus, Cuba, 2003

FERNÁNDEZ NODARSE, F. Entornos virtuales de aprendizaje y comercio electrónico en la web 2.0 y 3.0. En memorias de XIV Convención y Feria Internacional Informática 2011, ISBN 978-959-7213-01-7, Habana, Cuba, 2011.

FRY, D. Web 2.0 E-Commerce: A New Era of Competition. [En línea]. [Consultado el: 1 de septiembre de 2012] Disponible en: http://www.ecommercetimes.com/story/58640.html

FUMERO, A.; ROCA, G. Web 2.0, Fundación Orange España, mayo 2007; http://www.oei.es/salactsi/web_def_completo2.pdf

FUNDACIÓN ORANGE. Mapa visual de la Web 2.0. [En línea]. [Consultado el: 10 de Septiembre de 2010] Disponible en: http://internality.com/web20

GRAM, P. Web 2.0. [En línea]. [Consultado el: 15 de Septiembre de 2010] Disponible en: http://www.paulgraham. com/web20.html

MIC. Reglamento de Seguridad para las Tecnologías de la Información. Habana, Ministerio de Informática y las Comunicaciones, 2007. 23 p.

MINISTERIO DE LA PRESIDENCIA. Esquema Nacional de Seguridad. Madrid, Secretaria General Técnica del Ministerio de la Presidencia, 2010. 58 p

O'REILLY, T. What Is Web 2.0: Design Patterns and Business Models for the Next Generation of Software. International Journal of Digital Economics, 2007, 65: p.17-37.

Predicciones para 2010 de Websense Security Labs. [En línea]. [Consultado el: 15 de Diciembre de 2009] Disponible en: http://securitylabs.websense.com

RAMBIA J.L.; ALONSO CEBRIÁN J.M. Esquena Nacional de Seguridad con Microsoft. Madrid, Microsoft Ibérica S.R.L, 2009. 218 p

RIBES, X. La Web 2.0. El valor de los metadatos y de la inteligencia colectiva, Telos Cuadernos de Comunicación e Innovación, 2007, 73, p. 36-43.

WIPE, C. E-commerce en la era del 2.0: Crecimiento sostenido para el canal de negocios on line. [En línea]. [Consultado el: 15 de septiembre de 2012] Disponible en: http://www.ebanking.cl/marketing/e-commerce-en-la-era-del-20-crecimiento-sostenido-para-el-canal-de-negocios-on-line-00318

WEB Sense 2012 Threat report, [En línea]. [Consultado el: 19 de septiembre de 2012] Disponible en: http://securitylabs.websense.com.

Recibido: 23/04/2013

Aceptado: 04/09/2013