INTRODUCCIÓN

La evaluación del aprendizaje es un tema que históricamente ha sido centro de atención y preocupación para la comunidad pedagógica. Su importancia está fundamentada en su papel como componente didáctico y sus aportes a la enseñanza y la mejora educativa (González, 2000; Amaro y Chacín, 2017; Cáceres, Pérez y Callado, 2019), junto con la responsabilidad asignada para valorar los procesos y los resultados de aprendizaje y la emisión de juicios de valor al respecto (Pasek de Pinto y Briceño, 2015).

En este sentido, varios autores (Jordán, Morán y Camacho, 2017) han llamado la atención sobre la importancia de la información que se puede obtener a través de los procesos evaluativos y su interpretación, y su utilidad en la toma de decisiones para elevar la calidad del proceso de enseñanza-aprendizaje del que forma parte, reconociéndose así el fin educativo y la función retroalimentadora de la evaluación (Moreno, 2016; Canabal y Margalef, 2017). Estos dos aspectos marcan de manera significativa los nuevos retos y desafíos de la evaluación formativa (Ravela, 2009; Gallardo, 2018), que hoy están impactados, además, por entornos virtuales y las nuevas tecnologías (Yuste, Alonso y Blázquez, 2012).

Sin embargo, el carácter formativo de la evaluación que se desarrolla habitualmente en las escuelas y universidades está en dudas. Numerosas investigaciones refieren y fundamentan diversas dificultades y problemas que han podido ser detectados, evidenciándose la persistencia de concepciones y prácticas evaluativas tradicionales (Barberá, 2003; Contreras, 2010; Hernández y Mola; 2016; Hernández, 2017). Al parecer, la evaluación formativa está presente más en la intención y el discurso que en la práctica real. Curiosamente, existen muy pocas evidencias que hagan suponer que los procesos de evaluación del aprendizaje son, a su vez, evaluados regularmente.

Tal realidad apunta a la necesidad de trabajar en un área en la que paradójicamente se ha incursionado poco: la metaevaluación del aprendizaje, es decir, la evaluación de la evaluación del aprendizaje (García, 2000; Díaz, 2001; RAE, 2018). Es elemental que todo proceso educativo que se desarrolla necesita de otro que a la vez funcione como un mecanismo de control, regulador y verificador que permita conocer si las cosas se están haciendo correctamente. La evaluación del aprendizaje no es la excepción.

Así, desde que Ralph Tyler (1950, 1969) promulgara las primeras ideas y pautas sobre la evaluación formativa, se preocupó por sistematizar su cuerpo teórico-metodológico, como modo de garantizar la correspondencia entre su implementación y sus fines formativos. Desde entonces, muchos han sido los esfuerzos y los aportes para su perfeccionamiento (Scriven, 1967; Stake, 1967; Mateo, 2006). En su evolución histórica y a la par del desarrollo de la psicología, la pedagogía y otras ciencias, se han ido generando e implementando diversos modelos que, con distintos enfoques, han ido brindado alternativas que respaldan progresivamente sus bases conceptuales y el accionar hacia los fines formativos (Escudero, 2003; Mora, 2004).

Y en efecto, no puede decirse que no se han logrado ciertos avances. Numerosos trabajos publicados y experiencias divulgadas dan cuenta de que la comunidad pedagógica ha adquirido mayor conciencia de la necesidad de mejorar la evaluación del aprendizaje, observándose un crecimiento en la producción de artículos en la modalidad de reseñas y de ensayos críticos, de propuestas metodológicas e implementaciones que han mostrado la posibilidad de mejorar el carácter y el efecto formativo de la evaluación (Hernández, 2015; Hernández, Gregori y Tomalá, 2018; Carmen, Rodríguez, García-Redondo y San Pedro, 2019; Villarroel et al., 2019).

También se ha observado un incremento de las investigaciones empíricas sobre la evaluación del aprendizaje en los últimos cinco años, enfocadas principalmente a indagar sobre la percepción que tienen los estudiantes sobre dicho proceso y la valoración que hacen los profesores de sus propias prácticas (Estupiñán, Carpio, del Rocío y Romero, 2016; Rodríguez-Espinosa, Restrepo-Betancur y Luna-Cabrera, 2016; Martínez, Santos y Castejón, 2017), incluido un trabajo surgido del proyecto de investigación MEVALAP, en desarrollo en la Universidad Península de Santa Elena, Ecuador (Suárez-Villao, Domínguez y Gallegos, 2018). Esto demuestra las preocupaciones crecientes de los profesores por comprender más acerca de la evaluación, sobre lo que está sucediendo y sobre el ejercicio de los que participan en ella.

Sin embargo, persisten aún numerosos problemas pendientes de solución (Hernández, 2017), y la revisión hecha en la Internet revela que son muy escasos los trabajos e investigaciones en el área de la metaevaluación del aprendizaje. Se ha observado (García, 2000) que: «algunas de las metaevaluaciones más significativas que se han llevado a cabo hasta la fecha no son sino aplicaciones de modelos teóricos elaborados para la realización de evaluaciones […] Solo una pequeña proporción de estudios de evaluación son, a su vez, evaluados» (p. 1).

Si bien «la meta-evaluación está en la agenda de la Educación Superior», como plantea desde su título un interesante artículo (Marcipar y Luciani, 2017), lo cierto es que desde que Michael Scriven elaborara sus primeros trabajos en la década del sesenta del pasado siglo (Scriven, 1967), este tipo de proceso evaluativo se ha efectuado históricamente solo en algunas áreas preferentemente: en la evaluación de programas, de proyectos, de carreras y de instituciones educativas (Díaz, 2001; González, Sarzosa y López, 2018), pero no ha sido frecuente ni en igual profundidad en la evaluación del aprendizaje.

Scriven y otros autores se interesaron en asegurar las bases teóricas de la metaevaluación y su sistematización, para lo cual se plantearon una serie de ítems, parámetros y aspectos, como la célebre «Checklist» (MEC), que permitió predefinir aquellas cuestiones que eran importantes observar, controlar y evaluar (Scriven, 1967, 1991; Stufflebeam y Shinkfield, 1993), pero como ya se ha dicho, enfocados en la evaluación de instituciones, de sistemas educativos y de programas en sus objetivos y decisiones.

Tanto la evaluación del aprendizaje como la metaevaluación se sustentan en bases teóricas semejantes. Sus propósitos son los mismos, pero sus objetivos y sus procedimientos no son exactamente iguales. Según Díaz (2001): «La metaevaluación no solo transcurre por los hechos y los datos evaluados, sino que trasciende la evaluación. El objetivo de la primera se distingue de la segunda en su focalización y en el número y la naturaleza de las variables a estudiar; es decir, en la racionalidad y la complejidad» (p. 2).

Ambas (evaluación del aprendizaje y metaevaluación) son herramientas de cambio y vías para el perfeccionamiento del ejercicio profesoral y para vencer los nuevos retos educativos (Ravela, 2009). Por tanto, es obvio que para la metaevaluación del aprendizaje también se asegure el disponer de una base teórica sistematizada y que estén delimitados aquellos aspectos que merecen ser observados y evaluados para acometer los planes de mejoras necesarios y la ayuda al profesorado.

En esta dirección, se efectuó una búsqueda bibliográfica, encontrándose que solo unos pocos trabajos abordan e indagan sobre la evaluación de las evaluaciones del aprendizaje (Vásquez y Sosa, 2016; Sepúlveda, Payahuala, Lemarie y Opazo, 2017), pero ninguno presenta una propuesta teórica concreta al efecto. Dos de ellos sobresalen como excepción: un estudio efectuado en la Universidad Nacional del Litoral, en Argentina, donde se presentó un modelo metodológico para la evaluación de las evaluaciones en las asignaturas Inglés Técnico y Matemática Básica (Marcipar y Luciani, 2017) y otro desarrollado en la Universidad de Granada (Gómez, 2015).

En el primero los autores asumieron lo que denominan como «itinerarios», una relación de aspectos que incluye las iniciativas de los participantes, las estrategias, los métodos y procedimientos, el tratamiento de datos y el contenido de los informes entregados, partiendo de la información que brindaron un grupo de evaluadores seleccionados. En el segundo, aún y cuando en este caso se trató de la evaluación de proyectos de investigación y no la metaevaluación del aprendizaje, resultó llamativo el uso hecho de criterios de evaluación, considerando la necesidad de disponer de informes de excelencia y fiables, donde fue de interés conocer cómo eran trasladados estos criterios a los informes que eran emitidos.

Todo indica que en la evaluación de los procesos evaluativos del aprendizaje se necesita establecer un conjunto de aspectos que permitan sistematizar la base teórica y delimitar con precisión aquellas cuestiones que son de interés observar, valorar y mejorar. Esto permite determinar cuál es el carácter que predomina en la evaluación del aprendizaje que efectúa el profesorado y cuáles son los logros y las fallas, lo que posibilitará brindarles las ayudas necesarias y establecer planes de mejoras efectivas. Además, se asegura la validez y la fiabilidad de los resultados obtenidos.

Por otra parte, se ha observado que con frecuencia los docentes no llegan a realizar ningún proceso sistematizado de aprendizaje personal a partir de los resultados obtenidos de las evaluaciones que realizan, limitándose a una «única actuación posterior […] archivarlos o guardarlos por un determinado tiempo según las normativas vigentes» (Marcipar y Luciani, 2017, p. 187), lo que robustece la necesidad de hacer aportes en la sistematización de la base teórica de procesos que, como la metaevaluación, resultan vías de retroalimentación y aprendizaje profesional.

En el terreno de la metaevaluación de la calidad educativa, de la gestión institucional, del desarrollo de proyectos y la gestión pedagógica, históricamente se han empleado estándares, criterios, subcriterios, parámetros, variables, dimensiones e indicadores y otros vocablos (Morduchowicz, 2006; García Cabrero, 2010; Guerrero, 2015; Feu, Simó, Serra y Canimas, 2016) a manera de patrón, norma o referente, que como parte de un sistema de conceptos, sirven para guiar el accionar evaluativo (RAE, 2018). Sin embargo, pueden bastar dos de ellos para considerar una metaevaluación del aprendizaje sustentada: indicadores y dimensiones.

Los indicadores revelan los rasgos y propiedades de un objeto, un proceso o fenómeno, permitiendo informarnos sobre sus características y comportamiento (Jesús y Martínez, 1991; Hernández, 2006; Morduchowicz, 2006; RAE, 2018). En el ámbito educativo, han sido considerados habitualmente como una serie de datos que los sistemas escolares suelen emplear para poder definirse, caracterizarse, describirse, analizarse, legitimarse y monitorearse, llegándose a reconocer y utilizar generalmente como una medida estadística (Lozano, 2001).

Las dimensiones pueden contener o englobar una serie o sistema de indicadores, considerándose algunos aspectos que los delimitan, tales como: su contenido, el alcance del estudio, el tipo de información que se busca. Se considera que varios indicadores pueden corresponder a una misma dimensión, sin desconocer que, en el terreno de la educación, en particular de la evaluación, existen fuertes relaciones e interdependencias entre los distintos procesos o las variables que sobre esto informan.

El establecimiento de indicadores y de sus dimensiones correspondientes implica un juicioso ejercicio de conceptualización que requiere del análisis de fuentes bibliográficas especializadas y experiencias previas, ya que existen muchos términos y conceptos que con disímiles significados pedagógicos y connotaciones suelen encontrarse en las distintas publicaciones consultadas, lo cual genera incertidumbres y confusiones conceptuales (Santos y Moreno, 2004; Arribas y Estebaranz, 2017).

Por estas razones, es relevante construir indicadores que respondan a dimensiones fundamentales que sean útiles en la metaevaluación del aprendizaje, lo que es el objetivo fundamental de este trabajo, en el que, partiendo de una experiencia empírica previa desarrollada en la Universidad Estatal Península de Santa Elena (UPSE) y resultados preliminares de una prueba piloto, se llega a una propuesta concreta fundamentada y que constituye una herramienta teórico-metodológica útil, replicable en otros estudios que pudieran enriquecerla, validarla y ayudar a perfeccionarla.

1. ESTUDIO PILOTO PREVIO

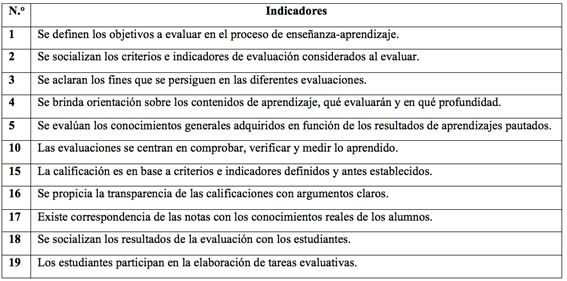

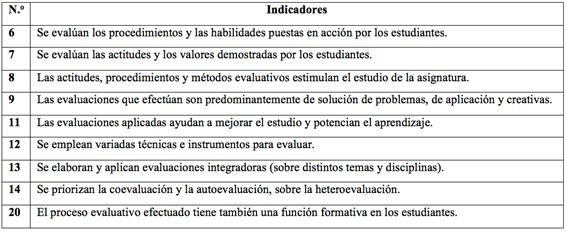

Se construyeron 20 indicadores relacionados con la evaluación de evaluaciones, los que derivaron de la revisión de literatura especializada en el tema. Mediante cuestionarios y utilizándose una escala de Likert, se aplicaron a una muestra aleatoria de estudiantes, quienes fungieron como evaluadores del proceso evaluativo del aprendizaje que habitualmente se desarrolla por el profesor. La muestra estuvo compuesta por 1 070 estudiantes de pregrado de la Universidad Península de Santa Elena, del 3.ro y 4.to años, con suficientes vivencias evaluativas.

El procesamiento de los datos mostró un coeficiente del Alfa de Cronbach de 0,943, lo que representa una elevada confiabilidad o consistencia interna del constructo, indicativo de una alta relación. Al realizar un análisis factorial exploratorio (AFE) de estos 20 indicadores, se encontró una solución de dos factores que agrupaban a todos los ítems, mostrando un 49,1 % de varianza. Uno de ellos, con once indicadores, explicaba el 45,51 % (Tabla 1) y el otro, con nueve indicadores, el 3,4 % (Tabla 2).

Conceptualmente, cada factor podría interpretarse como dimensiones distintas de la metaevaluación efectuada. Por ejemplo, el factor 1 reúne indicadores que recaban información sobre cuestiones éticas de la evaluación, lo evaluado y también criterios acerca de cómo se evalúa. El factor 2, por su parte, agrupa aquellos que se refieren a qué se evalúa y cómo se relaciona lo que se evalúa con lo que aprenden los estudiantes.

Estos resultados preliminares coincidieron en cierta medida con algunos trabajos que han abordado la evaluación del aprendizaje, donde al menos se han reconocido dos dimensiones: la ética y la metodológica (Jesús y Martínez, 1991; González, 2000; Hernández, 2006; Morduchowicz, 2006; Serrano de Moreno, 2008; Leyva, 2010; RAE, 2018), lo cual tiene un significado de referencia. Sin embargo, en lo concerniente a la metaevaluación del aprendizaje, se pueden considerar otros agrupamientos de indicadores en otras dimensiones que, en todo caso, pueden ayudar a focalizar mejor los análisis en áreas o grupos de indicadores que por su estrecha relación permitan obtener informaciones más específicas y detalladas sobre ciertos aspectos del proceso.

Resulta importante ampliar el espectro de los análisis en las metaevaluaciones, de manera que no solo indaguen e informen sobre lo académico, sino también sobre lo ético, lo actitudinal y sobre el proceder a lo largo del proceso de evaluación. En tal sentido Laies (2003) ha planteado: «no se han construido indicadores capaces de dar cuenta del conjunto de misiones y funciones que se le encomendaron al sistema educativo […] Quizás el problema resida en que, tal como dijimos previamente, se ha medido pero no evaluado, y medido determinadas variables y no otras» (p. 22).

2. PROPUESTA TEÓRICA

A partir del estudio piloto, se retomó la revisión bibliográfica y se reflexionó en cuestiones de interés a la hora de valorar una serie de aspectos que resultan ser esenciales y decisores en el logro de una evaluación formativa:

¿Qué preceptos éticos guían la evaluación?

¿Para qué evaluar?

¿Qué evaluar?

¿Cómo evaluar?

¿Quiénes evalúan?

¿Cuál es el resultado cognitivo, efectivo-actitudinal de los estudiantes ante las evaluaciones?

¿Cómo se utilizan los resultados salidos de la evaluación?

¿Cuáles decisiones se toman ante los resultados de aprendizaje obtenidos?

Estas interrogantes se asumieron como dimensiones valorables que bien pueden agrupar un número no definido de indicadores. Para asegurar la validez del contenido se realizó un estudio de la bibliografía especializada en el tema de la evaluación, se aplicó un cuestionario a trece docentes con amplia experiencia pedagógica de cinco universidades de tres países de Latinoamérica: Ecuador, Chile y Cuba, considerándose las categorías pertinente, representativo y funcional y fueron analizados varios artículos que definen fundamentos al respecto (Escudero, 2003; Vargas y Máynez, 2016; Ibarra-Piza, Segredo-Santamaría, Juárez y Tobón, 2018).

A continuación se presentan las siete dimensiones que se proponen para la metaevaluación de los aprendizajes, con sus fundamentos. Posteriormente se relacionan los indicadores que pueden agruparse en cada una de ellas.

3. DIMENSIONES

3.1. Dimensión ética de la evaluación del aprendizaje (¿qué preceptos éticos la guían?)

La ética está relacionada con el modo en que se conduce una persona en correspondencia a ciertos principios que le confieren coherencia entre lo que dice y lo que hace, y valor adquirido por lo que de bueno aporta a otros y a sí mismo, ya sea por sus significados como por los valores humanos que se promueven y potencian.

Lo ético en la evaluación está dado en su transparencia, en el respeto que el profesor demuestra hacia sus estudiantes a partir del modo en que actúa y procede, en el valor educativo de sus acciones apegado a normas o acuerdos previamente tomados junto al colectivo estudiantil, lo cual legitima su actuación y le confiere valor educativo real.

Con frecuencia se escucha poco a los estudiantes y se les da pocas oportunidades para que participen en el proceso evaluativo. Se observan incongruencias o asimetrías entre el acto de evaluar y el modo de enseñar, escasa limpidez en las acciones e intencionalidades que la desvirtúan y el manejo de calificaciones como ajuste de cuentas. Una práctica evaluativa ética no desconcierta, no es punitiva, no apena, no avergüenza, ni pone velos a lo que debe ser conocido por los estudiantes y toda la comunidad universitaria, hechos que afectan las formaciones psicológicas del alumnado y la acción educativa (Cunill, García y Oramas, 2016; Pérez, 2016).

La ética nos mueve hacia el imperativo profesional y moral de reflexionar sobre el modo en que asumimos los principios éticos que han de sustentar las prácticas evaluativas, lo que ha de hacer replantearnos constantemente lo que hacemos, «es tomar distancia y volvernos sobre nosotros mismos» (Ormart, 2004, p. 104).

3.2. Dimensión de funcionalidad

Reconocida por algunos autores (Leyva, 2010), la dimensión de funcionalidad toma en cuenta los variados empleos asignados a la evaluación, lo que significa considerar hacia qué aspectos o fines está orientada dicha actividad, dando respuesta a «para qué evaluar». González (2000) lo ha definido excelentemente en su libro dedicado a la evaluación del aprendizaje en la enseñanza universitaria, donde fundamenta la diversidad de quehaceres de este proceso y destaca la relevancia que tienen las funciones pedagógicas y, en particular, las formativas.

De acuerdo con dicha autora, a la evaluación del aprendizaje le están asignadas varias funciones, tales como: definición de significado social, control, funciones pedagógicas (diagnóstica, pronóstico, potenciación del aprendizaje, retroalimentación, etcétera), regulación, organización y gestión educativa, algunas de las cuales son funciones formativas por su aporte al desarrollo del aprendizaje y al desarrollo integral de los aprendices.

Resulta fundamental la observación y valoración del cumplimiento de dichas funciones en el proceso de evaluación del aprendizaje: cuáles son las que prevalecen o se priorizan, qué tanto el proceso responde verdaderamente a las demandas, en qué grado está al servicio del aprendizaje de los estudiantes y de los propios profesores. Para estas cuestiones se deben construir indicadores que ayuden a la validez en la determinación de las cualidades del proceso.

3.3. Dimensión relativa al contenido de la evaluación (qué evaluar)

El contenido de la evaluación del aprendizaje lo define su objeto: el aprendizaje. Los avances de las neurociencias y el desplazamiento de los enfoques pedagógicos cognitivistas hacia el constructivismo social han permitido develar y fundamentar la complejidad inherente a la psiquis humana, al cerebro que aprende y al proceso de evaluación en el que se evalúa lo aprendido y participan estudiantes y profesores en interacción (Díaz y Hernández, 1999; Cubero, 2005).

El concepto de aprendizaje se ha ampliado. Se reconoce su complejidad, sus atributos, sus componentes cognitivo, afectivo y volitivo, que involucran lo procedimental y lo actitudinal (Ormrod, 2005), previendo no solo los contenidos temáticos o conceptuales que se registran en los programas de asignaturas, sino también lo que está en formación (Baca, Balmaceda, Baquero y Beltramino, 2018).

Como se ha señalado, «en materia de evaluación, todos los aspectos relativos a la educación son potencialmente evaluables; otra cosa es que merezcan serlo» (González, 2000, p. 35). Esto hace que al evaluarse cómo evalúan los profesores se observe si las tareas evaluativas se enfocan hacia aquellos aspectos que son trascendentes en el aprendizaje de los estudiantes, en su formación profesional, para la vida y su desarrollo integral.

3.4. Dimensión metodológica-instrumental (cómo evaluar)

La dimensión metodológico-instrumental permite considerar todos aquellos indicadores que pueden informar sobre cómo se está evaluando en las clases, lo cual apunta a los métodos, las técnicas, los procedimientos e instrumentos que son utilizados para la obtención de la información evaluativa, para llegar a la elaboración de un juicio evaluativo. Es obvio, entonces, que uno de los puntos claves a considerar sea la variedad y diversidad de instrumentos evaluativos empleados por el profesorado y que, desde un concepto amplio de aprendizaje, sea posible evaluar con validez los conocimientos conceptuales, los procedimentales y lo actitudinal, lo aprendido y lo que está en formación, lo que valida el concepto de zona de desarrollo próximo (Vigotsky, 1978).

También es necesario comprender que la manera de evaluar presupone una manera de enseñar y los fines propuestos por cada profesor. Esto puede dar pistas sobre el tipo de enseñanza que se realiza (Monereo y Lemus, 2010), lo que nos alerta en torno a las diversas conexiones y relaciones que pueden establecerse entre las distintas dimensiones de la metaevaluación y el principio de unidad entre enseñanza-aprendizaje-evaluación.

Los hallazgos y avances de las neurociencias y las tecnologías han brindado una importante información científica sobre cómo aprende el cerebro humano (Ortíz, 2015; Falco y Kuz, 2016), lo cual ha incrementado las formas de enseñar, aprender y evaluar (Muñoz-Repiso y Gómez-Pablos, 2015; Leiva, Cabero y Ugalde, 2018). Estos aspectos requieren ser considerados y observados en las metaevaluaciones del aprendizaje de manera actualizada.

3.5. Dimensión temporalidad (cuándo evaluar)

La dimensión temporalidad toma en consideración los criterios bajo los cuales se planifican y se ejecutan las distintas tareas evaluativas: en qué momento, con qué frecuencia, las condiciones psicológicas y el estado real de preparación en que se encuentran los estudiantes de cara a la evaluación. Esto presupone una visión estratégica de los profesores y evaluadores, en general, pensándose en la pertenencia de varios tipos de evaluación: inicial (diagnóstica), frecuente y sistemática, parcial y final (Leyva, 2010).

Se ha fundamentado la nocividad a que se ven propulsados muchas veces los procesos evaluativos y los profesores, a fin de rendir cuentas o reportes de resultados al cierre de ciertos periodos, en los cuales no siempre pueden apreciarse aún los avances y logros de los estudiantes. Cuando esto sucede, puede inferirse la práctica de una actitud finalista, donde la evaluación se limita a su función de comprobación, sin dar prioridad a la función de retroalimentación que poseen las evaluaciones y su contribución al aprendizaje de los estudiantes (Fariñas, 1999).

3.6. Dimensión relativa a la participación (quiénes evalúan)

La participación en la evaluación y la forma en que esto ocurre han sido centro de atención de muchos autores (González, 2000). Desde esta dimensión se toman en cuenta quiénes son los que participan de forma real en el proceso evaluativo, cómo lo hacen y en qué medida, lo que pone en zona de observación la aplicación de la coevaluación y la autoevaluación. Desde esta dimensión, se toman en cuenta los principios de democracia pues, como se ha estimado, involucrar a los estudiantes en la evaluación es empoderarlos y hacerlos responsable de su propio aprendizaje y comprometerlos con su mejora (Murillo e Hidalgo, 2016).

3.7. Dimensión utilitaria (qué usos darles a los resultados evaluativos)

Aunque se supone que el análisis de los resultados evaluativos debería ser centro de atención de los profesores, paradójicamente este suele quedar limitado a la emisión de notas e informes académicos de carácter cuantitativo y estadístico, lo que evidencia que la calificación suele constituir un momento final y conclusivo del proceso, donde se amputa su función retroalimentadora y los momentos más ricos de reflexión y concientización para implementar los reajustes necesarios para mejorar la enseñanza practicada. Por eso, la observación y evaluación de los usos dados a la evaluación resulta ser un aspecto fundamental en la metaevaluación.

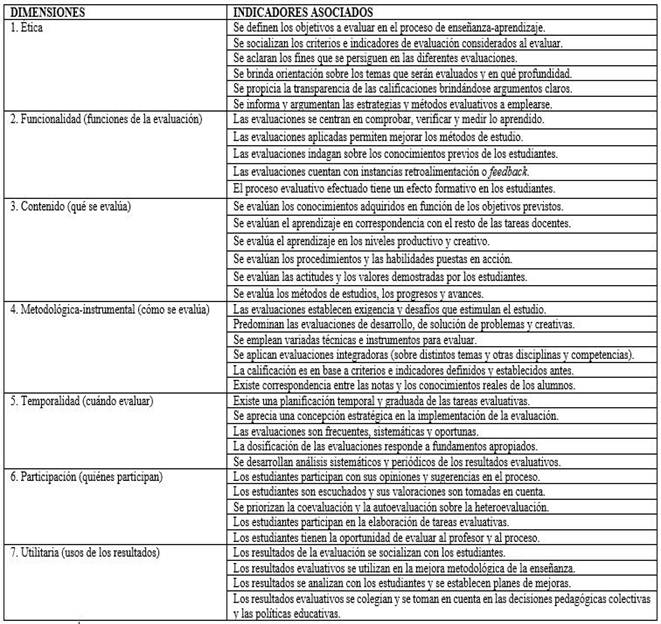

De acuerdo con todo lo planteado, se ofrece en la Tabla 3 las distintas dimensiones teóricas y la relación de indicadores que pueden estar relacionadas con cada una de ellas, lo que puede servir como una escala de apreciación del sistema evaluativo desde el punto de vista del profesor que diseña y aplica la metodología de evaluación, como también desde el punto de vista de los propios estudiantes que rinden tales evaluaciones.

Tabla 3 Dimensiones e indicadores relacionados con el estudio y la evaluación de los procesos de evaluación del aprendizaje desde una perspectiva teórica

Se comprende que la aplicación de esta propuesta en diferentes contextos educativos universitarios podría dar resultados diferentes; esto, lejos de preocupar o considerarse negativo, resulta aceptado y lógico, pues estaría respondiendo a la realidad evaluativa de dichos contextos de manera particular. Los estudios de esas realidades particulares podrían permitir establecer determinadas regularidades, que serían tal vez nuevos aportes al campo teórico y metodológico de la metaevaluación del aprendizaje. Esta propuesta permite analizar las relaciones globales entre los indicadores y posibilita efectuar observaciones en cada una de las dimensiones, ante lo cual cabe la posibilidad de efectuar estudios de similaridad, mediante distintos software y métodos estadísticos, como el del vecino más cercano (Johnson y Wichern, 1992), de donde podrían enriquecerse las interpretaciones de las múltiples realidades evaluativas en los distintos contextos.

CONCLUSIONES

La construcción teórica de las siete dimensiones y los treinta y siete indicadores que se proponen sirve para valorar los procesos de evaluación de los aprendizajes en una asignatura, en una carrera o institución. Esto permite identificar y comprender las fortalezas y las áreas de mejora necesaria. Gracias a que las dimensiones y los indicadores están fundamentados teóricamente, es posible adjudicar validez de contenido y de constructo a la escala, al sistematizar diferentes conceptos y eslabones del proceso evaluativo y, a la vez, ofrecer una opción más para valorar su validez empírica.

La propuesta constituye una herramienta teórico-metodológica que es factible para la metaevaluación del aprendizaje. Se facilita una mayor sistematización, precisión y profundidad de los análisis y la posibilidad de determinar las correlaciones entre dimensiones e indicadores. Además, se evita la segmentación habitual, lo que permite una mejor interpretación de los resultados. Esto ayuda a tomar decisiones acertadas y más efectivas en función de la mejora de los procesos evaluativos del aprendizaje.

La propuesta es llevada a la práctica en la Universidad Estatal Península de Santa Elena, Ecuador, con una importante participación de docentes, estudiantes, evaluadores áulicos, así como de miembros y numerosos colaboradores del proyecto MEVALAP. No obstante, puede ser más estudiada, perfeccionada y aplicada en otros contextos educativos, a fin de poner en valoración su viabilidad y aplicabilidad.