1. Introducción

Los Centros de Datos (CD), ya sean tradicionales o bajo el paradigma de la Computación en la Nube (CN), deben ser diseñados siguiendo un enfoque de arriba hacia abajo (top-down), en busca de una solución que realmente satisfaga los objetivos del negocio, las restricciones y requerimientos técnicos de las entidades que los necesitan. Actualmente, sin embargo, la tendencia es dimensionar para garantizar la Calidad de Servicio (QoS, Quality of Service), y adoptar las soluciones comerciales de pago de grandes proveedores, o simplemente aquellas que mayor presencia estén teniendo en el mundo de los CD o de la CN, sin tener presentes en primer lugar las necesidades y demandas del cliente. Una de las principales causas de este fenómeno es que no se cuenta con una consultoría o método que indique cómo planear CD desde la perspectiva del negocio, y en especial basadas en Software Libre y Código Abierto (SLCA). [1, 2]

La insuficiente articulación entre las estrategias para el despliegue de los CD privados, y los requerimientos de las entidades que los necesitan, se hace extensivo al diseño de los diferentes subsistemas que componen al CD, como es el caso del Sistema de Almacenamiento (SA). Este bloque tributa directamente al desempeño, la disponibilidad, la escalabilidad y la factibilidad económica del sistema en general, e incluso hoy constituye uno de los pilares de servicios con gran aceptación en el mercado como son la Infraestructura como Servicio (IaaS, Infrastructure as a Service) y el Almacenamiento como Servicio (DSaaS, Data Storage as a Service). [1] Es por ello, y por la necesidad de almacenar y administrar de manera eficiente, efectiva y segura los datos, que la tendencia es el diseño de SA basados en soluciones definidas por software y hardware Commercial Off-The-Shelf (COTS); es por tanto una tarea decisiva para el éxito del proyecto la selección adecuada de la solución de software a emplear.

Actualmente, sin embargo, este proceso puede resultar complejo, o en el peor de los casos superficial, debido a la deficiente información disponible en lo referente a cómo afrontar el diseño de un SA, en especial Definido por Software (SDS, Software Defined Storage) [3]. En la revisión bibliográfica enfocada a metodologías y/o pautas a seguir en el diseño de SA, realizada por los autores de la presente investigación, la mayoría de los documentos identificados fueron artículos indexados en conferencias, y muy pocos pertenecientes a artículos en revistas, lo que evidencia los pocos esfuerzos dedicados al tema.

En la academia la mayoría de las publicaciones se centran en las mejoras a las soluciones existentes como por ejemplo en: [4-10], mientras otras proponen sus diseños sin exponer comparativas o caracterizaciones que expliquen la adopción de la solución como en: [11,12]. Solo dos publicaciones referentes a propuestas de diseño de SA fueron identificadas por los autores del presente trabajo: [1 13], las que no abordan cómo seleccionar la solución de software para el SA. Este escenario se agrava para las soluciones de tipo SLCA, y para las entidades con presupuestos limitados, ya que la mayoría de las consultoras con prestigio internacional solo incluyen en sus reportes a las soluciones propietarias, como es el caso de RightScale, Forrester y WhatMatrix; o se necesita de un pago para tener acceso a los informes y análisis realizados, como demandan Gartner y la Consultora de Directivas Inteligentes (IDC, Intelligent Directions Consulting).

A partir del análisis de la situación problemática descrita, se llegó a la conclusión que la información disponible en la literatura especializada para guiar el proceso de selección de soluciones de tipo SLCA para desplegar SA es insuficiente. El objetivo de este trabajo fue identificar y caracterizar las principales soluciones SDS de tipo SLCA para Pequeñas y Medianas Empresas (PyME). La propuesta constituye una herramienta que agiliza y facilita el proceso de diseño de SA, impactando en la reducción del tiempo de diseño, así como en las Inversiones de Capital (CAPEX, Capital Expenditures) de los proyectos y en los Gastos de Operación (OPEX, Operating Expenses) una vez en explotación el SA. Para el desarrollo de la propuesta los autores realizaron un análisis bibliométrico en relación a la penetración de las soluciones SDS de tipo SLCA tanto en el ámbito empresarial como en el académico, y evaluaron las soluciones líderes tomando en cuenta los principales Requerimientos Funcionales (RF) y Requerimientos no Funcionales (RNF) de SA para PyME.

2. Penetración de las soluciones sds de tipo slca en los ámbitos industrial y académico

En post de identificar las principales soluciones SDS de tipo SLCA los autores del presente trabajo realizaron un análisis bibliométrico acerca de la penetración de estas soluciones en los ámbitos industrial y académico. Cinco tareas fueron desarrolladas: 1) identificación y estudio de reportes de reconocidas consultoras internacionales de la rama; 2) presencia de soluciones SDS en artículos científicos y eventos internacionales publicados en las bases de datos científico-técnicas de alto impacto: Instituto de Ingeniería Eléctrica y Electrónica (IEEE, Institute of Electrical and Electronics Engineers), Asociación de Maquinaria Computacional (ACM, Association for Computing Machinery) y Springer, entre los años 2017 al 2020; 3) soporte por parte de las principales Plataformas de Gestión de Nubes (CMP, Cloud Management Platform) de tipo SLCA; 4) identificación de los casos de uso en los que se estén explotando soluciones SDS de tipo SLCA; y 5) análisis de las tendencias en Google Trends.

Como parte de la Tarea 1 fueron analizados los reportes y comparativas de las consultoras Gartner, IDC, Forrester, RightScale y WhatMatrix, siendo las tres primeras las de mayor impacto internacional [14 15]. Gartner e IDC poseen análisis de tendencia y penetración que hacen referencia a soluciones como Ceph, HDFS y Lustre, pero la consulta a estos artículos se vio obstaculizada ya que es necesario pagar o estar afiliado a estas consultoras [16-19]. WhatMatrix por su parte, solo arroja comparativas de soluciones de pago, por lo que no aportó ningún elemento al objetivo de identificar herramientas SLCA líderes [20]. Por último, RightScale y Forrester no hacen referencia a soluciones SLCA en sus estudios [21-23]. Lo anterior ratifica, la insuficiencia de un procedimiento consensuado por la comunidad de la rama, que indique cómo elegir soluciones SDS de tipo SLCA.

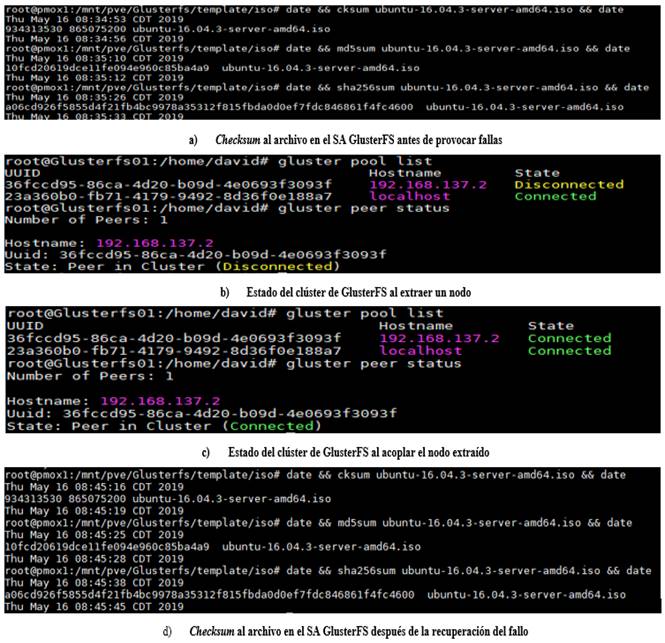

La Fig. 1 muestra los resultados del desarrollo de la Tarea 2. En la Fig. 1a se presenta el resultado del análisis de artículos en revistas y la Fig. 1b muestra los resultados del análisis de trabajos presentados en conferencias científicas. Se muestra que HDFS [24-26], Lustre [7,27,28] y Ceph [6,12,29,30] son las soluciones SDS de tipo SLCA que mayor penetración poseen en el mundo académico, mientras que GlusterFS [8,11,31], iRODS [32], PVFS [33] y OpenFiler [34] poseen una presencia muy baja. En contraste, en el ámbito industrial y empresarial no se observó el mismo comportamiento, como se evidencia en las Tareas 3, 4 y 5.

Fig. 1 Publicaciones académicas que adoptan u abogan por una solución SDS de tipo SLCA en particular

Los resultados de la Tarea 3 se presentan en la Tabla 1. Como se aprecia en esa tabla, el soporte de los CMP se encuentra dirigido principalmente a Ceph y GlusterFS, y en menor medida a OpenFiler.

Tabla 1 Soporte de soluciones SDS de tipo SLCA por los CMP líderes de tipo SLCA

| CMP | Solución que soportan | |||||||

|---|---|---|---|---|---|---|---|---|

| Ceph | HDFS | Lustre | GlusterFS | FreeNAS | iRODS | OpenFiler | PVFS | |

| X | - | - | X | - | - | X | - | |

| X | - | - | X | X | - | X | - | |

| X | - | X | X | - | - | - | - | |

| X | - | - | X | - | - | X | - | |

Los resultados de la Tarea 4 se presentan en la Tabla 2. En la misma se aprecia que en las universidades y PyME los de mayor penetración son Ceph, iRODS y HDFS.

Tabla 2 Casos de uso de las soluciones SDS de tipo SLCA

| Soluciones | Universidades | Empresas de Telecomunicaciones | Grandes Entidades | PyME |

|---|---|---|---|---|

| Ceph | Universidad MONASH [35] | Deutsche Telekom, SK Telecom, ZTE, Verizon [35] | CERN, Cisco, DigitalOcean, Western Digital, Teradata, Rackspace, Proxmox [35] | DreamHost, Despegar.com, Dolphin IT - SYSTEME, Atol, Keeper Technology, WATERSHED, |

| GlusterFS1 | - | - | Comcast, CenturyLink [36] |

|

| FreeNAS | Universidad de Florida, Universidad del Estado de Michigan [37] | - |

|

|

| HDFS | - | - | CERN, |

|

| iRODS |

|

- | Bayer, IBM, Intel, Dell EMC, Western Digital, NetApp, Centro de Computación Avanzado de Texas [39] | RENCI, NIEHS DDN, |

| PVFS | - | - | - | - |

| OpenFiler | - | Motorola [40] |

|

BillMeLater, Policía Metropolitana de Londres [40] |

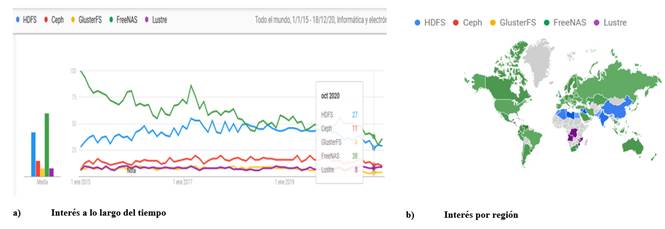

En el análisis de las tendencias en Google Trends que se desarrolló dentro de la Tarea 5, se identificó que las soluciones que mayor interés recibieron en Google hasta el momento de la investigación fueron FreeNAS, HDFS y Ceph. La Fig. 2a muestra los resultados del análisis realizado utilizando como criterio de medida el interés a lo largo del tiempo, y en la Fig. 2b se presentan los resultados teniendo en cuenta el interés por región.

Como resultado del análisis anterior, en la investigación se decidió considerar como las principales soluciones SDS de tipo SLCA a Ceph, GlusterFS y FreeNAS. Ceph con presencia en el mundo académico, es soportado por los cuatro CMP de tipo SLCA líderes, siendo declarado en [41] como el SDS más empleado en infraestructuras desplegadas con OpenStack, así como en infraestructuras convergentes con Proxmox [42]. OpenStack constituye el estándar de facto en relación a los CMP de tipo SLCA, mientras Proxmox es un gestor de CD Virtualizados (CDV) con gran penetración en PyME, en consecuencia, Ceph podría considerarse un estándar de facto entre los SDS de tipo SLCA. GlusterFS, a pesar de tener poca presencia en los artículos y eventos científicos, posee presencia en el mundo empresarial e industrial, recibiendo el soporte de los cuatro CMP considerados. FreeNAS, a pesar de no contar con presencia en el ámbito académico y ser solo soportado por Proxmox, es la solución más destacada en el análisis realizado empleando la herramienta Google Trends, evidenciándose en la Fig. 2b su interés en varias regiones del mundo.

Al mismo tiempo HDFS, a pesar de destacar en todos los análisis realizados, es empleado principalmente en entornos de Big Data y de Computación de Alto Rendimiento (HPC, High Performance Computing), lo que no es la generalidad en las PyME. Por otro lado, Lustre, con gran presencia en la academia, posee poca penetración en la industria, mientras que PVFS e iRODS no son objetos de estudio en documentos científico-técnicos, así como tampoco son soportadas por ninguna de las soluciones CMP SLCA analizadas. A su vez, OpenFiler no destacó frente a FreeNAS en el estudio realizado en las PyME.

3. Evaluación de las principales sds de tipo slca: ceph, glusterfs y freenas

Con el objetivo de caracterizar a las soluciones SDS de tipo SLCA identificadas como principales en la Sección 2, dos tareas fueron realizadas: identificar el soporte de importantes RF y evaluar el comportamiento de las soluciones en los RNF de desempeño y disponibilidad.

3.1.- Identificación del soporte brindado a importantes rf

La Tabla 3 resume los resultados del estudio realizado donde fueron analizados 11 RF. De manera general los tres softwares poseen buenas funcionalidades. Ceph destaca por soportar el mayor número de RF, lo que ratifica la gran comunidad que se encuentra trabajando en su desarrollo. Además, es el único que soporta los tres tipos de procesamiento de datos, permitiendo el despliegue de una infraestructura basada en Tiers en su totalidad; presenta protección no solo a nivel de nodos, sino también a nivel de discos, así como que soporta el mecanismo Erasure Code (EC) el que permite explotar de forma más eficiente el espacio de almacenamiento. GlusterFS, a pesar de ser un sistema distribuido, posee como aspecto negativo que a la hora de garantizar alta disponibilidad utiliza ineficientemente el espacio en disco creando copias del mismo archivo en todos sus nodos. FreeNAS resalta por ser la única solución con soporte para la deduplicación, y ratifica que su mejor caso de uso es servir como SA para PyME que requieren bajos requerimientos de capacidad de almacenamiento y niveles de tolerancia y recuperación ante fallos no críticos.

3.2.- Evaluación de los rnf de desempeño y disponibilidad

Para hacer una evaluación de los RNF se realizaron las siguientes pruebas de desempeño:

Prueba de Throughput: Es una prueba de microbenchmark que tuvo como objetivo medir el throughput de los discos y del SA en general. Las métricas analizadas fueron: throughput de Lectura y Escritura (L/E) de los discos duros, operaciones por segundo de los discos duros, throughput de L/E del clúster del SA, operaciones por segundo del clúster del SA, y el throughput de la red del SA. Las herramientas empleadas fueron: Fio para medir el throughput y las Operaciones de Entrada y Salida por Segundo (IOPS, In-Out per Second) a los discos y al SA; e Iperf para medir el throughput de la red.

Tabla 3 Soporte de RF por parte de Ceph, GlusterFS y FreeNAS [43-45]

| RF | Tipo | Ceph | GlusterFS | FreeNAS | |

|---|---|---|---|---|---|

| Tipo de procesamiento de datos soportado: | Bloques | Obligatorio | Sí | No | No |

| Ficheros | Recomendable | Sí | Sí | Sí | |

| Objetos | Opcional | Sí | Sí | Sí | |

| Soporte para interoperar con las tecnologías de virtualización: | Virtualización Asistida por Hardware (HVM, |

Obligatorio | Sí | Sí | Sí |

| Virtualización a Nivel de Sistema Operativo (OSLV, |

Obligatorio | Sí | Sí | Sí | |

| Soporte para interoperar con plataformas de orquestación de contenedores: | Kubernets | Opcional | Sí | Sí | Sí |

| Docker Swarm | Opcional | Sí | Sí | Sí | |

| Soporte para la encriptación de datos a nivel de SW: | En reposo | Obligatorio | Sí | Sí | Sí |

| En tránsito | Recomendable | Sí | Sí | Sí | |

| Protección a nivel de: | Discos | Obligatorio | Sí | No | Sí |

| Nodos | Recomendable | Sí | Sí | No | |

| Mecanismos de protección de datos: | Réplicas | Obligatorio | Sí | Sí | No |

| EC | Recomendable | Sí | Sí | No | |

| Arreglo Redundante de Discos Independientes (RAID, |

Opcional | No | Sí | Sí | |

| Chequeo de la integridad de los datos: | Identificación de errores | Obligatorio | Sí | Sí | Sí |

| Recuperación de errores | Obligatorio | Sí | Sí | Sí | |

| Soporte para |

Recomendable | Sí | Si | Sí | |

| Soporte para salvas. | Opcional | Sí | Sí | Sí | |

| Soporte de la deduplicación. | Recomendable | No | No | Sí | |

| Soporte de la compresión de datos. | Obligatorio | Sí | Sí | Sí | |

| Obligatorio | Sí | Sí | Sí | ||

| Soporte de rebalanceo de datos: | Automático | Recomendable | Sí | Sí | Sí |

| Manual | Obligatorio | Sí | Sí | Sí | |

| Soporte de mecanismos de QoS | Recomendable | Sí | No | Sí |

Prueba de Tiempos de Respuesta: Es una prueba de microbenchmark que tuvo como objetivo obtener los tiempos de respuesta para las distintas operaciones realizadas sobre los discos y el SA en general. Las métricas analizadas fueron los tiempos de respuesta de los discos y del SA ante distintos tamaños de bloques de datos. Esta prueba utilizó la misma herramienta Fio que la Prueba de Throughput, con similar configuración. Los resultados, por tanto, fueron emitidos por la herramienta en la misma salida que los datos de la Prueba de Throughput.

Prueba de Utilización de Recursos: Es una prueba de carga que tuvo como objetivo identificar el uso de los recursos de cómputo de los nodos del SA ante E/L aleatorias con varios tamaños de bloques de datos. Las métricas analizadas fueron el porciento de utilización de la Unidad Central de Procesamiento (CPU, Central Processing Unit), de la Memoria de Acceso Aleatorio (RAM, Random Access Memory), la red y la capacidad de almacenamiento. Las herramientas empleadas fueron Fio, Zabbix, Htop y la interfaz de gestión de FreeNAS.

En relación a la disponibilidad solo fueron evaluados los atributos de tolerancia a fallos y recuperación ante fallos, debido a que los SDS se encuentran bajo pruebas y no en producción, por lo que no se cuentan con estadísticas históricas que permitan conocer el porciento de servicio activo (uptime) y el Tiempo Promedio entre Fallos (MTBF, Mean Time Between Failure). La prueba consistió en tres experimentos: a) remover un nodo del sistema y monitorizar el estado, b) reacoplar el nodo removido y ver la capacidad del sistema para reincorporarlo al clúster, y c) comprobar que no se produjesen pérdidas o corrupción de los datos. En el caso de FreeNAS lo que se removió/agregó fue un disco.

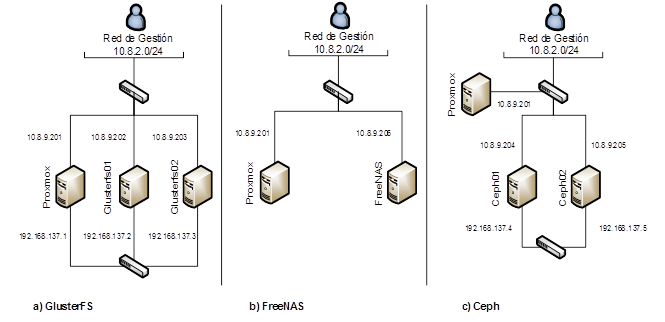

Los escenarios y configuración de las pruebas ejecutadas para GlusterFS, FreeNAS y Ceph se muestran en la Fig. 3. En el “Servidor Proxmox” residen los servicios que hacen uso del SA a través de la red: 10.8.9.0/24. En los casos de GlusterFS y Ceph se emplean dos nodos de almacenamiento para conformar el clúster, el que posee su propia red de gestión: 192.168.137.0/24. FreeNAS no trabaja en clúster, por lo que solo posee un solo nodo de almacenamiento.

La Tabla 4 indica las prestaciones de los nodos de almacenamiento empleados, los que, al poseer recursos limitados, provoca que la configuración de la disponibilidad de las soluciones fuese la mínima. GlusterFS fue configurado en modo de réplica dos [46]. FreeNAS fue configurado con un Vdev en modo espejo [47]. En el caso de Ceph cada disco de datos fue configurado como un Dispositivo de Almacenamiento de Objetos (OSD, Object Storage Device), y en uno de los nodos fue desplegado un monitor, de esta forma si uno de los OSD falla la información se replicará en el otro, garantizando su accesibilidad [48].

Para la interconexión de los dispositivos en los escenarios se utilizó cableado de tipo Par Trenzado no Blindado (UTP, Unshielded Twisted Pair) categoría cinco y dos conmutadores de tipo Cisco Catalyst 2960G-24TC-L Switch cuyo datasheet se encuentra disponible en [49].

La Prueba de Throughput arrojó que FreeNAS demostró mejor throughput que Ceph y GlusterFS, como muestra la Fig. 4. Se considera que este resultado se debe a que el arreglo de discos está conectado directamente a la placa del servidor y no depende de los componentes de la red, a diferencia de los otros dos SDS. Ceph y GlusterFS mostraron un comportamiento similar ante las métricas de throughput e IOPS, como indica la Fig. 4, excepto en las transferencias de archivos pequeños, 4 kB, y en la escritura secuencial en donde Ceph tuvo mejores rendimientos, como se refleja en la Fig. 4b.

Tabla 4 Prestaciones de los nodos de almacenamiento empleados

| Nodos | CPU | RAM | Discos | Interfaces de red utilizadas | Sistema operativo | |||

|---|---|---|---|---|---|---|---|---|

| Cantidad de Discos | Tiempo de uso en horas | |||||||

| Sistema Operativo | Almacenamiento | Sistema Operativo | Almacenamiento | |||||

| ceph01 | Intel(R) Xeon(R) CPU l5420 @ 2.50ghz | 16 GB | 1x160 GB Sata 3 WD | 1x160 GB Sata 3 WD | 73613 | 73561 | 2x 1 GBE | Ubuntu 18.04 live-server |

| ceph02 | Intel(R) Xeon(R) CPU l5420 @ 2.50ghz | 16 GB | 1x160 GB Sata 3 WD | 1x160 GB Sata 3 WD | 73210 | 73597 | 2x 1 GBE | Ubuntu 18.04 live-server |

| glusterfs01 | Intel(R) Xeon(R) CPU l5420 @ 2.50ghz | 16 GB | 1x160 GB Sata 3 WD | 1x160 GB Sata 3 WD | 72862 | 73403 | 2x 1 GBE | Debian 9 (stretch) |

| glusterfs02 | Intel(R) Xeon(R) CPU l5420 @ 2.50ghz | 16 GB | 1x160 GB Sata 3 WD | 1x160 GB Sata 3 WD | 72977 | 72403 | 2x 1 GBE | Debian 9 (stretch) |

| freeNAS | Intel(R) Xeon(R) CPU l5420 @ 2.50ghz | 8 GB | 1x160 GB Sata 3 WD | 2x160 GB Sata 3 WD | 73601 | 72197,71894, | 1x 1 GBE | FreeNAS 11.2-RELEASE-U1 |

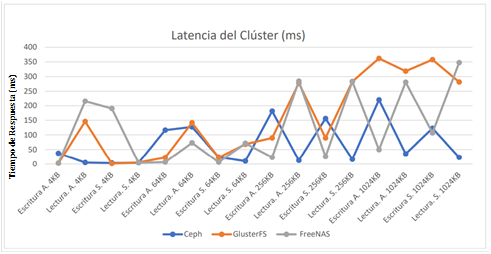

La Fig. 5 muestra los resultados de la prueba de tiempo de respuesta. En la misma se aprecia que Ceph posee los mejores tiempos de respuestas, principalmente a la hora de realizar lecturas y de trabajar con archivos pequeños, 4 kB, reafirmando su buen desempeño con este tipo de archivos, al igual que con los parámetros de IOPS y throughput. También se apreció que a medida que creció el tamaño de los datos las demoras aumentaron, lo que es comprensible porque los sistemas demoran más en el procesamiento de datos más grandes. Por otra parte, con grandes archivos las mayores demoras de Ceph son generadas a la hora de escribir, al contrario de FreeNAS que las posee a la hora de realizar lecturas. GlusterFS fue el que peor desempeño mostró en esta prueba.

La Prueba de Utilización de Recursos fue realizada mediante la generación de las cargas de L/E mostradas en la Tabla 5. Las cargas fueron generadas a cuatro Instancias Virtuales (IV) desplegadas en Proxmox, con sus discos virtuales almacenados en los SDS.

Tabla 5 Cargas generadas en la Prueba de Utilización de Recursos

| Escritura | Lectura | |||

|---|---|---|---|---|

| Instancias Virtuales | Escritura Secuencial | Escritura Aleatoria | Lectura Secuencial | Lectura Aleatoria |

| IV 1 | 20 trabajos a 4KB | 8 trabajos a 4KB | ||

| IV 2 | 8 trabajos a 256KB | 8 trabajos a 1024KB | ||

| IV 3 | 20 trabajos a 4KB | 8 trabajos a 4KB | ||

| IV 4 | 8 trabajos a 256KB | 8 trabajos a 1024KB | ||

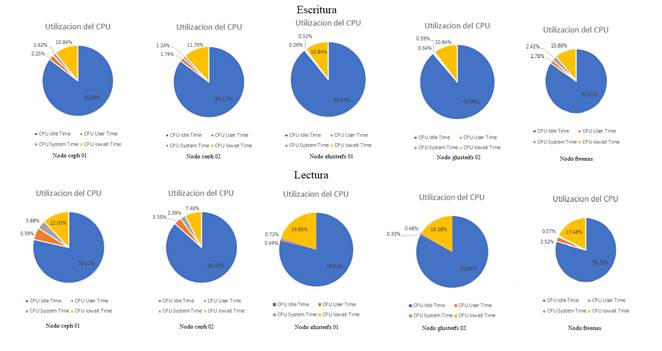

La Tabla 6 muestra los porcientos de utilización percibidos y los valores de throughput e IOPS máximos alcanzados durante la generación de las cargas de L/E mostradas en la Tabla 5. Del análisis de esa tabla se puede concluir que la carga generada a los nodos de almacenamiento puede ser aumentada.

Tabla 6 Índices de utilización, throughput e IOPS percibidos en los SDS ante la generación de cargas de L/E

| Solución | Carga del Clúster | |||

| Escritura | Lectura | IOPS | ||

| Ceph | Valor Máximo | 190 MB/s | 170 MB/s | 10157 |

| % Utilizado | 56.47% | 33.57% | 81.32% | |

| FreeNAS | Valor Máximo | 230 MB/s | 195 MB/s | 8588 |

| % Utilizado | 47.060% | 46.15% | 78.065% | |

| GlusterFS | Valor Máximo | 170 MB/s | 140 MB/s | 9768 |

| % Utilizado | 43.58 % | 40.84% | 84.93% | |

Esta prueba también demostró que los SA no requieren altos requerimientos de CPU. En el caso de la RAM los requerimientos pueden ser mayores, en especial en los procesos de lectura, ya que en la mayoría de los casos es empleada como caché

La Fig. 6 muestra como Ceph ratifica tener los mejores índices de rendimiento al mantener valores similares de iowait en los procesos de L/E. Esto no es así en GlusterFS y FreeNAS los que en los procesos de escritura presentan valores del 10%, mientras que en la lectura son cercanos al 20%.

En el caso de los índices de utilización de las redes de los SA, GlusterFS alcanzó valores cercanos a los 350 Mb/s en los procesos de L/E, a diferencia de FreeNAS con solo 45 Mb/s. Esta diferencia es debido a que GlusterFS utiliza esta red tanto para comunicarse con la plataforma de gestión como para la replicación entre sus nodos, a diferencia de FreeNAS que realiza la replicación localmente en el servidor físico y no emite cargas de este tipo a la red. En el caso de Ceph la red del SA está dividida en dos subredes: la Red del Clúster y la Red del Cliente, demandando mayores recursos de hardware y costos. En las pruebas se pudo constatar, que, en caso de no existir un rebalanceo de carga, los índices de utilización de la Red del Clúster son bajos. En los procesos de L/E se alcanzaron valores de hasta 360 Mbps en la Red del Cliente.

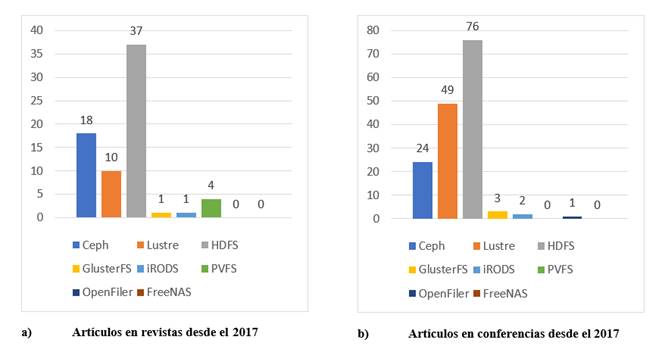

En el caso de la prueba de tolerancia a fallos y recuperación ante fallos en vistas a comprobar la disponibilidad que brindan los SDS, fueron realizadas sumas de verificación, Checksum: cksum, md5sum y sha256sum, a archivos contenidos en los almacenamientos. Posteriormente se provocaron fallas en los servidores, y una vez resueltas se comprobó nuevamente la integridad de los archivos empleando el Checksum. En los tres SDS la prueba resultó exitosa. La Fig. 7 ejemplifica el proceso aplicado a GlusterFS. En la Fig. 7a se muestra el resultado de la Tarea 1, en donde se ilustra el resultado satisfactorio de la suma de verificación de un contenedor de Ubuntu 16 que fue subido en Proxmox y almacenado en GlusterFS. La Figura 7b y 7c muestran los resultados satisfactorios de las Tareas 2 y 3 en lo que se refiere a la remoción y el reacoplamiento de un nodo respectivamente. Finalmente, la Figura 7d muestra los resultados satisfactorios de la Tarea 4 comprobándose que no se producen pérdidas o corrupción de los datos almacenados en el SA lo que demuestra que el sistema posee protección ante fallos a nivel de nodos.

4. Caracterización final de las principales soluciones sds de tipo slca

La Tabla 7 resume los resultados fundamentales obtenidos de las evaluaciones realizadas a Ceph, GlusterFS y FreeNAS en las secciones anteriores.

Tabla 7 Principales resultados de las evaluaciones de Ceph, GlusterFS y FreeNAS

| SISTEMAS DE ALMACENAMIENTO | |||||

|---|---|---|---|---|---|

| REQUERIMIENTOS |

|

|

|

||

| Alta Disponibilidad a nivel de nodo | ✓ |

✓ | x | ||

| Alta Disponibilidad a nivel de disco | ✓ | ✓ | ✓ | ||

| Escalabilidad horizontal | ✓ | ✓ | x | ||

| Alto t |

✓✓ | ✓ | ✓ | ||

| Tolerancia a fallos | ✓ |

✓ |

✓ | ||

| Usabilidad (Soporte de una interfaz gráfica de usuario) | x | x | ✓ | ||

| Eficiencia en el uso de la capacidad de almacenamiento | ✓ |

x | ✓ | ||

| Frecuencia de actualización de las soluciones | ✓ |

✓ | ✓ | ||

| Tipos de procesamiento de datos | Bloques | ✓ | x | ✓ | |

| Ficheros | ✓ | ✓ | ✓ | ||

| Objetos | ✓ | ✓ | x | ||

| Tareas | Virtualización | Contenedores de Linux (LXC, |

✓✓ | ✓ | ✓ |

|

|

✓✓ | ✓ | ✓ | ||

| Alto |

✓✓ | ✓ | ✓✓ | ||

| Salvas | ✓ | ✓✓ | ✓✓ | ||

| Compartición de datos (Ejemplos: documentos, fotos y videos) | ✓ | ✓ | ✓✓ | ||

| DSaaS | ✓ | ✓✓ | ✓✓ | ||

Leyenda:

✓Soportax No Soporta ✓*Sobresale respecto a las demás soluciones ✓✓Elección Recomendada

A partir de estos resultados se realizan las siguientes propuestas:

Para PyME que a corto y a largo plazo solo requieren un nodo de almacenamiento, FreeNAS constituye una solución pertinente, por sus altos índices de desempeño, disponibilidad, interoperabilidad con las diferentes soluciones de virtualización de servidores, facilidad de uso e integración con Proxmox, CMP por excelencia para las PyME que no brinden IaaS.

Para soluciones de SA con más de un nodo, ya sea una infraestructura homogénea o basada en Tiers, Ceph es la solución adecuada debido a su alta disponibilidad, gran tolerancia a fallos, índices de desempeño, eficiencia en el uso del espacio de almacenamiento, interoperabilidad con las tecnologías de virtualización de servidores, soporte de los tres tipos de procesamiento de datos y los diferentes mecanismos para su protección, y sobre todo por la gran comunidad que le respalda, lo que le permite tener una alta frecuencia de actualización e interoperabilidad con los diferentes CMP y otras herramientas de gestión de CD y/o Nube Privada (NP) con soporte para IaaS.

Los resultados obtenidos, por tanto, permiten, al menos en la actualidad y por un periodo de al menos un año o dos, agilizar el diseño de SA para CD virtualizados y NP con soporte para IaaS de PyME.

Dos casos de uso que respaldan la propuesta realizada son el diseño, despliegue y puesta en marcha de los SA de la Universidad Tecnológica de La Habana José Antonio Echeverría (CUJAE) y de la Unidad Científico-Tecnológica de Base (UCTB) de Geofísica de la Unión Cuba-Petróleo (CUPET) [1,13]. Actualmente Ceph se mantiene como el SA de la CUJAE. Ha demostrado ser un SA interoperable, escalable y de alta disponibilidad. Desde su despliegue ha interoperado con dos CMP: OpenNebula y Proxmox, y se le ha incrementado el número de nodos de almacenamiento como muestra la Fig. 8.

En el caso de la CUJAE, el nivel de disponibilidad de Ceph desde su puesta en marcha en el año 2017 hasta el año 2019 es del 99.9% como se muestra en la Fig. 9 donde se puede apreciar que desde su instalación no ha presentado interrupciones.

5. Conclusiones

En el presente trabajo fueron identificadas a Ceph, GlusterFS y FreeNAS, como las principales SDS de tipo SLCA a desplegar en PyME. Ceph resultó ser la solución que mejor QoS ofrece, recibiendo a su vez el mayor soporte por parte de la comunidad de tipo SLCA, por lo que los autores del presente trabajo proponen su empleo en escenarios en donde se requieran alta tolerancia a fallos y mediana o gran capacidad de almacenamiento. A su vez, FreeNAS, para entidades con bajos requerimientos de capacidad y tolerancia a fallos, es considerada la más pertinente por sus índices de desempeño e interoperabilidad con gestores de CDV, así como su facilidad de uso. La caracterización fue realizada teniendo en cuenta los principales RF y RNF de los SA, constituyendo una herramienta que puede ser usada para brindar criterios a la hora de escoger qué tipo de soluciones desplegar en función de los objetivos, requerimientos y restricciones del cliente. La propuesta impacta en: la simplificación y reducción del tiempo de los procesos de diseño de SA, la alineación de los procesos de diseño de SA con los objetivos y requerimientos de la entidad cliente, la independencia tecnológica, y en la factibilidad económica de los proyectos de esta índole.