Mi SciELO

Servicios Personalizados

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista Cubana de Ciencias Informáticas

versión On-line ISSN 2227-1899

Rev cuba cienc informat vol.8 no.4 La Habana oct.-dic. 2014

ARTÍCULO ORIGINAL

Un estudio comparativo sobre evolución diferencial auto-adaptativa en ambientes dinámicos

A comparative study on self-adaptive differential evolution in dynamic environments

Dr. C Pavel Novoa-Hernández1*, Dr. C Carlos Cruz Corona2, Dr. C David A. Pelta2

1 Dpto Lic. Matemática, Universidad de Holguín. Cuba.

2 Departamento de Ciencias de la Computación e Inteligencia Artificial, Universidad de Granada, España.

*Autor para la correspondencia: pnovoa@facinf.uho.edu.cu

RESUMEN

Un gran número de problemas de optimización reales son dinámicos, lo que significa que algunos de los elementos del modelo varían con el tiempo. Estos problemas han recibido un especial interés en los últimos años desde el punto de vista de la optimización mediante metaheurísticas. La Evolución Diferencial (DE) es una metaheurística poblacional que sobresale por su efectividad y fácil implementación. Sin embargo, como la mayoría de los paradigmas aplicados a este contexto, DE ha tenido que ser adaptada con el objetivo resolver principalmente la pérdida de diversidad en la población de soluciones. Por otro lado, la auto-adaptación es uno los enfoques menos tratados en la actualidad, y que ha mostrado ser en extremo eficiente en determinados contextos. La auto-adaptación es una técnica de control de parámetros que dota de cierta inteligencia al algoritmo, durante el proceso de búsqueda. En ese sentido, el presente trabajo investiga dos extensiones auto-adaptativas de DE en combinación con otros enfoques de diversidad existentes. Los resultados, obtenidos a partir de varios experimentos computacionales, confirman que la auto-adaptación es una técnica prometedora en este contexto.

Palabras clave: ambientes dinámicos, auto-adaptación, evolución diferencial.

ABSTRACT

Several real optimization problems are dynamic, meaning that some elements of their mathematical model are time varying. These problems have received a special interest in the last years from the viewpoint of metaheuristics. Differential Evolution (DE) is one of the current population-based metaheuristics with an excellent effectiveness and easy implementation. However, as similar paradigms in dynamic environments, DE has been adapted with aims of solving the diversity loss in the solution population. On the other hand, self-adaptation is one of the less used approaches in dynamic environments, despite its success in complex scenarios. Self-adaptation is a parameter control technique that gives certain intelligent behavior to the algorithm, during the search process. In that sense, the present work investigates the performance of two self-adaptive extensions of DE, which in combination with other existing diversity approaches have been applied in several dynamic scenarios. The obtained results from the computational experiments, confirm that self-adaptation is a promising technique for dynamic environments.

Key words: differential evolution, dynamic environments, self-adaptation.

INTRODUCCIÓN

En la sociedad moderna, varios escenarios de decisión pueden modelarse como problemas dinámicos de optimización (PDOs). Estos problemas tienen como característica la variación en el tiempo de algunos de los elementos del modelo. Ejemplo de estos elementos dinámicos son la función objetivo, el sistema de restricciones, el número de dimensiones del espacio de búsqueda, entre otros. En el presente trabajo se abordarán PDOs en los que la función objetivo varía en el tiempo. En escenarios reales, esta variación de la función objetivo en el tiempo se puede interpretar como un cambio en la información relacionada con el problema en cuestión. Algunos ejemplos donde pueden aparecer este fenómeno son: la automatización del funcionamiento de los semáforos en una ciudad, el aterrizaje de una nave espacial, la distribución de bienes a clientes que aparecen o desaparecen con el tiempo, la planificación de procesos cuyas tareas que aparecen con el tiempo, entre otros.

Para los propósitos de la presente investigación, bastará definir un PDO de la siguiente forma:

![]()

donde ![]() es la función objetivo. En particular, el espacio de búsqueda viene representado por

es la función objetivo. En particular, el espacio de búsqueda viene representado por ![]() , mientras que

, mientras que ![]() es el tiempo.

es el tiempo.

Debido al importante nivel de incertidumbre de estos problemas, la aplicación de técnicas de optimización provenientes de campos como la Soft Computing parece justificarse. Precisamente, en los últimos años este tema ha recibido un especial interés expresado en el creciente número de trabajos tanto de congresos como de revistas (véase por ejemplo las revisiones (Cruz et al., 2011; Nguyen et al., 2012). La tendencia actual en este campo, en relación con la propuesta de nuevos métodos, es el empleo de metaheurísticas (Melián et al., 2003; Talbi, 2009) poblacionales del campo de la optimización estacionaria que son adaptados producto a los retos que impone la optimización dinámica.

Específicamente, estas adaptaciones tienen como objetivo tratar dos dificultades que pueden aparecer producto a los cambios en el ambiente: la desactualización de la información y la pérdida de diversidad. La primera ocurre cuando los valores de la función objetivo (fitness) correspondientes a las soluciones del algoritmo quedan obsoletos. Por su parte, la pérdida de diversidad aparece cuando el algoritmo queda atrapado en una zona del espacio de búsqueda y es incapaz de localizar al nuevo óptimo del problema. Aunque la primera de estas dificultades puede resolverse relativamente fácil (ej. reevaluando la población de soluciones), la segunda es más difícil de tratar. En ese sentido, en los últimos años se han propuesto diferentes enfoques para PDOs que pueden agruparse, según (Jin y Branke, 2005), en cuatro categorías: 1) diversidad después del cambio, 2) diversidad durante la ejecución, 3) enfoques basados en memorias, y 4) enfoques multipoblacionales. Más recientemente, en (Nguyen et al., 2012) se establece que otra forma de lidiar con la dinámica de los PDOs, es aplicar estrategias auto-adaptativas. La auto-adaptación es una técnica de control de parámetros que ha sido ampliamente utilizada en problemas estacionarios (Eiben et al., 2007). En ambientes dinámicos existen, aunque pocos, prometedores trabajos que sugieren la aplicación de esta técnica de control de parámetros (Brest et al., 2009; Novoa-Hernández et al., 2013).

En este contexto, una de las metaheurísticas poblacionales que ha sido aplicado con éxito en ambientes dinámicos es la Evolución Diferencial (DE). Sin embargo, similar a lo que ocurre en otros algoritmos poblacionales, DE sufre de pérdida de diversidad y en consecuencia tiene que ser adaptado a este contexto. Aunque en la actualidad se han logrado importantes avances en esa dirección, se trata de un tema abierto y de constante investigación. En ese sentido, el presente trabajo tiene por objetivo: analizar empíricamente el comportamiento, en términos de precisión, de dos extensiones auto-adaptativas de DE en ambientes dinámicos. Dado que estas extensiones están diseñadas para problemas estacionarios, se hace necesario hibridarlas con algunos enfoques para PDOs. En este caso, se consideraron el enfoque multipoblacional propuesto por (Blackwell y Branke, 2006), y estrategias específicas de diversidad, como las de los trabajos (Blackwell y Branke, 2006) y (Novoa-Hernández, 2011). Nuestra hipótesis es que la auto-adaptación, en conjunto con estos enfoques, puede contribuir significativamente en la solución de PDOs complejos, como los considerados en este trabajo.

El resto de la investigación queda organizada de la forma siguiente. En lo que sigue se exponen los fundamentos teóricos de la metodología computacional desarrollada, así como la descripción de los algoritmos propuestos. Más adelante (Sec. Resultados y discusión), se describirán los experimentos computacionales desarrollados, los cuales concluyen con un análisis estadístico. El trabajo finaliza con las principales conclusiones y trabajos futuros derivados de la investigación.

MATERIALES Y MÉTODOS

La Evolución Diferencial es una metaheurística poblacional propuesta por (Storn y Price, 1997). De manera formal, cada individuo yi de la población se define por la tupla ![]() . Donde

. Donde ![]() es el vector solución y

es el vector solución y ![]() el valor correspondiente de la función objetivo. Como todo algoritmo evolutivo consta de dos etapas generales: inicialización y ciclo principal. En el primero, la población es pseudo-aleatoriamente inicializada en el espacio de búsqueda (ej. siguiendo una distribución uniforme), mientras que en el ciclo principal se generan nuevos individuos (soluciones candidatas) mediante cruzamiento y mutación. La aplicación de estos operadores evolutivos es controlada por el parámetro CR . El operador de reemplazamiento es simple y no depende de una generación (iteración) del algoritmo: si el nuevo individuo es mejor (ej. según el fitness) entonces este reemplaza al individuo que le dio origen. En particular, la mutación depende básicamente del parámetro F conocido como factor de escala. Los principales pasos del esquema original de DE se muestran en la figura 1.

el valor correspondiente de la función objetivo. Como todo algoritmo evolutivo consta de dos etapas generales: inicialización y ciclo principal. En el primero, la población es pseudo-aleatoriamente inicializada en el espacio de búsqueda (ej. siguiendo una distribución uniforme), mientras que en el ciclo principal se generan nuevos individuos (soluciones candidatas) mediante cruzamiento y mutación. La aplicación de estos operadores evolutivos es controlada por el parámetro CR . El operador de reemplazamiento es simple y no depende de una generación (iteración) del algoritmo: si el nuevo individuo es mejor (ej. según el fitness) entonces este reemplaza al individuo que le dio origen. En particular, la mutación depende básicamente del parámetro F conocido como factor de escala. Los principales pasos del esquema original de DE se muestran en la figura 1.

Aquí rand(0,1) es una función que devuelve números aleatorios siguiendo una distribución uniforme en el intervalo [0,0; 1,0]. Asimismo, es importante notar que los resultados de DE en un problema dado, depende principalmente del tamaño de la población, los parámetros F, CR y la estrategia de mutación (paso 8, en la figura 1). En varios trabajos (véase por ejemplo (Das y Suganthan, 2011; Neri y Tirronen, 2010)), se sugiere que los parámetros F y CR se establezcan en 1,0 y 0,1, respectivamente; el tamaño de la población (µ), un valor cercano a 10 veces el número de dimensiones del espacio de búsqueda, mientras que la estrategia de mutación depende del problema en cuestión.

Dentro de las estrategias más conocidas se encuentran las siguientes:

DE/rand/1:

![]()

DE/cur-to-best/1:

![]()

DE/rand-to-best/2:

![]()

DE/current-to-rand/1:

![]()

Aquí, K y Fp son factores de escala que toman valores en tiempo de ejecución en el intervalo [0,1]. Además, Xdbest corresponde a la d-ésima componente de la posición del mejor individuo de la población.

En el contexto de la optimización en ambientes dinámicos, DE ha sido aplicada con éxito en varios contextos. Por ejemplo, la extensión DynDE propuesta por (Mendes y Mohai, 2005) utiliza varias poblaciones que exploran simultáneamente el espacio de búsqueda, lo que la hace muy adecuada para problemas multimodales. Curiosamente, DynDE no requiere el establecimiento de los parámetros F y CR ya que los selecciona en tiempo de ejecución en el intervalo [0,1]. Asimismo, este método incluye técnicas de generación de diversidad mediante la perturbación de uno o más soluciones de la población. DynDE fue aplicada con buenos resultados en el problema test Movimiento de Picos (Branke, 1999). Más recientemente, en la competición Evolutionary Computation in Dynamic and Uncertain Environments (CEC2009), (Brest et al., 2009) proponen una extensión al algoritmo auto-adaptativo jDE que utiliza varias poblaciones y una estrategia basada en la edad de los individuos. Este algoritmo alcanzó el primer lugar en dicha competición. Por otro lado, (Angira y Santosh, 2007) reportan experiencias en entornos reales, en lo que se aplica una versión trigonométrica de DE, con el objetivo de resolver problemas dinámicos en la ingeniería química.

Extensiones auto-adaptativas de la evolución diferencial

El esquema original de DE ha sido satisfactoriamente extendido por varios autores con la intención de mejorar su robustez, esto es, su capacidad de resolver problemas con diferentes características. Dentro de estas extensiones sobresalen las que proponen la auto-adaptación de los parámetros y estrategias que influyen en el comportamiento del algoritmo. La auto-adaptación, como técnica estado-del-arte en el control de parámetros no es originaria de DE. De hecho su historia se remonta al origen de otros paradigmas evolutivos como las Estrategias Evolutivas (Schewefel, 1981), la Programación Evolutiva (Fogel, 1992), y algunas versiones de Algoritmos Genéticos de codificación real (Beyer y Deb, 2001). Básicamente, este técnica consiste en la inclusión, dentro del ciclo evolutivo, de los parámetros más importantes del algoritmo, lo que significa que estos evolucionan al mismo tiempo que el conjunto de soluciones (Eiben et al., 2007).

En relación a DE, existen en la literatura varias propuestas interesantes que incluyen de una forma u otra auto-adaptación. Por ejemplo, SADE (Qin et al., 2005) y SspDE (Pan et al., 2011) aplican auto-adaptación en la selección de la estrategia de mutación, mientras que jDE (Brest et al., 2006), DESAP (Teo, 2006), y SDE (Salman et al., 2007) lo hacen en los parámetros F y CR. Particularmente, DESAP también auto-adapta el tamaño de la población. De manera general, la mayoría de estas extensiones superan en precisión a la versión estándar de DE en problemas estacionarios. En el presente estudio, se han seleccionado específicamente los algoritmos jDE y SspDE,debido a dos razones: por un lado estos algoritmos son, en relación con las otras variantes, los de mejores resultados; y por otro, poseen marcadas diferencias entre sí, lo cual enriquecería las comparaciones. A continuación se describen las ideas básicas de estos algoritmos.

El algoritmo jDE es muy similar al esquema original de DE, la diferencia radica en que los individuos contienen realizaciones de los parámetros F y CR (ej. yi=(xi ,fi , Fi , CRi)).

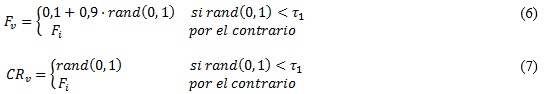

Entonces, en la generación de cada vector donante se utilizan los valores de las expresiones se utilizan los valores de las expresiones (V) y (VI). Si el nuevo individuo es mejor que su padre, en el reemplazamiento se tiene en cuenta también estos valores de Fi y CRi.

Los parámetros r1 y r2 permanecen fijos durante la ejecución y según sus autores deben tomar el mismo valor, esto es, igual a 0,1.

Por su parte, el algoritmo SspDE es una extensión más sofisticada de DE. Los individuos vienen dados como ![]() . Donde Fi y CRi son listas de posibles valores para los parámetros Fi y CRi, respectivamente. Asimismo, Si es un conjunto de varias estrategias de mutación, específicamente instancias de las cuatro definidas por las expresiones (2-5). Los vectores Fi*,CRi*, y Si* son listas de parámetros y estrategias ganadoras, esto es, aquellos valores de Fi,CRi, y Si relacionados con la creación de un vector de mejor calidad que el padre, siendo estas mejoras contadas por la variable wpi. De manera general, todos los vectores poseen una longitud predefinida conocida como período de aprendizaje, denotado por LP. Una vez que este período termina se crean nuevamente las listas de parámetros y estrategias a partir de las listas ganadoras. La idea principal de este método es el aprovechamiento de configuraciones de parámetros y estrategias que resultaron útiles en determinados momentos (ej. cada LP generaciones) para favorecer la optimización en generaciones posteriores. El lector puede encontrar más detalles de este algoritmo en el trabajo original (Pan et al., 2011).

. Donde Fi y CRi son listas de posibles valores para los parámetros Fi y CRi, respectivamente. Asimismo, Si es un conjunto de varias estrategias de mutación, específicamente instancias de las cuatro definidas por las expresiones (2-5). Los vectores Fi*,CRi*, y Si* son listas de parámetros y estrategias ganadoras, esto es, aquellos valores de Fi,CRi, y Si relacionados con la creación de un vector de mejor calidad que el padre, siendo estas mejoras contadas por la variable wpi. De manera general, todos los vectores poseen una longitud predefinida conocida como período de aprendizaje, denotado por LP. Una vez que este período termina se crean nuevamente las listas de parámetros y estrategias a partir de las listas ganadoras. La idea principal de este método es el aprovechamiento de configuraciones de parámetros y estrategias que resultaron útiles en determinados momentos (ej. cada LP generaciones) para favorecer la optimización en generaciones posteriores. El lector puede encontrar más detalles de este algoritmo en el trabajo original (Pan et al., 2011).

Algoritmos propuestos

Como se advirtió anteriormente, los algoritmos que serán objeto de análisis en este trabajo, son hibridaciones de: 1) las extensiones auto-adaptativas jDE y SspDE; y 2) determinados enfoques para PDOs. Específicamente, los enfoques son los siguientes:

- Enfoque multipoblacional (Blackwell y Branke, 2006)

- Enfoque quantum (diversidad durante la ejecución) (Blackwell y Branke, 2006)

- Enfoque diversidad después de los cambios (Novoa-Hernández et al., 2011).

La figura 2 muestra la plantilla general que tendrán los algoritmos, la cual es en esencia el enfoque multipoblacional de (Blackwell y Branke, 2006). Este enfoque, aunque fue propuesto en el contexto de la Optimización con Enjambres de Partículas (PSO), puede ser fácilmente reutilizado empleando otros paradigmas distintos a PSO (ej. jDE y SspDE). Básicamente, este enfoque emplea varias poblaciones independientes (sub-algoritmos), lo que lo hace muy apropiado para problemas multimodales. Las poblaciones son controladas por un operador de exclusión que evita que dos o más poblaciones se encuentren en la misma zona del espacio de búsqueda. Si este fuera el caso, el peor de los enjambres es reiniciado en el espacio de búsqueda. Para determinar cuando ocurre este estado, la distancia euclidiana entre las mejores soluciones de ambas poblaciones tiene que ser menor que un umbral rexcl.

Adicionalmente, este trabajo (Blackwell y Branke, 2006) incluye un enfoque de diversidad durante la ejecución. Dicho enfoque, se basa en la inclusión de individuos (partículas) quantum, las cuales se generan de manera uniforme alrededor de la mejor solución de la población. Estas partículas no poseen un comportamiento convergente, ya que se mantienen explorando en una hiperesfera de radio fijo rcloud.

En relación a la estrategia de diversidad de (Novoa-Hernández et al., 2011), es preciso decir que esta es, en principio, similar a la de las partículas quantum, sin embargo esta estrategia se ejecuta después de cada cambio. Formalmente, después de cada cambio la mitad de la población es reiniciada en una hiperesfera de radio rdiv entorno a la mejor solución.

Es importante señalar algunos aspectos que sobresalen en relación con esta hibridación de DE y ambas estrategias de diversidad. Por ejemplo, cuando se utilizan partículas quantum la población de soluciones tendrá individuos de diferentes tipos (quantum y los correspondientes a la extensión de DE). Esto evidentemente afecta la velocidad de convergencia de las sub-poblaciones por las características de las estrategias de mutación (ej. por la elección aleatoria de individuos de la población). Sin embargo, puede ser un comportamiento deseable en situaciones donde se requiera mantener la diversidad (ej. problemas con frecuencia de cambio muy altas). Por tal motivo, los algoritmos propuestos basados en DE que incluyen individuos de tipo quantum tendrán una población mixta, propiciando así la interacción de sus individuos mediante la estrategia de mutación. En relación con la aplicación de la estrategia de diversidad después del cambio no existen dificultades mayores pues se trata de variar el vector solución de individuos existentes.

En la tabla 1, se listan los algoritmos implementados. Nótese que se ha incluido además, para favorecer la comparación, el algoritmo mQSO (Blackwell y Branke, 2006) al final de la Tabla 1. Asimismo, se ha considerado al algoritmo DE estándar (presente en mR+DE y mQ+DE), como alternativa básica a las extensiones auto-adaptativas. Las extensiones que emplean el enfoque quantum están denotadas con el prefijo mQ, mientras que las que emplean diversidad después del cambio son identificadas por mR.

RESULTADOS Y DISCUSIÓN

En esta sección se exponen los resultados de los experimentos realizados sobre el problema artificial Movimiento de Picos (MPB) (Branke, 1999). Dada su flexibilidad, este problema permite obtener diferentes instancias a partir de las combinaciones de sus parámetros. En la tabla 2 se muestran las configuraciones generales utilizadas en este trabajo y que corresponden a lo que se conoce como escenario 2 de este problema.

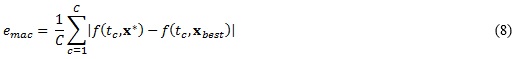

Para medir el comportamiento de los algoritmos, se empleó el promedio del error de la mejor solución antes de cada cambio (emac). Esta medida cuantifica la precisión, en términos del error absoluto del valor de la función objetivo, justo antes de ocurrir un cambio. Formalmente se define como:

donde C son los cambios en el problema, mientras que tc es la última evaluación de la función objetivo antes de la ocurrencia del cambio c. Por otro lado, x* es la posición del óptimo del problema, y xbest es la mejor solución encontrada por el algoritmo.

Los experimentos fueron divididos en dos grupos con la intención de analizar los algoritmos en problemas con características diferentes. En ese sentido, el factor que se tomó en cuenta fue el tipo de función que define a los picos: en el primer grupo se utilizarán funciones unimodales, mientras que en el segundo multimodales. La tabla 3 muestra las definiciones de las funciones seleccionadas. En ambos grupos de experimentos por cada función pico se consideraron varios valores para la frecuencia de los cambios: ![]() y la severidad sev = {1; 5 ;10}. Nótese que a partir de la combinación de estos valores y las funciones pico empleadas, se obtienen 54 instancias de problemas diferentes.

y la severidad sev = {1; 5 ;10}. Nótese que a partir de la combinación de estos valores y las funciones pico empleadas, se obtienen 54 instancias de problemas diferentes.

Todos los algoritmos emplearán 10 sub-poblaciones de 10 individuos cada una, en particular, los algoritmos que utilizan individuos quantum tendrán 5 de este tipo. Además, se empleó la siguiente configuración general: ![]() , mientras que

, mientras que ![]() . Donde

. Donde ![]() es la extensión del espacio de búsqueda. Las extensiones basadas en DE y jDE utilizaron DE/Rand/1 (Expresión (I)) como estrategia de mutación. De manera general se consideraron 20 ejecuciones por cada par problema algoritmo con semillas aleatorias diferentes. Para todos los problemas el número de cambios (C) se estableció en 50, de manera que cada ejecución termina cuando el algoritmo consume

es la extensión del espacio de búsqueda. Las extensiones basadas en DE y jDE utilizaron DE/Rand/1 (Expresión (I)) como estrategia de mutación. De manera general se consideraron 20 ejecuciones por cada par problema algoritmo con semillas aleatorias diferentes. Para todos los problemas el número de cambios (C) se estableció en 50, de manera que cada ejecución termina cuando el algoritmo consume ![]() evaluaciones de la función objetivo.

evaluaciones de la función objetivo.

Los resultados de los experimentos, en términos del promedio del error antes del cambio, y del error estándar, se muestran en las tablas de los Anexos A y B. En el primero, se resume los resultados de los algoritmos en instancias de problema con funciones pico unimodales, mientras que en el segundo se muestran los relacionados con funciones pico multimodales. No obstante la utilidad de esta información descriptiva, se realizaron pruebas estadísticas tomando como base estos resultados, con el objetivo de comparar formalmente a los algoritmos. En particular, hemos seguido la metodología propuesta en (García et al., 2009), la cual sugiere el empleo de pruebas no paramétricas.

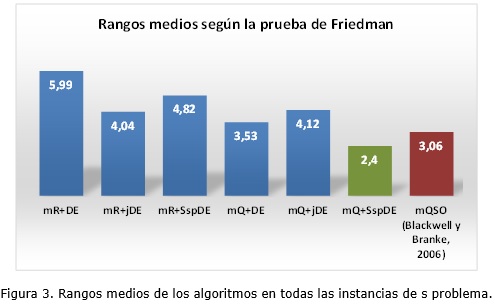

El análisis lo hemos organizado en tres grupos, basados en el tipo de función empleada por las instancias de problema. En los tres casos las pruebas de Friedman e Iman-Davenport dieron p-valores por debajo 0,05. Lo que indica que existen diferencias significativas a nivel de grupo. Como consecuencia, se procedió con pruebas post-hoc, en específico se aplicó la prueba de Holm. La idea de este análisis post-hoc es determinar si el mejor de los algoritmos en cada caso, es diferente o no en relación al resto.

La tabla 4 muestra los rangos (posiciones) medias de los algoritmos en los diferentes grupos, según la prueba de Friedman. Es importante aclarar que un valor bajo del rango medio indica que el algoritmo correspondiente posee un buen comportamiento, en términos del error antes del cambio. Por ejemplo, nótese que en el caso de las funciones unimodales, el mejor algoritmos es el de la literatura, esto es mQSO, el cual obtiene un rango de 1,0. Esta superioridad es significativa en relación al resto de los algoritmos, según lo demuestra la prueba de Holm. Esto último está denotado por el símbolo (*) en la Tabla 4. Asimismo, el peor de los algoritmos en este grupo es mR+DE, con un rango medio de 7,02. Precisamente en esta clase de problema, los algoritmos auto-adaptativos, no muestran buenos resultados en sentido general. A excepción de los que presentan el enfoque quantum, el resto (mR+jDE y mR+SspDE) poseen resultados inferiores incluso al mQ+DE, el cual no posee auto-adaptación. Resulta particularmente clara la ventaja que reporta incorporar el enfoque quantum cuando se resuelve este tipo de problema.

Por otro lado, como se aprecia en la columna relacionada con las funciones multimodales, el algoritmo de mejores resultados es mQ+SspDE. Como sucede en el caso anterior, esta superioridad es significativa en relación al resto de los métodos. Nótese que el algoritmo mQSO, esta vez obtiene un rango medio de 5,12, siendo uno de los de peor resultado. Este tipo de problema resulta más complejo por la naturaleza de las funciones, se requiere por tanto de una mayor generación de diversidad por parte de los algoritmos. Por tal motivo, los algoritmos que incluyen la estrategia de diversidad después de los cambios, mejoran sus resultados en relación al obtenido en el grupo de funciones unimodales. La gran excepción de los algoritmos auto-adaptativos es mQ+jDE, nótese que es el de peores resultados, a juzgar por su rango medio igual a 6,09.

Finalmente, si se tiene en cuenta todas las funciones (última columna de la tabla 4), se puede ver que el mejor algoritmo es mQ+SspDE. Sin embargo, esta superioridad es compartida con el algoritmo de la literatura mQSO, según la prueba de Holm. Por su parte, los de peores resultados son los que presentan la estrategia de diversidad, donde se incluyen algoritmos auto-adaptativos. De manera que se puede concluir que la auto-adaptación, en específico la presentada por el algoritmo SspDE, puede ser beneficiosa en una amplia gama de escenarios dinámicos. Es importante notar que este éxito no se debe exclusivamente al paradigma SspDE, sino también al enfoque quantum con el que se le ha combinado. Este último análisis puede verse mejor en el gráfico de barras de la figura 3.

CONCLUSIONES

En este trabajo se analizó el impacto de la auto-adaptación en la evolución diferencial, en el contexto de la resolución de problemas dinámicos de optimización. Específicamente, se consideraron dos variantes auto-adaptativas de dicha metaheurística, que fueron hibridadas con el enfoque multipoblacional de (Blackwell y Branke, 2006), y otros dos, relacionados con la generación de diversidad: enfoque quantum (Blackwell y Branke, 2006), y diversidad después de los cambios (Novoa-Hernández et al., 2011). A partir de los resultados en diferentes instancias de problemas, se puede concluir que los beneficios de la auto-adaptación son en cierta medida limitados. Aunque el algoritmo más robusto resultó ser precisamente uno con auto-adaptación, esta superioridad no fue significativa en relación al exponente de la literatura. Asimismo, dicha superioridad se debe también en parte al enfoque de diversidad empleado. No obstante, estos resultados indican que la auto-adaptación, en combinación con otros enfoques de adaptación, deriva en algoritmos más precisos, al menos para los problemas y medida considerados.

Una alternativa a esta forma de aplicar auto-adaptación en ambientes dinámicos es, en lugar de emplear un paradigma auto-adaptativo (como jDE o SspDE), es incluir algún modelo auto-adaptativo directamente a enfoques específicos para PDO. Nuestros trabajos futuros estarán enfocados a esta cuestión.

AGRADECIMIENTOS

Los autores agradecen a los revisores del artículo por sus sugerencias y correcciones, los cuales contribuyeron en la calidad del mismo.

C. Cruz y D. Pelta agradecen el apoyo del Ministerio de Economía y Competitividad, España, a través del proyecto TIN2011-27696-C02-01; y a la Consejería de Innovación, Ciencia y Empresa, Junta de Andalucía, a través del proyecto P11-TIC-8001 (incluyendo fondos FEDER), y a la Universidad de Granada a través del proyecto GENIL-PYR-2014-9.

ANEXOS

A. Resultados de los algoritmos en instancias de problema con funciones pico multimodales. La tabla muestra el promedio del error de la mejor solución antes del cambio ± error estándar.(ver tabla 5)

B. Resultados de los algoritmos en instancias de problema con funciones pico multimodales. La tabla muestra el promedio del error de la mejor solución antes del cambio ± error estándar.(ver tabla 6)

REFERENCIAS BIBLIOGRÁFICAS

ANGIRA R.; SANTOSH, A. Optimization of dynamic systems: a trigonometric differential evolution approach. Comput. Chem. Eng., 2007, 31:1055-1063.

BEYER, H.-G.; DEB, K. On self-adaptive features in real-parameter evolutionary algorithms. IEEE Transactions on Evolutionary Computation, 2001, 5(3): p. 250-270.

BLACKWELL, T., BRANKE, J. Multiswarms, exclusion, and anti-convergence in dynamic environments. IEEE Transactions on Evolutionary Computation, 2006, 10(4): p. 459-472.

BRANKE, J. Memory enhanced evolutionary algorithms for changing optimization problems. Proceedings of the Congress on Evolutionary Computation, volume 3, pages 1875-1882, Mayower Hotel, Washington D.C., USA, IEEE Press , 1999, 6-9.

BREST, J.; GREINER, S.; BOSKOVIC, M.; MERNIK, B.; ZUMER, V. Self-adapting control parameters in differential evolution: a comparative study on numerical benchmark problems. IEEE Transactions on Evolutionary Computation, 2006, 10(6): p. 646-657.

BREST J, ZAMUDA A, BOSKOVIC B, MAUCEC M.S, ZUMER V Dynamic optimization using self-adaptive differential evolution. Proceedings of the Eleventh conference on Congress on Evolutionary Computation, CEC’2009, IEEE Press, Piscataway, NJ, USA, 2009, p. 415-422.

CRUZ, C.; GONZÁLEZ, J. R.; PELTA, D. Optimization in dynamic environments: a survey on problems, methods and measures. Soft Computing, 2011, 15(7): p. 1427-1448.

DAS, S.; SUGANTHAN, P. N. Differential evolution a survey of the state-of-the-art. IEEE Transactions on Evolutionary Computation, 2011, 15(1): p. 4-31.

EIBEN, A.; MICHALEWICZ, Z.; SCHOENAUER, M.; SMITH, J. Parameter control in evolutionary algorithms. Parameter Setting in Evolutionary Algorithms, volume 54 of Studies in Computational Intelligence, 2007, p. 19-46. Springer Berlin / Heidelberg.

FOGEL, D.B. An analysis of evolutionary programming. First Annual Conference on Evolutionary Programming, 1992, p 43-51.

GARCIA, S.; MOLINA, D.; LOZANO, M.; HERRERA, F. A study on the use of non-parametric tests for analyzing the evolutionary algorithms behaviour: a case study on the cec2005 special session on real parameter optimization. J Heuristics, 2009, 15: p. 617-644.

LI, C.; YANG, S.; NGUYEN, T. T.; YU, E. L.; YAO, X.; JIN, Y.; BEYER, H.-G. & SUGANTHAN, P. N. Benchmark Generator for CEC’2009 Competition on Dynamic Optimization. Department of Computer Science, University of Leicester, U.K., 2008.

MELIÁN, B.; MORENO PÉREZ, J.; MORENO VEGA, J. Metaheurísticas: Una visión global. Revista Iberoamericana de Inteligencia Artificial, 2003, 19: p. 7-28.

MENDES, R.; MOHAIS, A. S. DynDE: A differential evolution for dynamic optimization problems. Proceedings of the IEEE Congress on Evolutionary Computation, 2005, 2, p. 2808-2815.

NERI, F.; TIRRONEN, V. Recent advances in differential evolution: a survey and experimental analysis. Artificial Intelligence Review, 2010, 33: p. 61-106.

NGUYEN, T. T.; YANG, S.; BRANKE, J. Evolutionary dynamic optimization: A survey of the state of the art. Swarm and Evolutionary Computation 2012, 6: p. 1-24.

NOVOA-HERNÁNDEZ, P.; CRUZ CORONA, C.; PELTA, D. A. Self-adaptive, multipopulation differential evolution in dynamic environments. Soft Computing, 2013, 17(10): p. 1861-1881.

NOVOA-HERNÁNDEZ, P.; CRUZ CORONA, C.; PELTA, D. Efficient multi-swarm PSO algorithms for dynamic environments. Memetic Computing, Springer Berlin / Heidelberg, 2011, 3(3): p. 163-174.

PAN, Q.-K.; SUGANTHAN, P.; WANG, L.; GAO, L.; MALLIPEDDI, R. A differential evolution algorithm with self-adapting strategy and control parameters. Computers & Operations Research, 2011, 38: p. 394-408.

QIN, A.; SUGANTHAN, P. Self-adaptive differential evolution algorithm for numerical optimization. IEEE Congress on evolutionary computation, CEC2005, 2005, p. 1785-1791.

SALMAN, A.; ENGELBRECHT, A.; OMRAN, M. Empirical analysis of self-adaptive differential evolution. European Journal of Operational Research, 2007, 183(2):785-804.

SCHWEFEL, H.-P. Numerical Optimization of Computer Models John Wiley, Chichester, UK, 1981.

SMITH, J. Self-adaptation in evolutionary algorithms for combinatorial optimisation. Studies in Computational Intelligence, 2008, 136: p. 31-57.

STORN, R.; PRICE, K. Differential evolution-a simple and efficient heuristic for global optimization over continuous spaces. Journal of Global Optimization, 1997, 11:34-359.

TALBI, E.-G. Metaheuristics: from design to implementation. John Wiley and Sons, 2009, 593 p.

TEO, J. Exploring dynamic self-adaptive populations in differential evolution. Soft Computing, 2006, 10(8):673-686.

Recibido: 19/03/2014

Aceptado: 5/06/2014